Wann man welches LLM einsetzen sollte – eine kompakte, praxisnahe Übersicht

Große Sprachmodelle sind keine Schweizer Taschenmesser, eher ein Werkzeugkoffer: Für jede Aufgabe gibt es Modelle, die bessere Qualität, geringere Latenz oder bessere Kosten liefern. Die Kunst ist das passende Trio aus Modellgröße, Architektur und Betriebsform zu wählen – plus eine robuste Einbettung (RAG, Tool‑Use, Guardrails).

Entscheidende Auswahlkriterien

- Aufgabencharakter

- Wissensgenerierung vs. Wissensabruf (RAG)

- Strukturierte Planung/Reasoning vs. schnelle Konversation

- Kreativstil vs. präzise Sachlichkeit mit Zitaten

- Qualität vs. Kosten vs. Latenz

- Premium-Modelle für knifflige, risikobehaftete Aufgaben

- Mid/Small-Modelle für hohe Volumina, SLAs und Edge/On‑Prem

- Kontextbedarf

- Sehr lange Kontexte (lange PDFs/Wikis) → Modelle mit großem Kontextfenster

- Tool‑Use/Agentik

- Solide Funktion-Aufrufe (APIs, Websuche, Kalender, CRM) und Planungskompetenz

- Mehrsprachigkeit

- Deutschqualität, Stilkontrolle, Korrektheit von Formulierungen

- Sicherheit, Datenschutz, Compliance

- EU-Datenverarbeitung, PII-Redaktion, Auditierbarkeit

- Steuerbarkeit

- Systemprompt-Folgsamkeit, niedrige Halluzinationsneigung, deterministische Modi

Modell-Landschaft im Schnelldurchlauf

Modellfamilie | Stärken | Schwächen | Kontext | Tool‑Use | Kostenklasse | EU/On‑Prem-Option |

|---|

| OpenAI GPT‑4o / GPT‑4.1 | Sehr starke Allrounder, Tool‑Use/Code, gute Deutschqualität | Premiumkosten | Groß | Ausgereift | Premium | Cloud (EU‑Compliance je nach Setup) |

| OpenAI GPT‑4o‑mini | Sehr kosteneffizient, flink | Etwas schwächeres Reasoning | Groß | Gut | Günstig | Cloud |

| Anthropic Claude 3.5 Sonnet | Starkes Reasoning, lange Kontexte, angenehmer Stil | Premiumkosten | Sehr groß | Gut | Premium | Cloud |

| Anthropic Claude 3.5 Haiku | Schnell, günstig | Weniger tiefes Reasoning | Groß | Gut | Günstig | Cloud |

| Google Gemini 1.5 Pro | Extrem große Kontexte, Multimodal | API/Ökosystem teils anders | Sehr groß | Gut | Premium | Cloud |

| Mistral Large | Solide EU‑Anbieter, gute Kosten/Leistung | Knapp unter Top‑Tier | Groß | Gut | Mittel | Teilw. EU/On‑Prem |

| Llama 3.1 (70B/8B) | Open‑Source, fein anpassbar, On‑Prem möglich | Bedarf an guter RAG/Prompting | Variabel | Variabel | Günstig bis mittel | On‑Prem möglich |

| Cohere Command R / R+ | RAG‑stark, Business‑Fokus | Weniger bekannt als Big‑3 | Groß | Gut | Mittel | Cloud |

| Aleph Alpha (Luminous) | EU‑Fokus, On‑Prem/Private Cloud | Modellgröße vs. Top‑Tier | Mittel | Gut | Mittel | Stark in EU/On‑Prem |

Hinweis: Preise/Limits ändern sich oft; hier geht’s um Profile, nicht Tarife.

Muster: Welche Aufgaben passen zu welchen Modellen?

- Komplexes, faktenlastiges Denken (Planen, Korrigieren, Zitieren)

- Premium (GPT‑4.1, Claude 3.5 Sonnet, Gemini 1.5 Pro)

- Hohe Volumina, geringe Latenz, Standardaufgaben

- Mid/Small (GPT‑4o‑mini, Claude Haiku, Mistral Small/Medium, Llama 3.1 8B/70B)

- Sehr lange Dokumente, viele Anhänge

- Gemini 1.5 Pro, Claude 3.5 Sonnet; alternativ RAG mit Re‑Ranking

- Strikte EU‑Datenhoheit/On‑Prem

- Mistral (Self‑Hosted), Llama 3.1 (Self‑Hosted), Aleph Alpha

- Chatbots/FAQ mit Unternehmenswissen (RAG)

- Praktisch jedes verlässliche Modell + gute RAG-Pipeline; Mid-Modelle oft ideal

- Kreativstil (Marketing, Varianten)

- GPT‑4o/4.1, Claude 3.5 Sonnet; Budget: GPT‑4o‑mini/Claude Haiku

Architektur-Bausteine, die wichtiger sind als das „größere Modell“

- Retrieval-Augmented Generation (RAG)

- Sauberes Chunking, starke Embeddings (bge‑m3 o. ä.), Cross‑Encoder Re‑Ranking

- Tool‑Use

- Websuche/Browser, Kalender/CRM, Datenbanken, Fact‑Check‑Routinen

- Guardrails & Policy

- PII‑Redaktion, Tonalitätsregeln, Blacklists/Whitelists, Output‑Filter

- Caching & Kostenkontrolle

- Prompt‑ und Antwort‑Cache, Antwortvorlagen, Stufenmodell (Small→Large only on need)

- Beobachtbarkeit & Evaluation

- Halluzinationsraten, Antwortlatenz, Klick‑/Konvertierungsrahrate, menschliches Review

Robustheit gegen Halluzinationen

- Quellenpflicht: „Jede Tatsachenbehauptung mit URL + Datum“ (News/RAG)

- Claim‑Checker‑Pass: Zweites, schnelles Modell prüft Aussagen stichprobenartig

- Abstinenz‑Regel: „Wenn unsicher, nachfragen oder neutral formulieren“

- Self‑Consistency / n‑Best: Mehrere Entwürfe, Ranking via Re‑Ranker

Praktische Prompt-/Systemvorlagen

- Systemprompt (News/Recherche)

- „Du bist ein faktenstrenger Redakteur. Jede Aussage muss durch mind. 2 Quellen gestützt sein; gib Zitate/URLs mit Datum aus. Keine Spekulation. Wenn unklar, markiere als unbestätigt.“

- Systemprompt (E‑Mail‑Agent)

- „Du bist ein höflicher deutschsprachiger Korrespondenz‑Assistent. Halte Firmenstilvorgaben ein, fasse Entscheidungen nicht ohne Freigabe. Erkenne Absichten (Support, Verkauf, Termin) und ziehe Vorlagen/CRM‑Daten heran.“

- Systemprompt (Web‑Chatbot mit RAG)

- „Antworte ausschließlich auf Basis der bereitgestellten Wissensquellen. Wenn eine Info fehlt, signalisiere ‚nicht vorhanden‘ und biete eine Kontaktoption an. Verlinke relevante Abschnitte.“

Konkrete Empfehlungen für Ihre drei Vorhaben

Im Zweifel setze auf ein zweistufiges Setup: schnelles, günstiges Modell für 80% der Fälle; automatisches Upgrade auf ein Premium‑Modell für komplexe oder unsichere Fälle. So bleiben Kosten planbar und Qualität stabil.

1) Generierung von News mit Internet‑Recherche

- Empfohlene Pipeline

- Planner (kleines Modell) erstellt Suchplan und Queries

- Websuche + Dedup + Extraktion (Reader)

- Faktenabgleich + Quellenbewertung

- Hauptmodell schreibt zusammenfassend mit Zitaten und Zeitstempeln

- Modellwahl

- Premium: OpenAI GPT‑4.1 oder Anthropic Claude 3.5 Sonnet für das Schreiben/Prüfen

- Kostenoptimiert: OpenAI GPT‑4o‑mini für Recherche/Planung, Upgrade bei Unsicherheit

- Lange Kontexte (viele Quellen gleichzeitig): Google Gemini 1.5 Pro

- EU/On‑Prem: Mistral Large oder Llama 3.1 70B + starke RAG/Claim‑Checker

- Extra-Tipps

- Erzwinge Quellenformat: [Autor/Medium] – Titel – URL – Abrufdatum

- Vermeide „neue Fakten“ ohne Link; nutze Markierungen wie „(unbestätigt)“

2) Automatisches Beantworten von E‑Mails

- Typischer Flow

- Intent‑/Dringlichkeitserkennung → Policy/Template‑Auswahl → Entwurf → optionaler Review → Versand

- Modellwahl

- Hauptarbeit: OpenAI GPT‑4o‑mini oder Anthropic Claude 3.5 Haiku (schnell, günstig, guter Stil auf Deutsch)

- Eskalation bei komplexen Fällen: GPT‑4o oder Claude 3.5 Sonnet

- Strikte EU/On‑Prem: Llama 3.1 8B/70B oder Mistral Medium/Large mit firmeneigenen Vorlagen

- Extra-Tipps

- Einheitliche Tonalität via Style‑Guides/Few‑Shots

- PII‑Redaktion und Haftungshinweis automatisieren

- SLA: Ziel First‑Token < 500 ms, Gesamt < 2–5 s

3) Webseiten‑Chatbot (FAQ/Support/Vertrieb) mit eigenem Wissen

- Architektur

- RAG mit Vektor‑DB (z. B. Qdrant/Weaviate), Re‑Ranking, Zitierpflicht

- Intent‑Router (Support, Sales, Termin) + Funktion‑Aufrufe

- Modellwahl

- Kosten/Latency‑Sweet‑Spot: OpenAI GPT‑4o‑mini als Default

- Schwerere Fragen/Mehrschritt‑Reasoning: Auto‑Upgrade auf GPT‑4o oder Claude 3.5 Sonnet

- Sehr lange PDFs/Wissensbasen: Gemini 1.5 Pro

- EU/On‑Prem strikt: Llama 3.1 8B/70B oder Mistral Large, ggf. Aleph Alpha für sensitive Domänen

- Extra-Tipps

- „Nur aus Quellen antworten“-Regel, mit klarer Fallback‑Antwort

- Analytics: Antwortabdeckung, Eskalationsquote, Nutzerzufriedenheit

Minimal‑Startkonfigurationen (Beispiel-Prompts)

- News (Head prompt)

- „Ziel: Tageszusammenfassung zu [Thema] für deutschsprachiges Publikum. Schritte: (1) Query‑Plan, (2) Top‑Quellen finden, (3) Fakten extrahieren, (4) Zusammenfassen mit Zitaten. Jede Behauptung erhält mindestens eine URL und Datum.“

- E‑Mails (Style Few‑Shots)

- 3–5 Beispielantworten mit gewünschtem Ton (freundlich, prägnant, Sie‑Form), plus Policy: „keine verbindlichen Zusagen ohne Freigabe“.

- Web‑Chatbot (RAG Guardrail)

- „Antworte nur basierend auf bereitgestellten Passagen. Wenn unklar oder fehlend: ‚Dazu liegen mir keine verlässlichen Informationen vor.‘ Schlage Alternativen oder Kontakt vor.“

Kurzfazit: konkrete Modell‑Tipps

- News mit Web‑Recherche

- Premium: GPT‑4.1 oder Claude 3.5 Sonnet als Schreib-/Faktenmodell

- Budget/Speed: GPT‑4o‑mini für Planung/Suche; Auto‑Upgrade bei Unsicherheit

- Viel Kontext: Gemini 1.5 Pro

- EU/On‑Prem: Mistral Large oder Llama 3.1 70B + robuste RAG/Claim‑Checker

- Automatische E‑Mail‑Antworten

- Default: GPT‑4o‑mini oder Claude 3.5 Haiku

- Eskalation: GPT‑4o oder Claude 3.5 Sonnet

- On‑Prem/EU‑streng: Llama 3.1 8B/70B oder Mistral Medium/Large

- Webseiten‑Chatbot

- Default: GPT‑4o‑mini mit RAG und Zitierpflicht

- Schwerfälle: GPT‑4o oder Claude 3.5 Sonnet

- Lange Dokumente: Gemini 1.5 Pro

- EU/On‑Prem: Llama 3.1 8B/70B oder Mistral Large; optional Aleph Alpha für sensible Inhalte

Damit haben Sie einen belastbaren Startpunkt: klar getrennte Qualitätsstufen, Tool‑Use/RAG als Fundament und konkrete Modellvorschläge je Aufgabe.

KI-Plattformen im Vergleich 2025: mammouth.ai vs. OpenRouter vs. Logicc

Die Auswahl der richtigen KI-Plattform entscheidet heute über Effizienz, Kostenkontrolle und Datenschutz.

Ich habe drei führende Anbieter – mammouth.ai, OpenRouter.ai und Logicc.com – einem praxisnahen Vergleich unterzogen. Hier erfährst du, welche Lösung sich für deinen Anwendungsfall lohnt.

Überblick

| Anbieter | Fokus | Preismodell | Ideal für |

|---|---|---|---|

| mammouth.ai | All-in-One-App & API-Gateway | Abo (ab 10 €/Monat) + API-Preise pro Token | Einzelanwender, kleine Teams |

| OpenRouter.ai | Multi-Provider-Gateway | Nutzungsbasiert (pro Token, +5 % Fee) | Entwickler, SaaS-Projekte |

| Logicc.com | EU-Plattform mit Datenschutz-Fokus | Feste Seats ab 19,90 €/Monat | Unternehmen, Behörden |

Preisvergleich

mammouth.ai

App-Abo: 10 €/Monat pro Nutzer

API-Zugriff: GPT-4o ab $2,50/M Input, $10/M Output

Ideal für: Anwender, die viele Top-Modelle testen möchten, ohne separate Logins oder API-Keys.

OpenRouter.ai

Pay-per-Use: gleiche Modellpreise wie bei OpenAI, Anthropic, Mistral etc.

Plattformgebühr: ~5 % pro Aufladung

Ideal für: Entwickler, die flexibel zwischen Modellen wechseln wollen und volle Kostenkontrolle brauchen.

Logicc.com

Feste Lizenzen:

Plus: 19,90 €/Monat

Pro: 21,90 €/Monat

Pro Secure: 34,90 €/Monat

EU-Hosting, DSGVO-konform, kein Token-Metering

Ideal für: Teams mit Compliance- und Sicherheitsanforderungen.

Leistung & Funktionen

| Kriterium | mammouth.ai | OpenRouter.ai | Logicc.com |

|---|---|---|---|

| Modellauswahl | GPT-4o, Claude, Mistral, Gemini, uvm. | >100 Modelle | Smart-Select-KI (modellunabhängig) |

| Latenz | Edge-Betrieb, gering | ~25 ms Overhead | EU-Server |

| Datenschutz | Zero Data Retention, GDPR-konform | Datenschutz nach Provider | EU-Computing, DSGVO, §203 StGB |

| API-Zugriff | OpenAI-kompatibel | OpenAI-kompatibel | Auf Anfrage |

| Kollaboration | Projekte & Teams | Multi-User nur via API | Assistenten, Teamräume, SSO |

Entscheidungsmatrix (Kurzfassung)

| Plattform | Gesamtscore (1–5) | Stärken | Schwächen |

|---|---|---|---|

| mammouth.ai | ⭐ 4,4 | Preis-Leistung, einfache Nutzung, Multi-Model-UI | Eingeschränkte Team-Funktionen |

| OpenRouter.ai | ⭐ 4,3 | Flexibilität, Entwickler-API, Latenz | Weniger Endnutzer-Komfort |

| Logicc.com | ⭐ 4,0 | Datenschutz, Team-Kollaboration | Weniger API-Fokus, höhere Seat-Kosten |

🔸 Gesamtscores basieren auf gewichteter Bewertung von Preis, Leistung, Datenschutz, API-Funktionalität und Teamfähigkeit.

Fazit: Welche Plattform passt zu dir?

Für Startups & Creator:

👉 mammouth.ai bietet das beste Preis-Leistungs-Verhältnis für schnelles Arbeiten mit Top-Modellen.Für Entwickler & SaaS-Teams:

👉 OpenRouter.ai ist unschlagbar bei API-Flexibilität, Routing-Performance und Modellvielfalt.Für Unternehmen & Bildungseinrichtungen:

👉 Logicc.com überzeugt mit EU-Hosting, DSGVO-Konformität und kollaborativen Workspaces.

Bonus: Entscheidungsmatrix als Download

Hier klicken, um die Excel-Matrix herunterzuladen

Schlusswort

KI-Plattformen entwickeln sich rasant – und die optimale Wahl hängt davon ab, ob du eher Entwicklung, Content-Produktion oder Datenschutz priorisierst.

Mit dieser Analyse hast du die Fakten, um 2025 die richtige Entscheidung zu treffen.

Mammouth vs. OpenRouter - LLM Gateways im Vergleich

Mammouth – ein 2024 gegründetes, Französisches Startup – ist ein relativ neuer Anbieter, der über eine Weboberfläche und API Zugang zu einer Vielzahl führender KI-Modelle bietet – darunter GPT‑5, Claude, Gemini, Mistral, Grok, DeepSeek, LLaMA, Perplexity und weitere – für eine monatliche Pauschale von nur 10 Euro. Jedes Modell kann zusätzlich auch einzeln genutzt werden (meist zwischen 15–30 Euro pro Modell/Monat).

Im Vergleich dazu nutzt OpenRouter ein Guthaben- bzw. Kredit-basiertes System, wobei man den Verbrauch (Token/Kosten pro Anfrage) selbst zahlt. OpenRouter erhebt typischerweise rund 5% Gebühren auf jede Nutzung, ermöglicht aber kostenlose oder zeitweise stark reduzierte Modelle (z.B. DeepSeek V30324 oder Wizard 8x22b). Zudem bietet OpenRouter weltweit verteilte Router-Server, Ausfallschutz, API-Standardisierung und Smart Routing, wodurch Anfragen automatisch auf den günstigsten oder schnellsten Anbieter gelenkt werden.

Preislich ist Mammouth.ai pauschal betrachtet günstiger, wenn man mehrere Modelle regelmäßig nutzt: Für 10 Euro im Monat erhält man unbegrenzten Zugriff auf viele Modelle gleichzeitig. OpenRouter kann aber günstiger sein, wenn du nur ein Modell selektiv oder mit niedriger Nutzung einsetzt, da die Zahlung verbrauchsabhängig erfolgt und manche Modelle dort sogar kostenlos verfügbar sind.

Kurz gesagt:

- Mammouth.ai ist günstiger für Vielnutzer (Flat-Rate, 10 €/Monat).

- OpenRouter ist flexibler und leistungsfähiger (Pay‑per‑Use, Multi‑Provider‑Routing), kann aber auf Dauer teurer werden.

Mammouth AI

ist eine französische KI-Plattform, die seit 2024 besteht und sich auf den erschwinglichen, zentralisierten Zugang zu führenden Sprach- und Bildmodellen spezialisiert hat. Das Unternehmen sollte nicht mit Mammoth-AI (aus den USA) verwechselt werden, da es sich um zwei verschiedene Firmen handelt.

Überblick

Mammouth AI wurde 2024 in Paris gegründet. Es handelt sich um eine abonnementbasierte Plattform, die den Zugang zu mehreren generativen KI-Modellen wie GPT‑4o, Claude, Gemini, Llama, Mistral, Midjourney, Stable Diffusion, DALL‑E3, FLUX und weiteren bündelt – alles zu einem monatlichen Preis von etwa 10€.

Hauptfunktionen

- Multi‑Model‑Zugriff: Nutzer können innerhalb einer Oberfläche zwischen führenden Sprach‑ und Bild‑KI‑Modellen wechseln und Ausgaben vergleichen.

- One‑Click‑Reprompting: Wiederverwendung und Vergleich derselben Prompts in verschiedenen Modellen ohne die Plattform zu verlassen.

- Projekt‑Mammouths: Möglichkeit, Projekte, Dateien und benutzerdefinierte Anweisungen thematisch zu organisieren, um kontextbezogene KI‑Assistenten zu schaffen.

- Upload‑Funktionen: Hochladen von Bildern und Dokumenten für Analyse, Zusammenfassungen und Informationen durch KI.

- Mehrsprachigkeit: Unterstützung mehrerer Sprachen für Textgenerierung und Interaktion.

- Synchronisierung und Multiplattform‑Zugriff: Verwendung auf Desktop, Android und iPhone mit synchronisierter Chat‑Historie.

Zielsetzung und Philosophie

Mammouth AI verfolgt das Ziel, modernste KI‑Modelle für alle zugänglich zu machen, indem es verschiedene Dienste in einem kostengünstigen Abonnement vereint. Das Symbol des „Mammuts“ steht dabei metaphorisch für Anpassung und Weiterentwicklung in einer schnelllebigen Technologieumgebung – ein Aufruf, nicht „auszusterben“, sondern mit der Innovation Schritt zu halten.

Datenschutz

Mammouth AI unterliegt strengen europäischen Datenschutzstandards (DSGVO) und legt Wert auf Datensicherheit, Transparenz und begrenzte Datenspeicherung. Nach eigenen Angaben werden Nutzerdaten ausschließlich zur Bereitstellung ihrer Dienste verwendet und nicht zur Modellschulung oder zu Werbezwecken weitergegeben.

Datenschutzrichtlinien

- Keine Nutzung für KI-Training: Nutzereingaben (Prompts) werden ausschließlich zur Darstellung früherer Konversationen oder zur Nutzerunterstützung gespeichert, aber nicht zum Training von KI-Modellen verwendet.

- Datenspeicherung:

– Promptdaten werden maximal 30 Tage nach Löschung eines Kontos aufbewahrt, um Missbrauch zu verhindern. - Accountdaten (Name, E-Mail, Zahlungsinformationen) bleiben bis ein Jahr nach Vertragsende zu Nachweiszwecken erhalten.

- Sicherheitslogs werden bis zu ein Jahr gespeichert.

- Zweckbindung: Erhobene Daten (Nutzungs‑, Konto‑, Sicherheits‑ und Kommunikationsdaten) werden ausschließlich zur Serviceverbesserung, Betrugsprävention und Support verwendet.

- Rechtsgrundlage: Verarbeitung gemäß Art. 6 DSGVO; Nutzer haben gem. Art. 15–20 DSGVO Rechte auf Auskunft, Berichtigung, Löschung und Widerspruch.

Sicherheitspraktiken

- Verschlüsselung & Zugriffsbeschränkung: Datenübertragung und ‑speicherung erfolgen mithilfe aktueller Verschlüsselungsstandards, um unbefugte Zugriffe zu verhindern.

- Rollenspezifische Zugriffskontrollen: Nur autorisierte Mitarbeitende mit notwendigem Zweck erhalten Zugriff auf personenbezogene Daten.

- Logging und Missbrauchsüberwachung: Sicherheitsprotokolle werden geführt, um ungewöhnliche Aktivitäten zu erkennen und Angriffe zu verhindern.

- Kein Datenexport: Alle Daten werden innerhalb der EU‑Serverinfrastruktur verarbeitet, wodurch die DSGVO‑Konformität gewährleistet bleibt.

Monetarisierung und Transparenz

Mammouth AI finanziert sich ausschließlich über Abonnements und verkauft oder teilt keine Nutzerdaten; es erfolgen keine Werbe‑ oder Trackingmaßnahmen Dritter.

Fazit

Mammouth AI setzt auf datenschutzfreundliche Architektur nach europäischem Standard, kombiniert transparente Datennutzung mit minimierter Speicherdauer und technischer Zugriffssicherheit. Nutzer behalten die Kontrolle über ihre Daten und können Löschungen selbstständig ausführen, was Mammouth AI besonders für datensensible Anwender in der EU interessant macht.

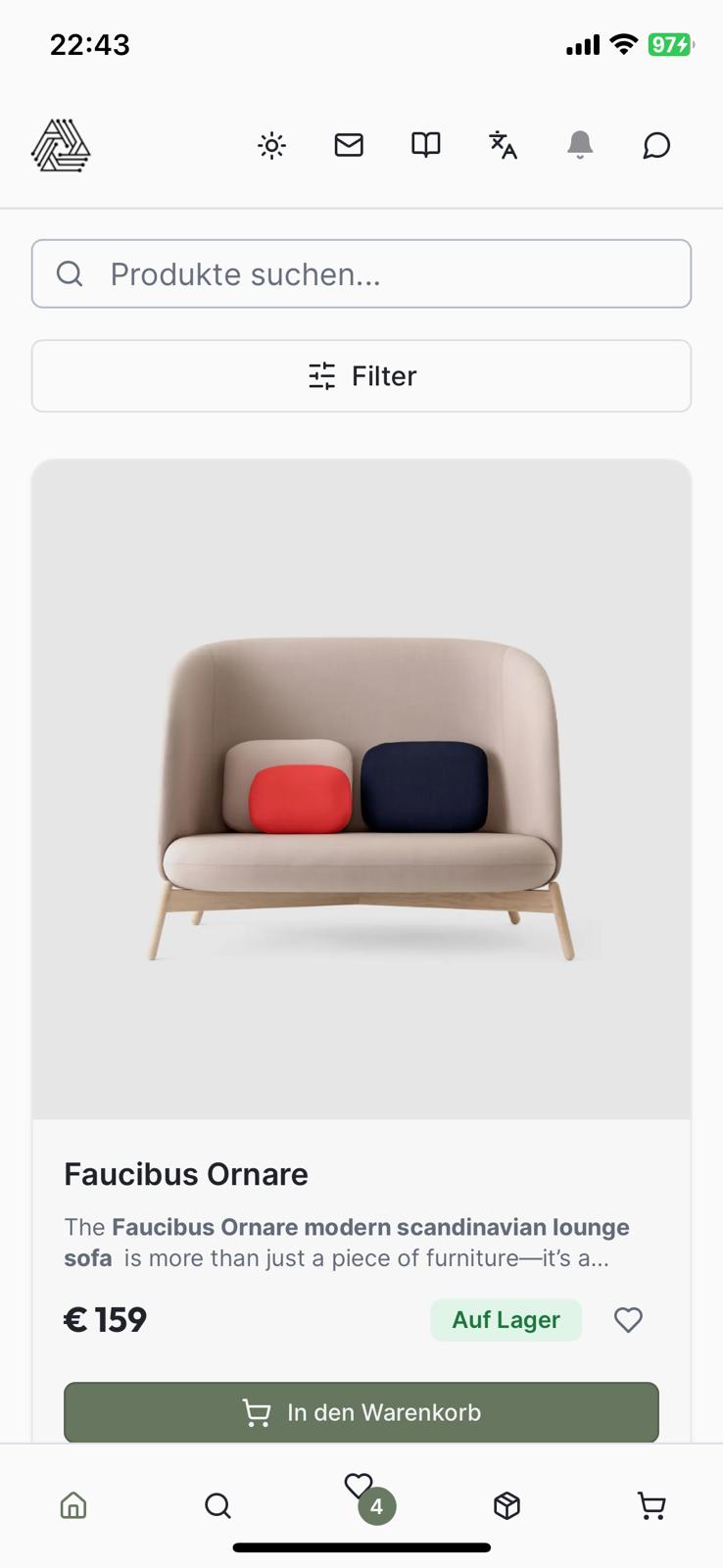

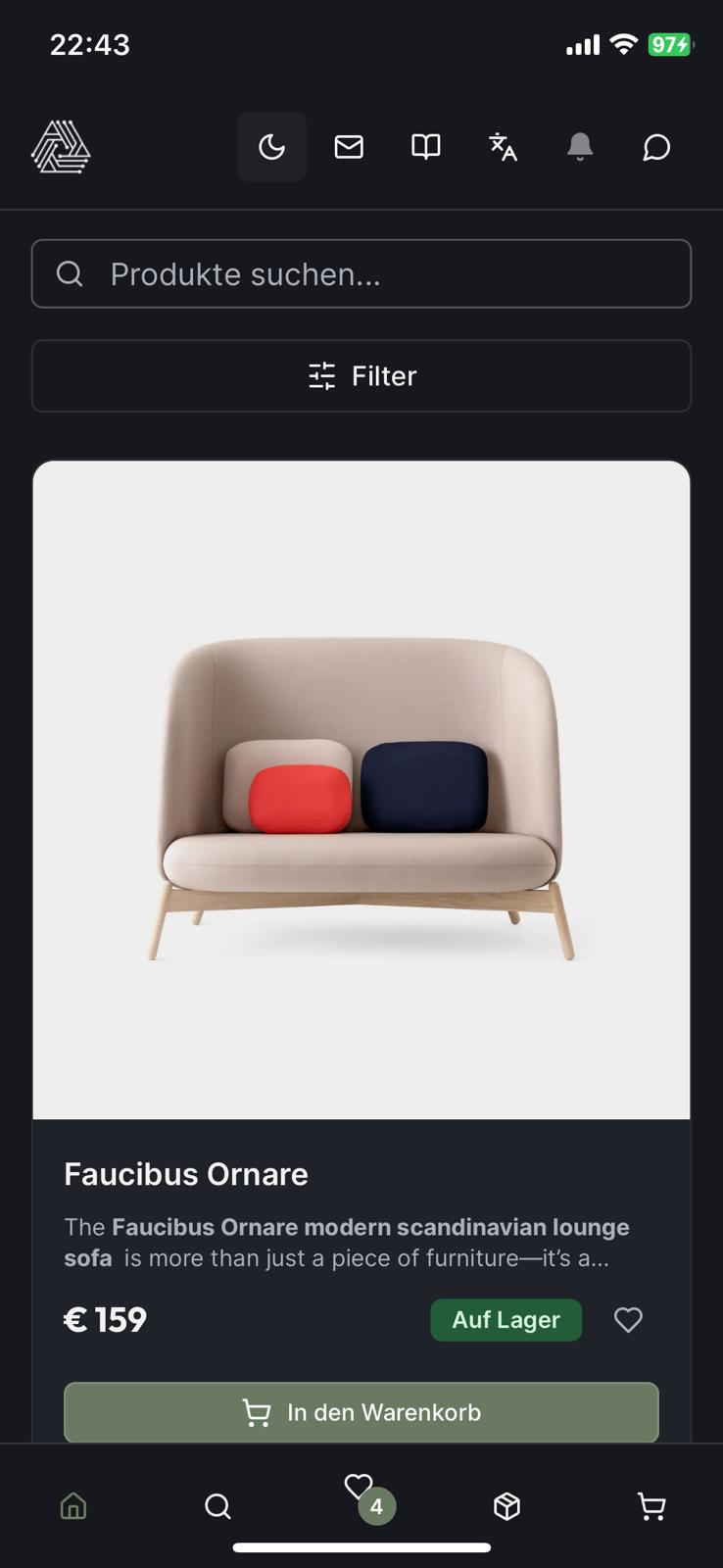

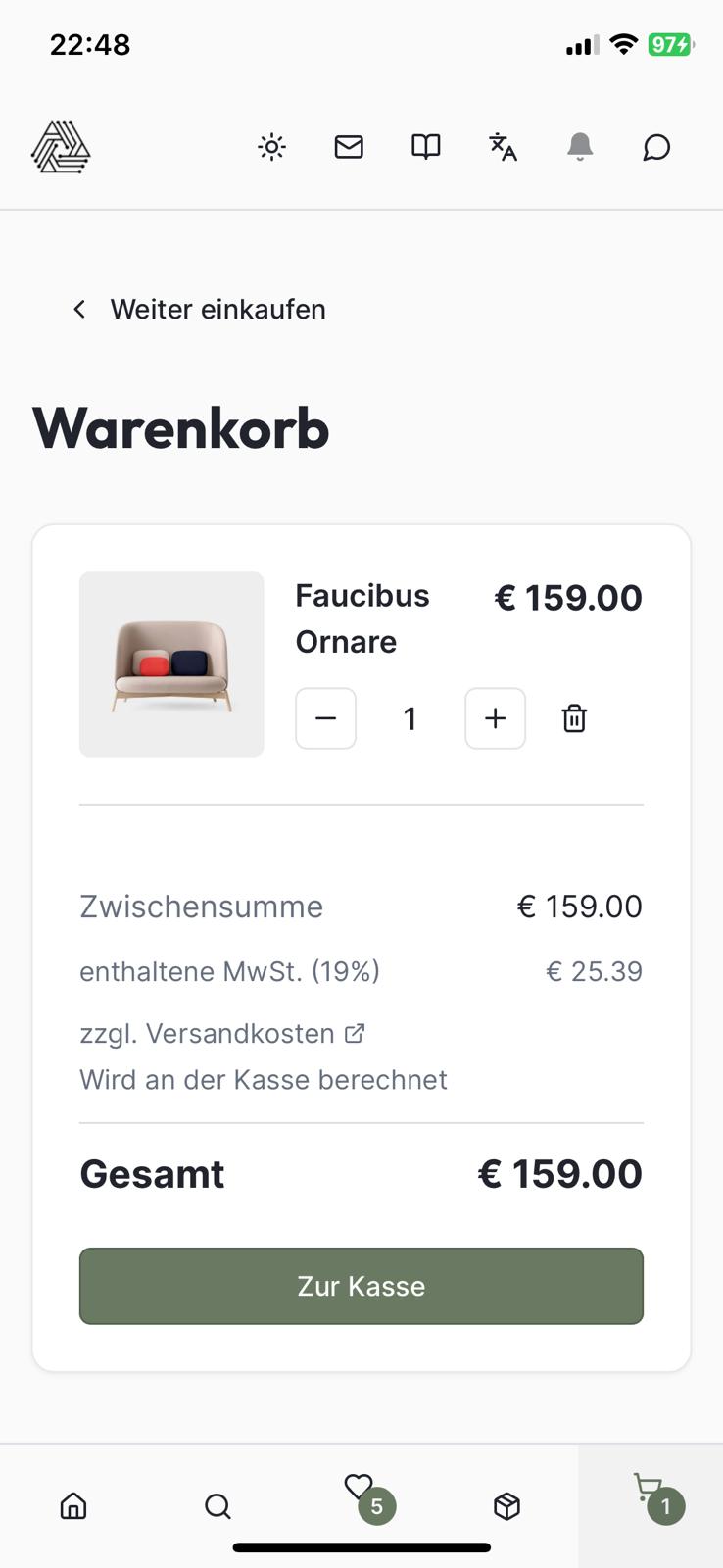

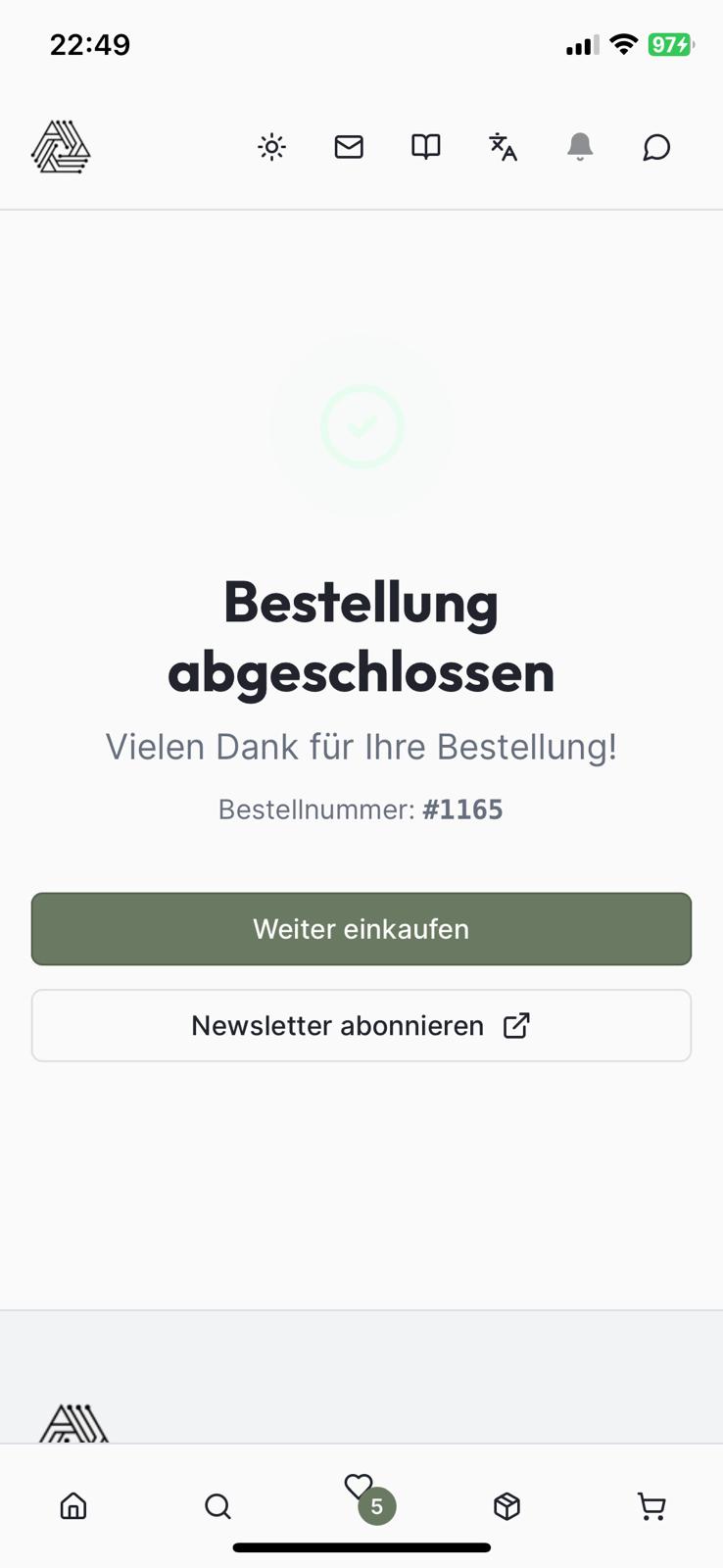

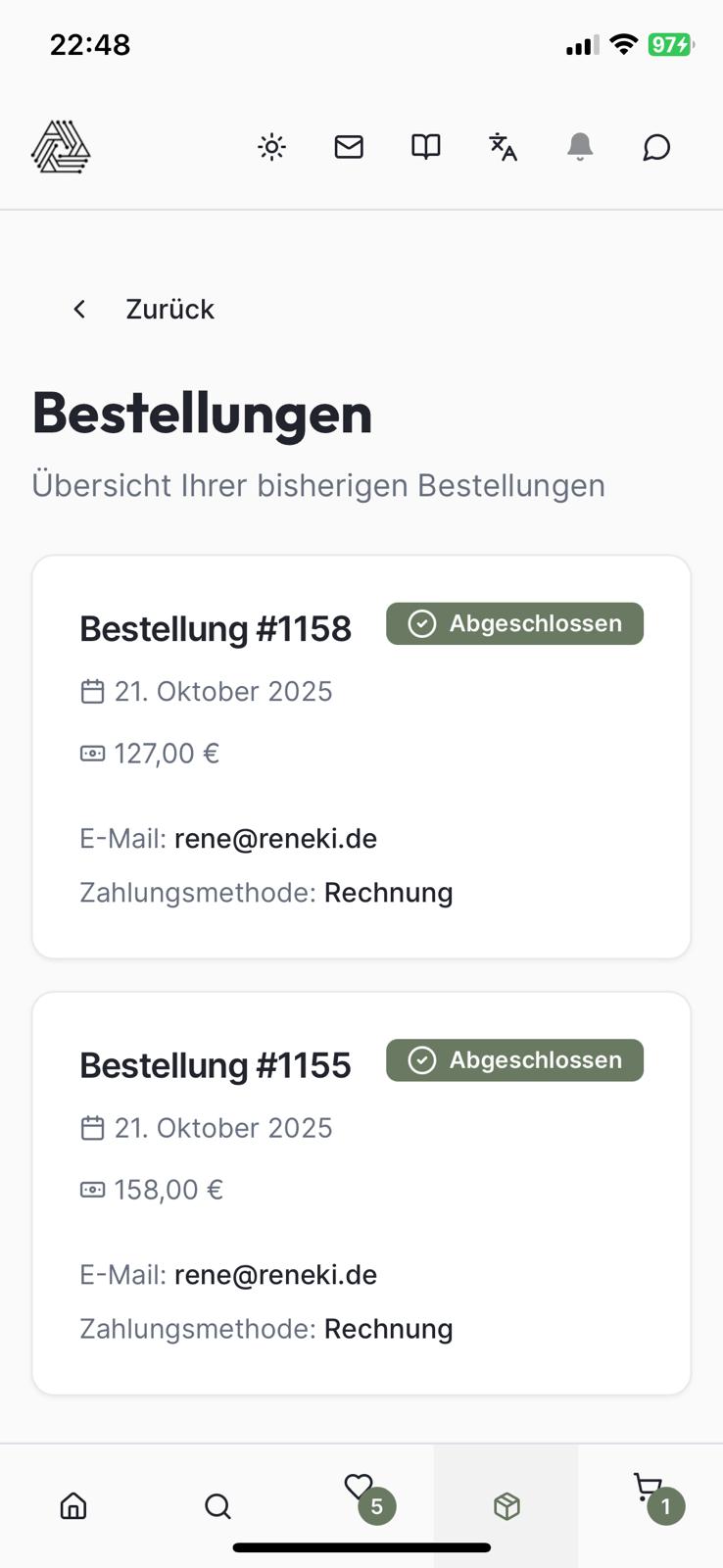

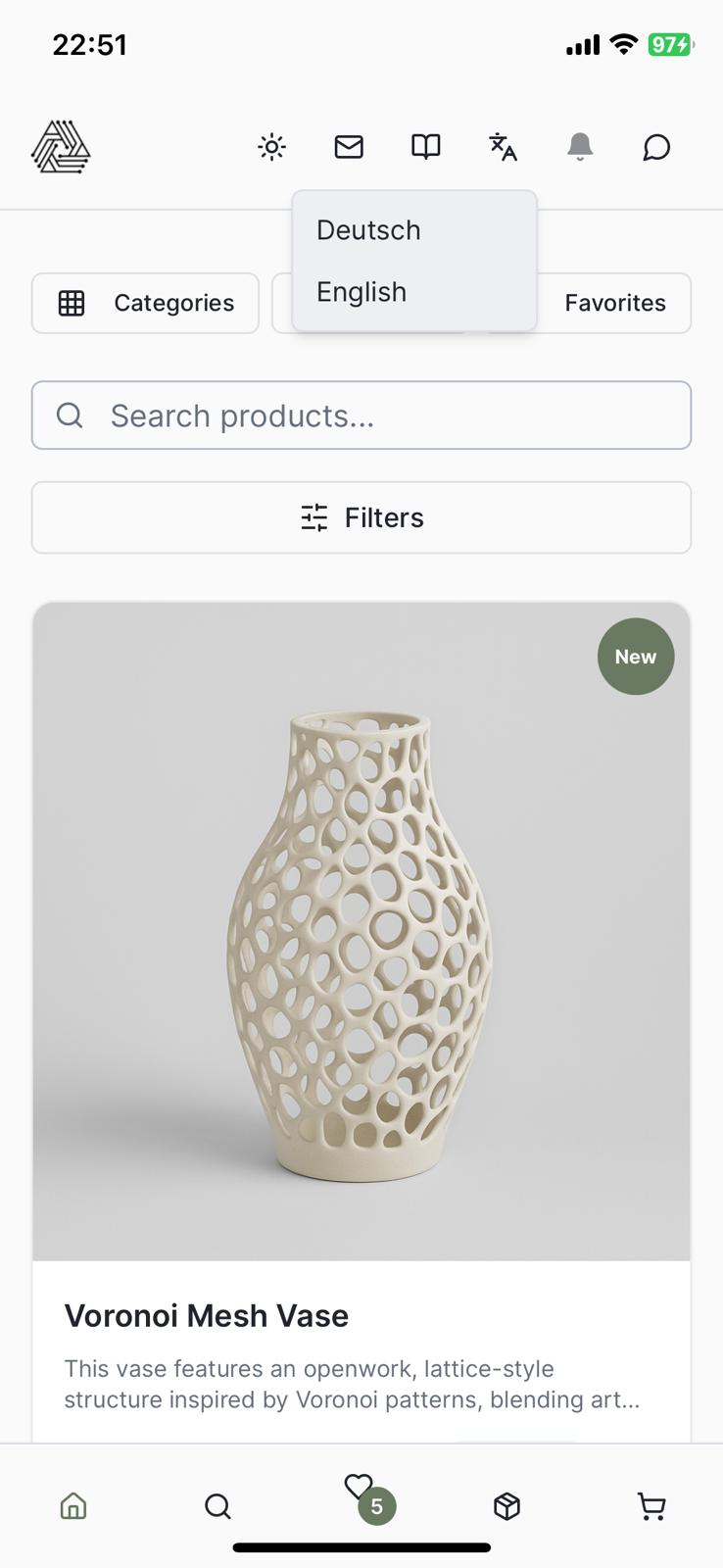

App Entwicklung mit Replit, Openrouter & Firebase

Zielstellung und Umsetzung

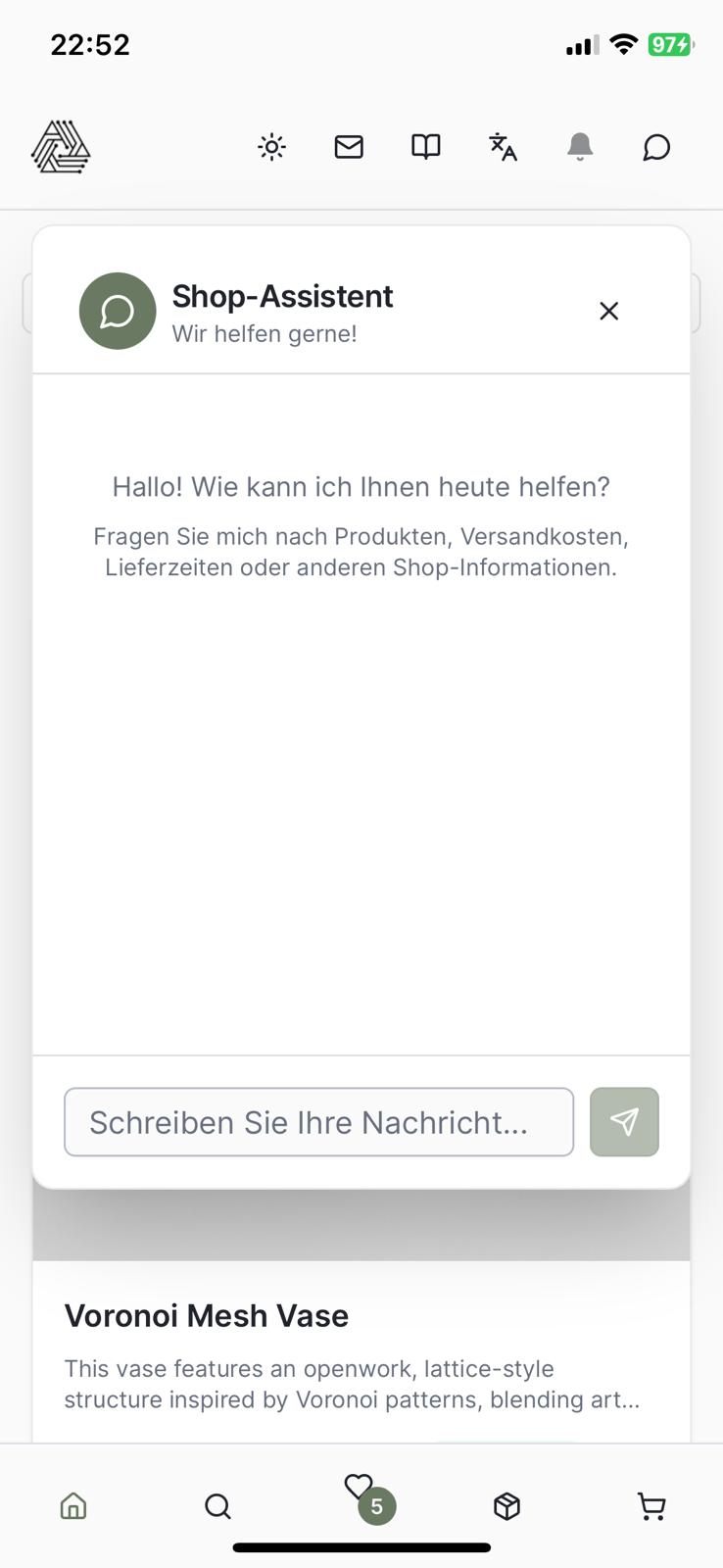

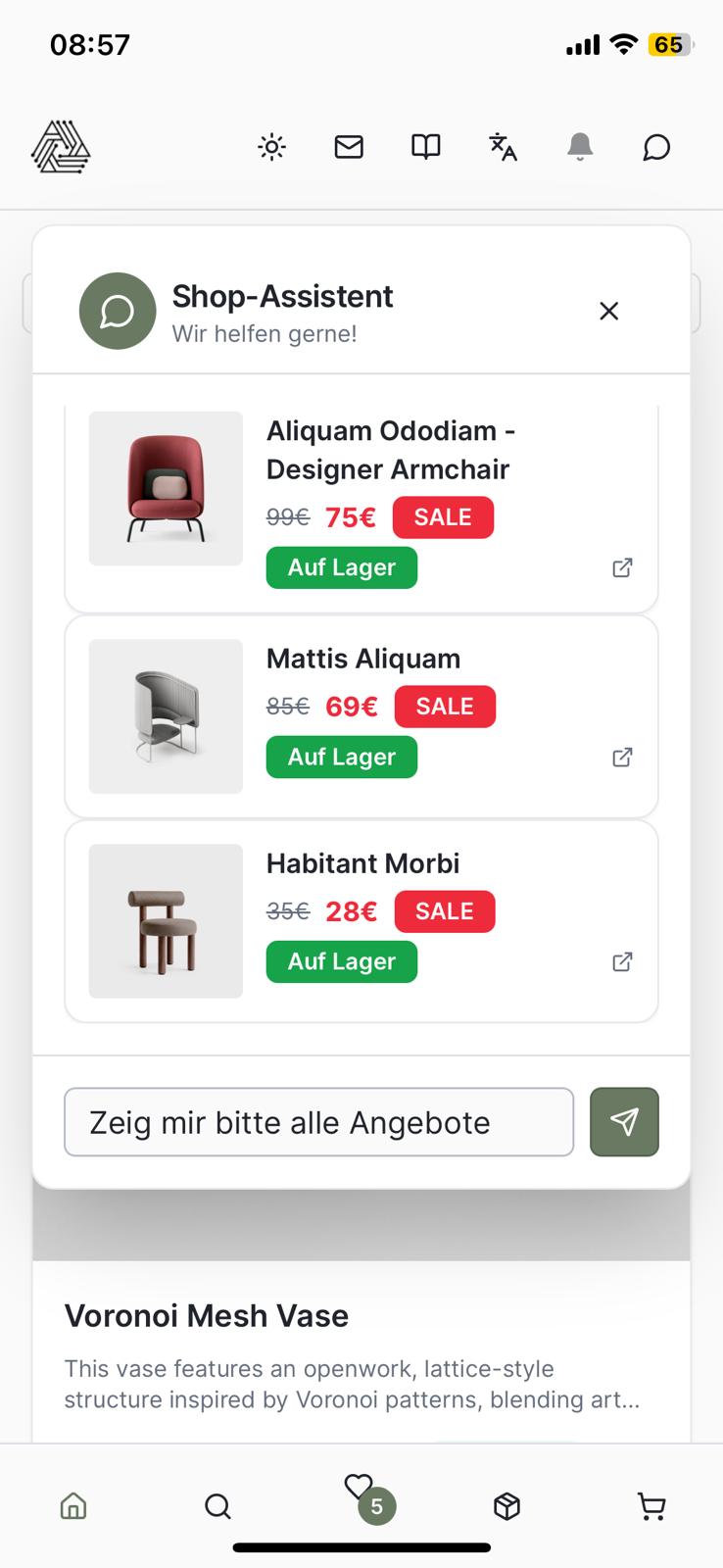

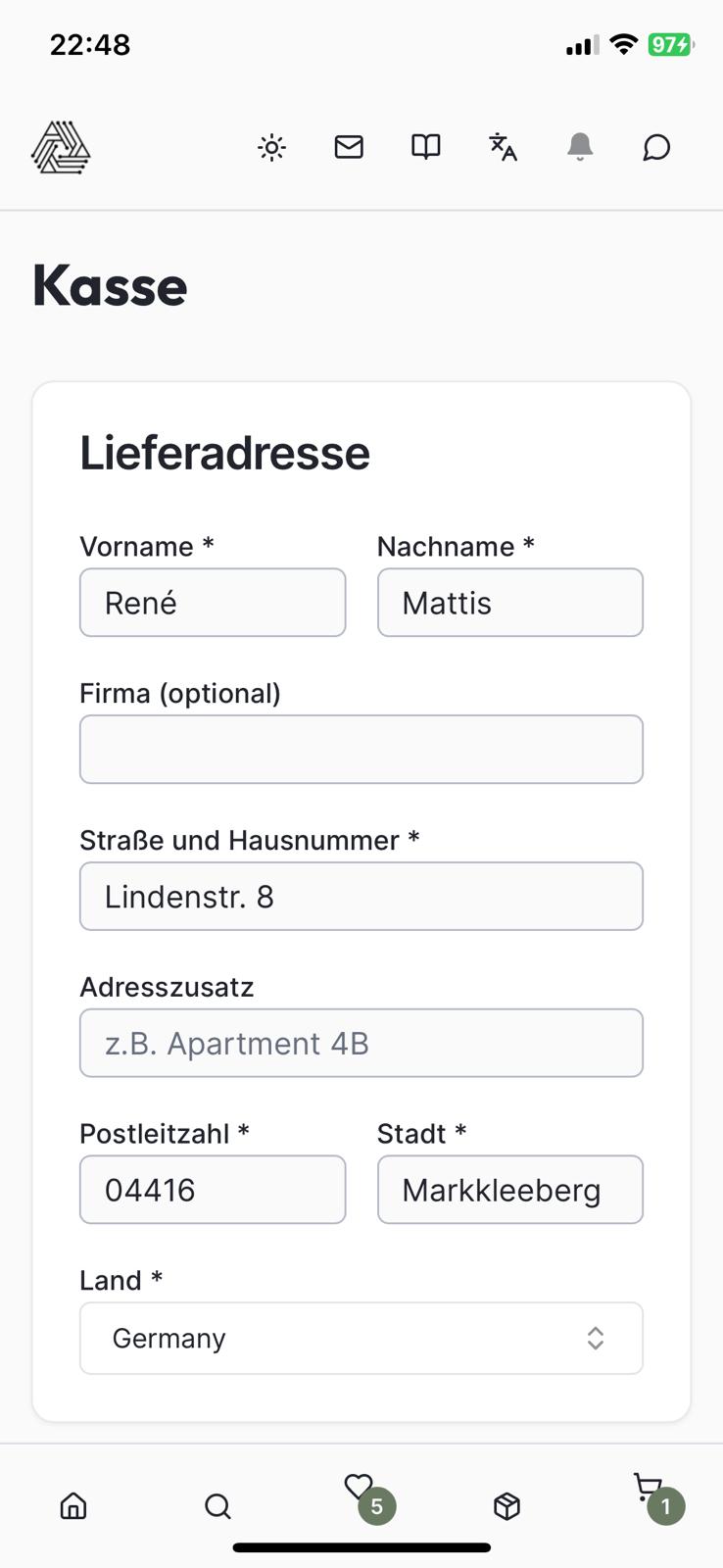

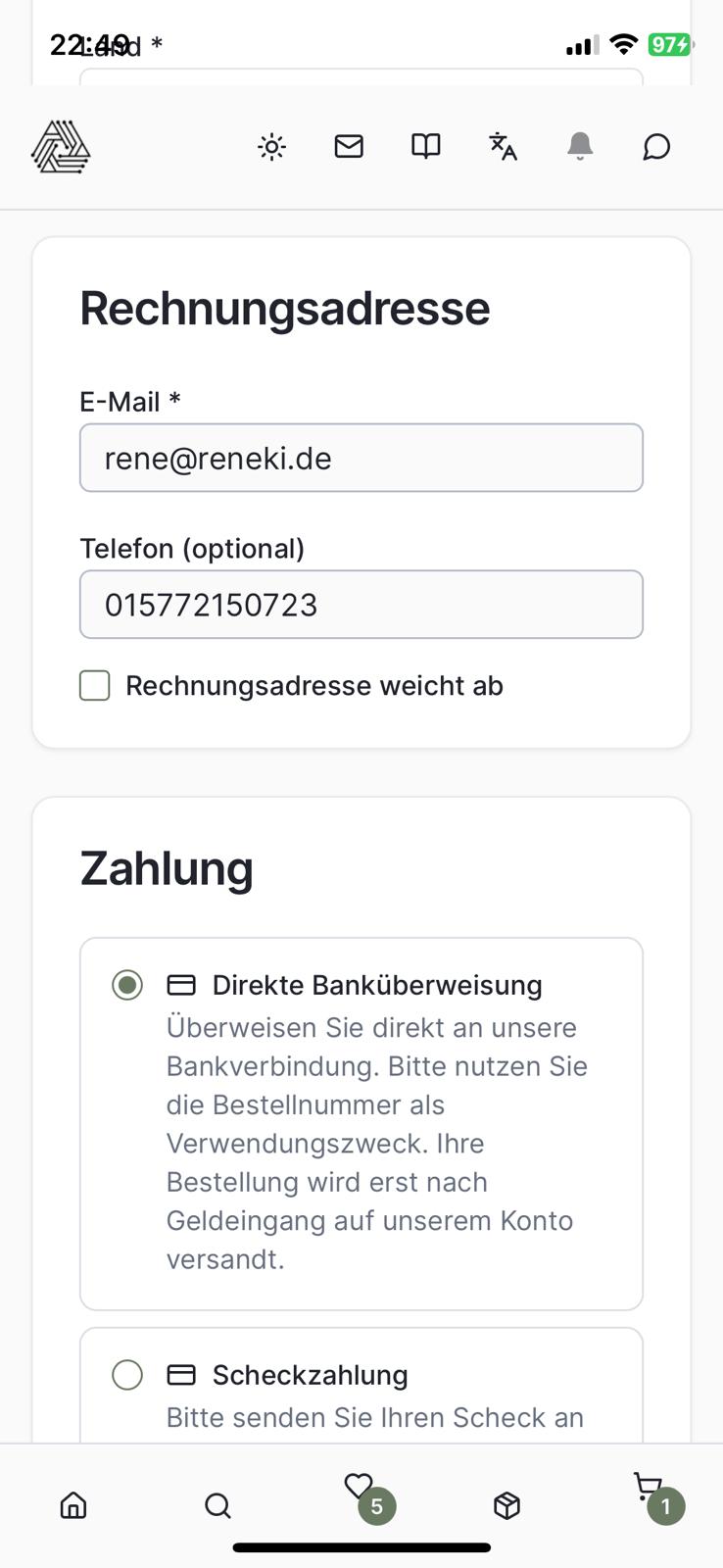

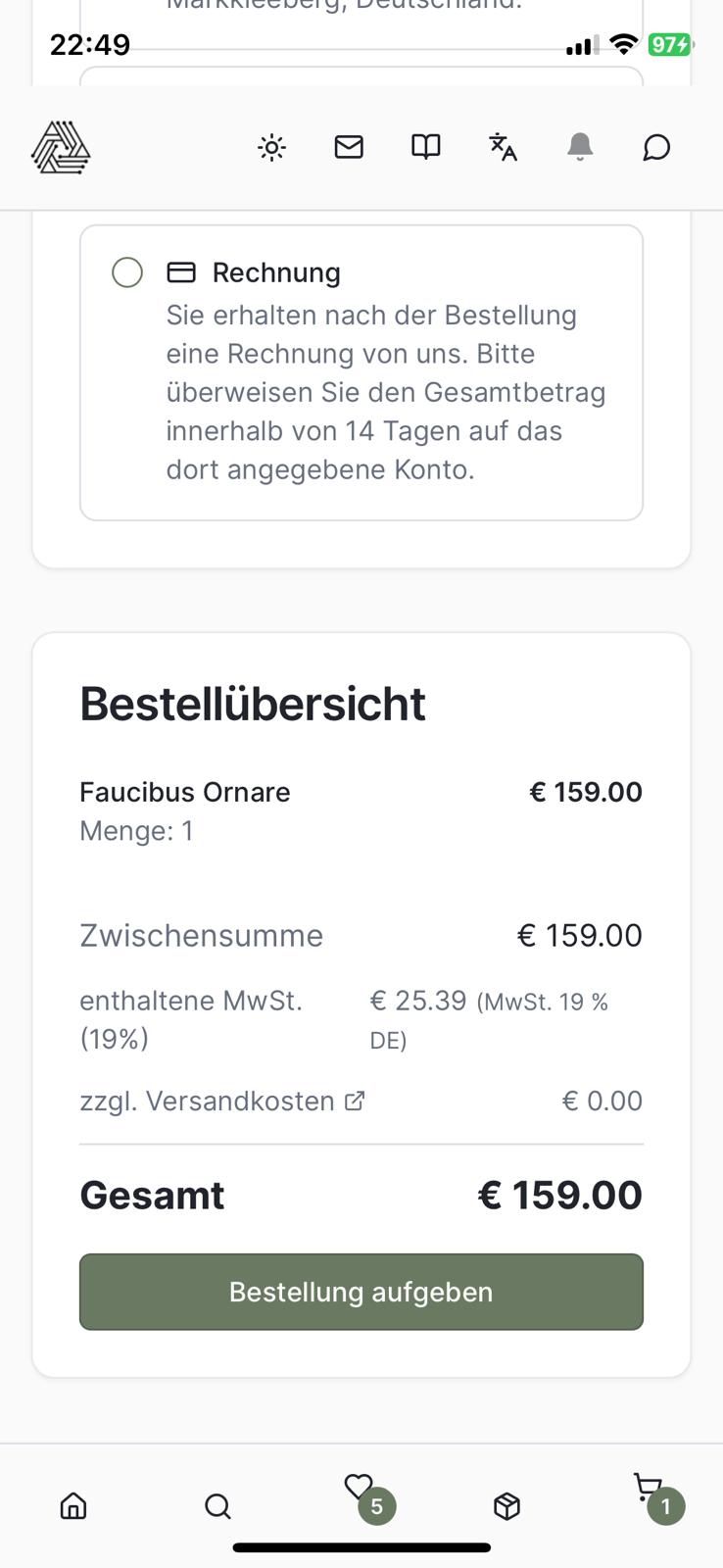

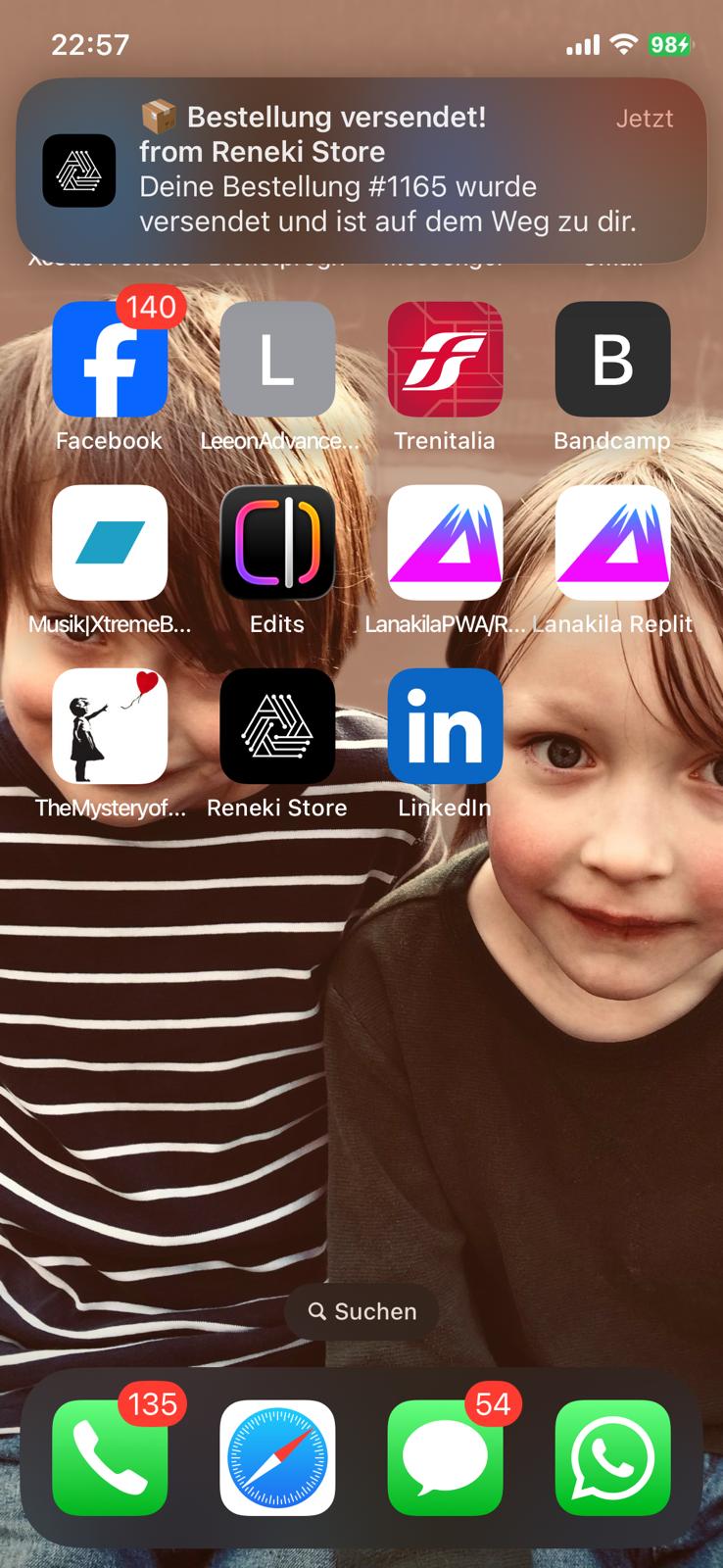

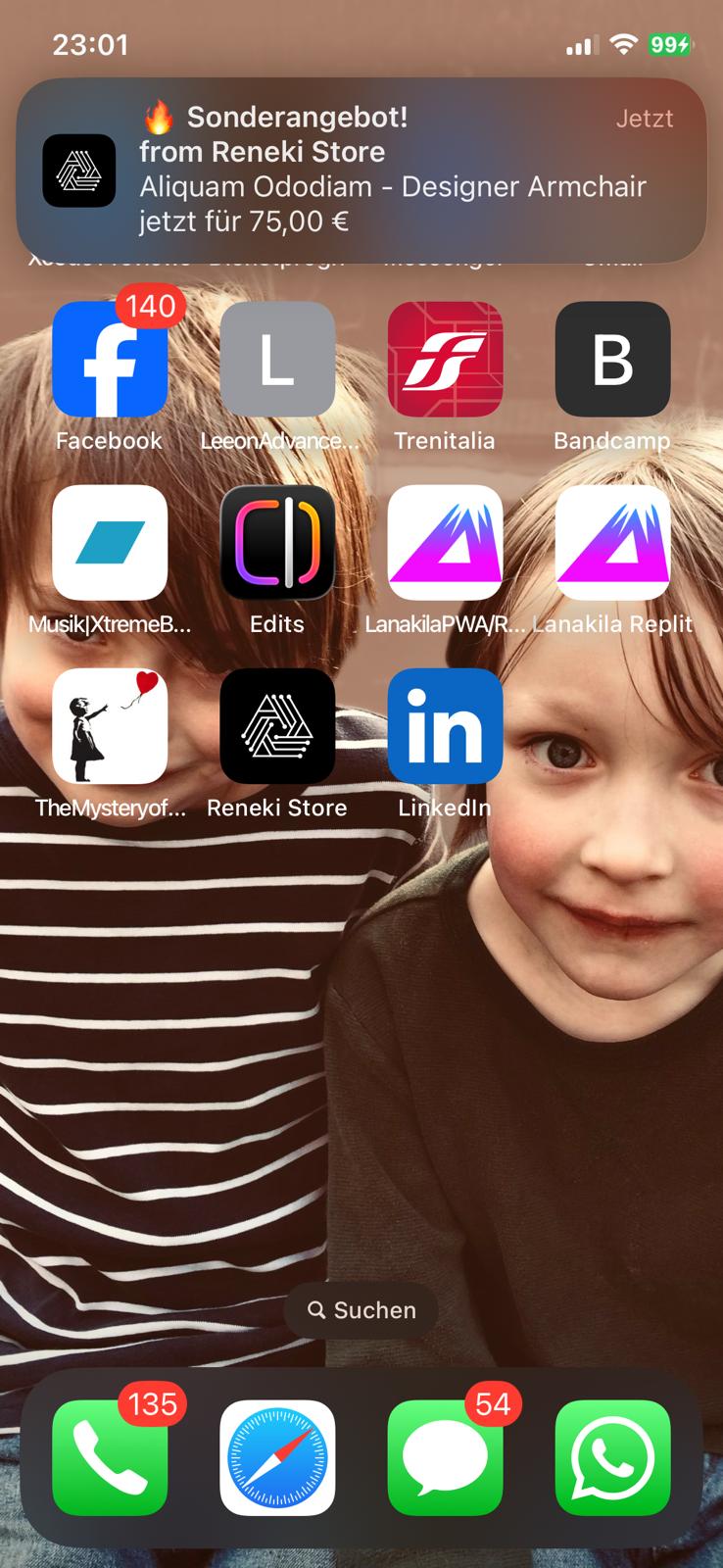

Entwicklung einer mehrsprachigen Progressive Web App (PWA) / E-Commerce Shopping App mit Replit, Openrouter (für Chatbot), WordPress & WooCommerce Rest API sowie Google Firebase für Push Notifications. Via Chatbot, welcher direkt in die App integriert wurde, hat der User (potentieller Käufer) die Möglichkeit, Fragen zu stellen wie zum Beispiel „Ich suche nach Produkt xy in Größe S, der Preisspanne zwischen 50 und 100 Euro“ oder „Wie hoch sind die Versandkosten?“ oder „Wie lang sind die Lieferzeiten?“ etc. Zudem werden Push Notifications automatisch gesendet sobald ein Produkt im Webshop einen Rabatt/ Sonderpreis erhält als auch sobald sich der Bestellstatus einer aus der App getätigten Bestellung ändert. Die Datenbasis für Produkte, Kategorien, Zahlungsarten, den Blog etc. der App bildet der WooCommerce Shop unter https://store.reneki.de. Alle in der App vorhandenen Produkte, Kategorien sowie Blog-Post werden über die REST API’s (WordPress als auch WooCommerce) synchronisiert. Die Mehrsprachigkeit wurde sowohl via Replit direkt (i18n) als auch via KI (Openrouter/ Deep Seek LMM) realisiert. Die App lässt sich sowohl auf iOS als auch Android Geräten installieren und fungiert dabei als PWA, was die Push Notifications ermöglicht.

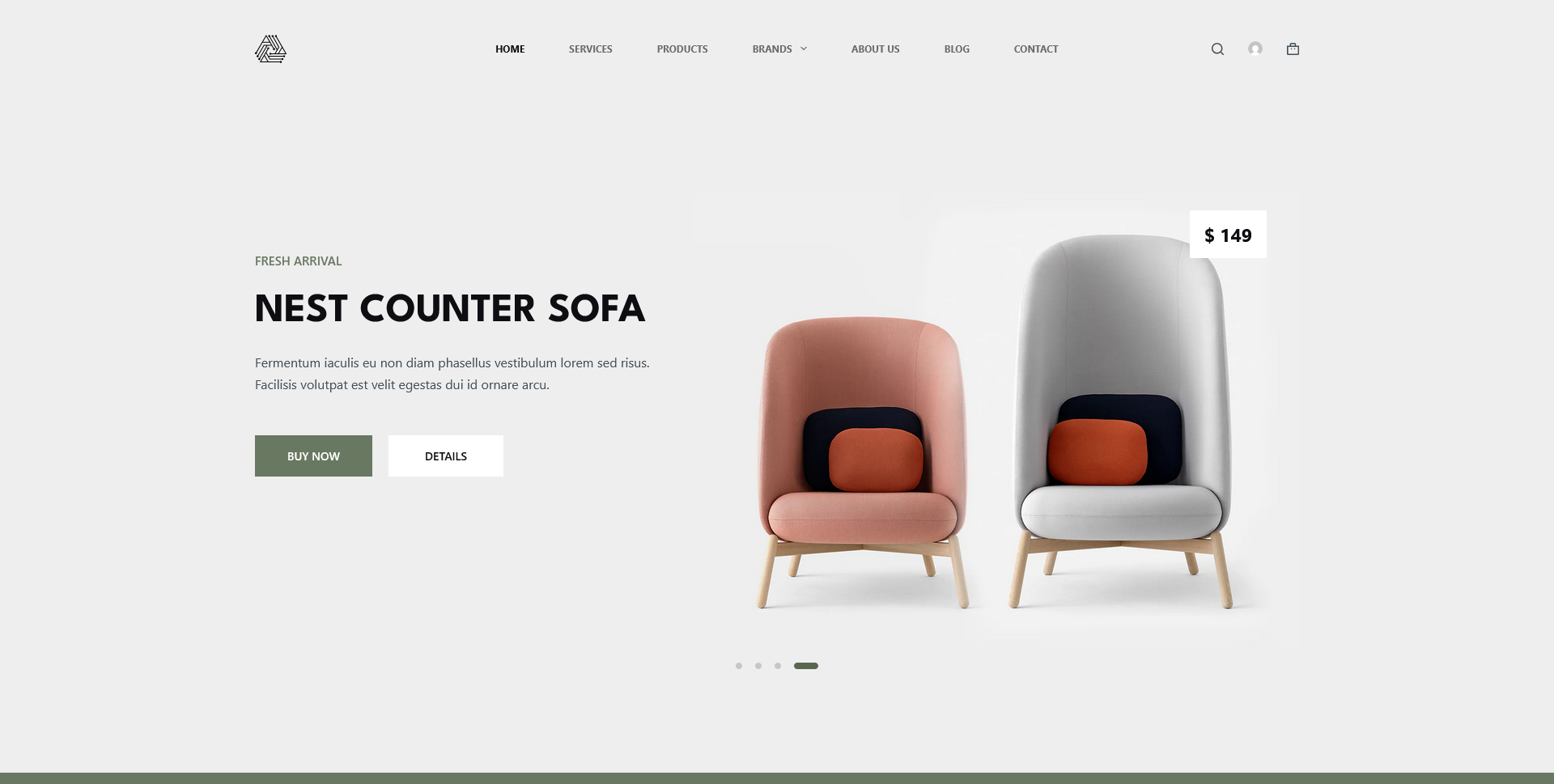

Reneki Store – PWA E-Commerce Application

A modern, performant Progressive Web App (PWA) built with React, TypeScript, and Tailwind CSS. Features WooCommerce integration with native payment gateways, and full offline support.

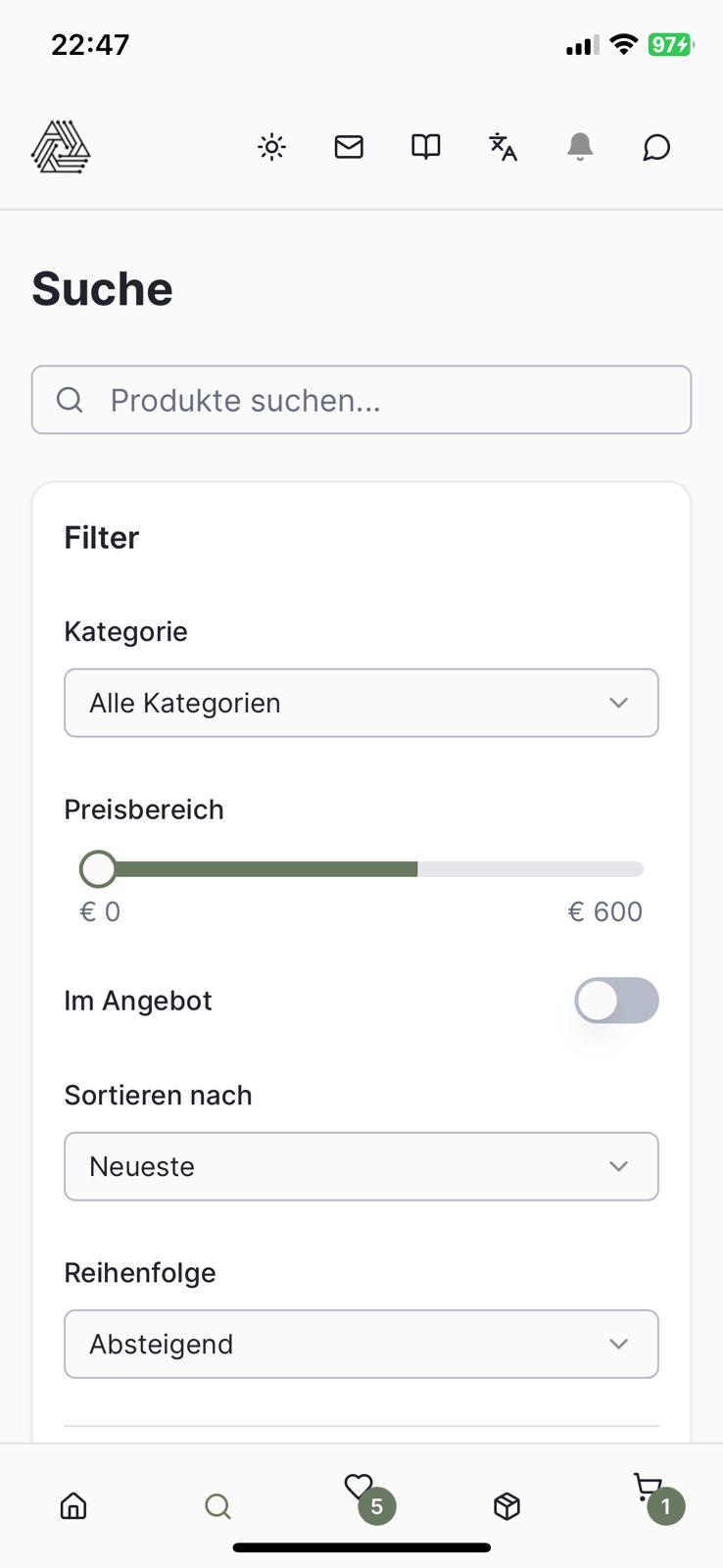

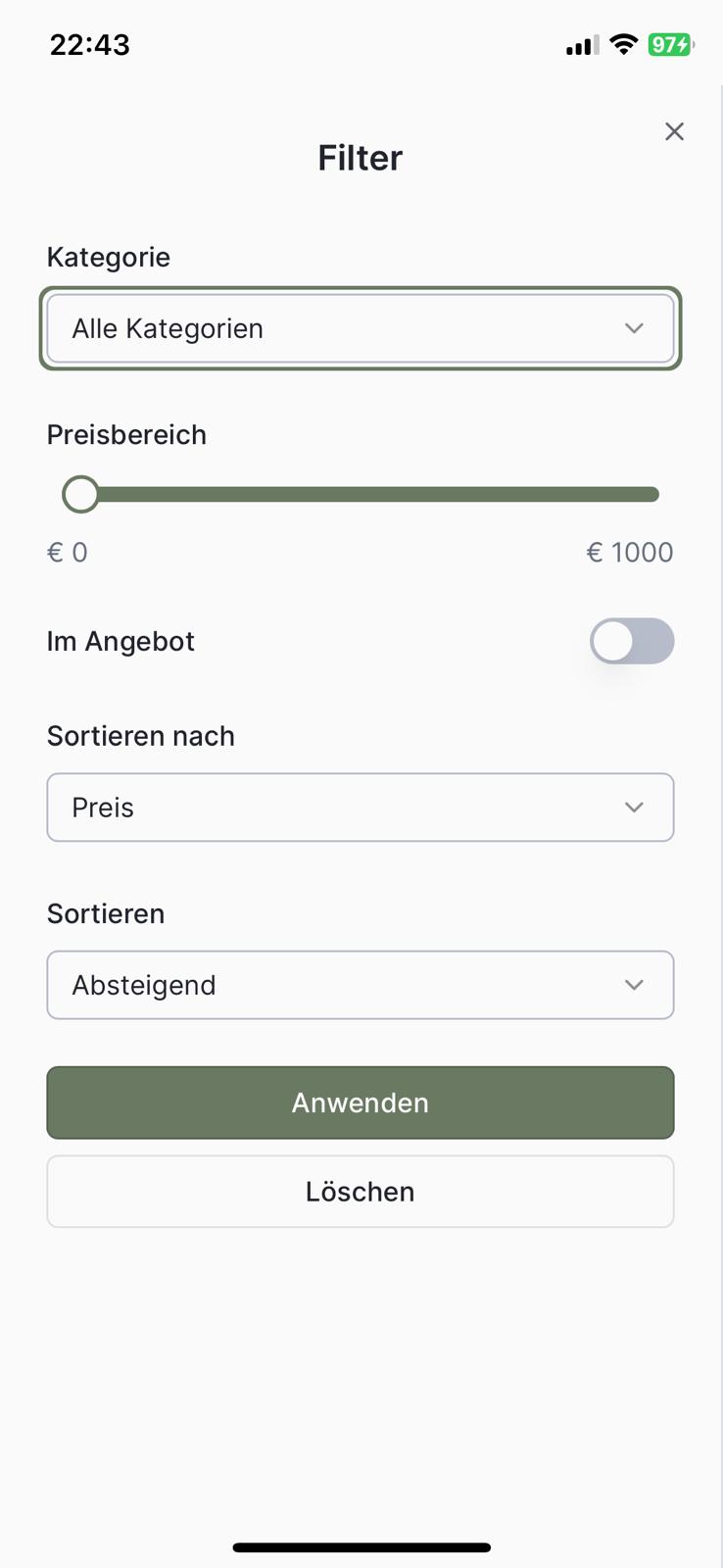

Overview

Reneki Store is a Progressive Web App (PWA) e-commerce application integrating with WooCommerce for product management and payment processing. It offers fuzzy search, advanced filtering, cart management, and multilingual support (German/English). The project aims to deliver a robust, mobile-first e-commerce platform focused on user experience and efficient product presentation, with a business vision to provide a modern and accessible e-commerce solution.

Deployment: Comprehensive installation guide for deploying to external Linux servers with Nginx or Apache reverse proxy, SSL/TLS, systemd service, and production configuration.

User Preferences

- Language: User can toggle between German (DE) and English (EN)

- Theme: User can toggle between light/dark mode or use automatic time-based switching (Light: 7:00-19:00 MEZ, Dark: 19:00-7:00 MEZ)

- Recently Viewed: Last 20 products viewed are tracked

- Cart: Persists across sessions via localStorage

System Architecture

UI/UX Decisions

- Mobile-first design: Optimized for mobile devices.

- PWA-ready: Manifest and service worker infrastructure for installability and offline access.

- DSGVO Compliance: Self-hosted fonts (Inter & Outfit) instead of Google Fonts CDN to avoid external tracking.

- Theme: Dark/light theme support.

- User Interface: Uses Tailwind CSS with shadcn/ui for a modern and responsive design.

Technical Implementations

- Frontend: React 18 with Vite, TypeScript, Zustand for client-side state, React Query for server state and caching, i18next for internationalization, Fuse.js for fuzzy search, and Wouter for routing.

- Backend: Express.js (Node.js 20), PostgreSQL (Neon-backed) for specific data persistence, Drizzle ORM for type-safe database operations, and Zod for runtime schema validation.

- Minimal database usage: PostgreSQL is primarily used for FCM token persistence; cart and user preferences are managed client-side using localStorage.

- Server-side API proxy: Implemented to secure WooCommerce and WordPress API credentials.

- Type-safe schema: Shared types between frontend and backend via Drizzle ORM.

- Flexible schema handling: Supports custom WooCommerce product types and varied price formats.

- Category Filtering: Specific Products and categories are excluded from all endpoints.

- Firebase Push Notifications: PostgreSQL-backed token storage with atomic upserts for reliable push notification delivery.

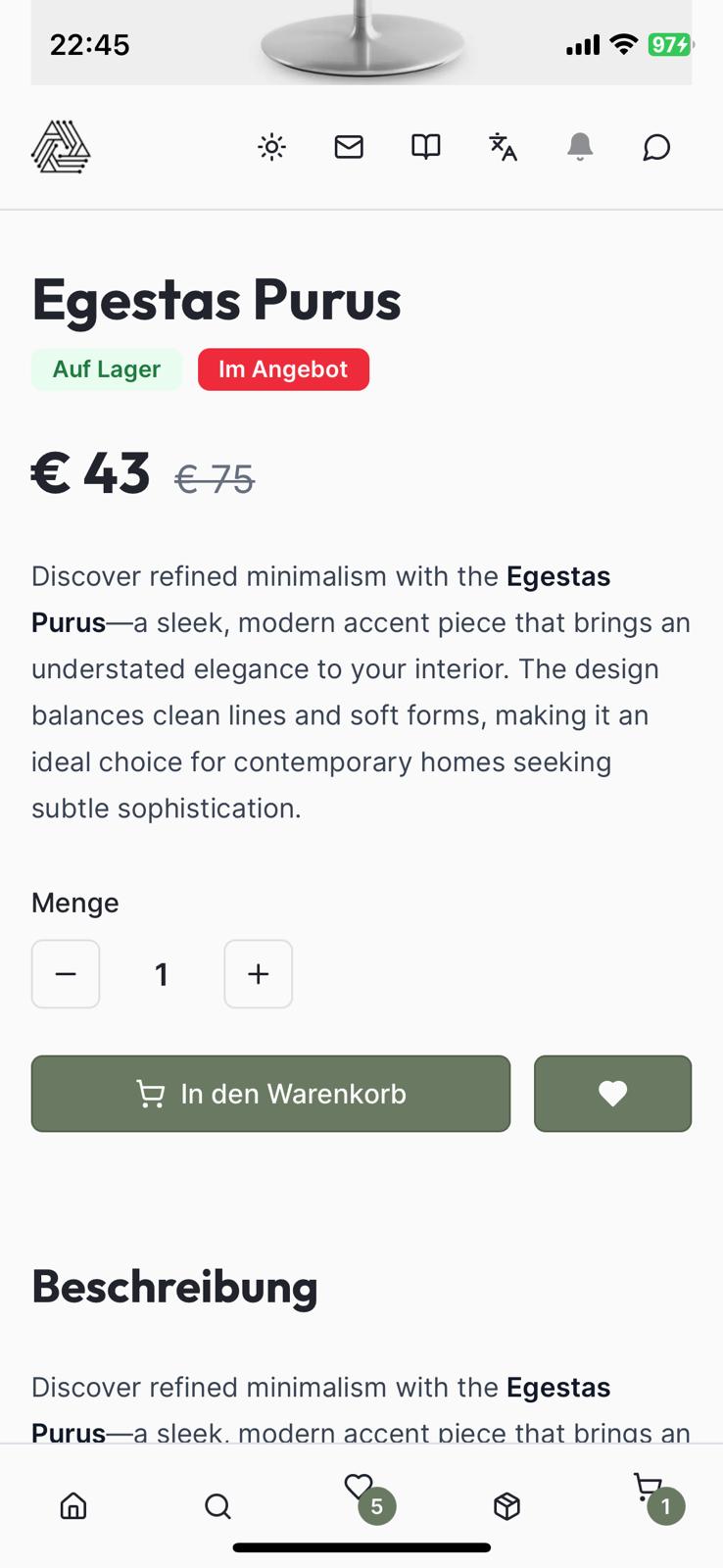

- Dynamic Tax and Shipping Calculation: Real-time calculation based on the customer’s shipping address using WooCommerce API, including automatic order confirmation email delivery.

- WooCommerce Webhook Integration: Processes product updates from WooCommerce, triggering push notifications for price changes (sales, price drops).

- Country Selection Filtering: Restricts country selection in checkout to 30 specific EU/EEA/EFTA countries, matching WooCommerce store configurations.

- WordPress Blog Integration: Server-side WordPress REST API proxy for posts and categories with URL-based state management for filters, sorting, and pagination.

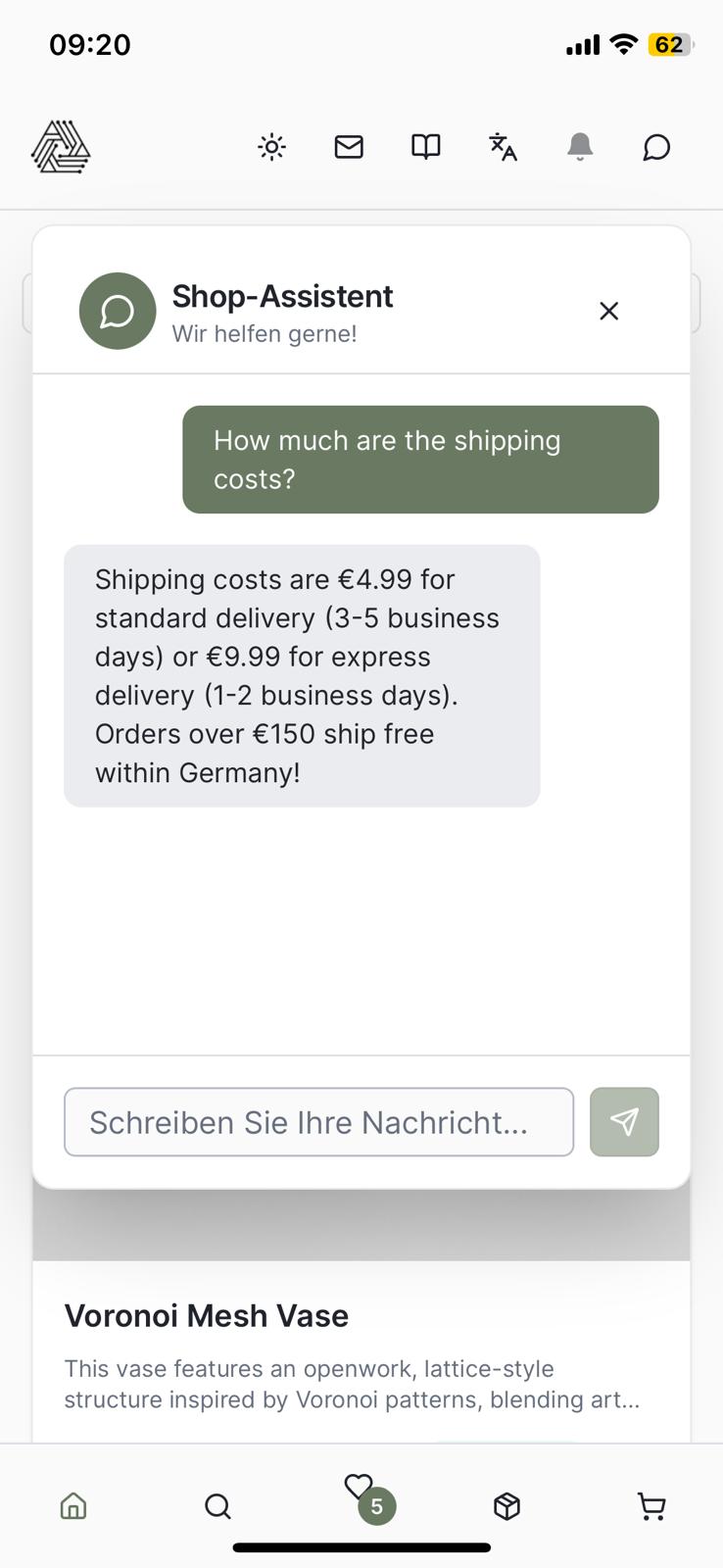

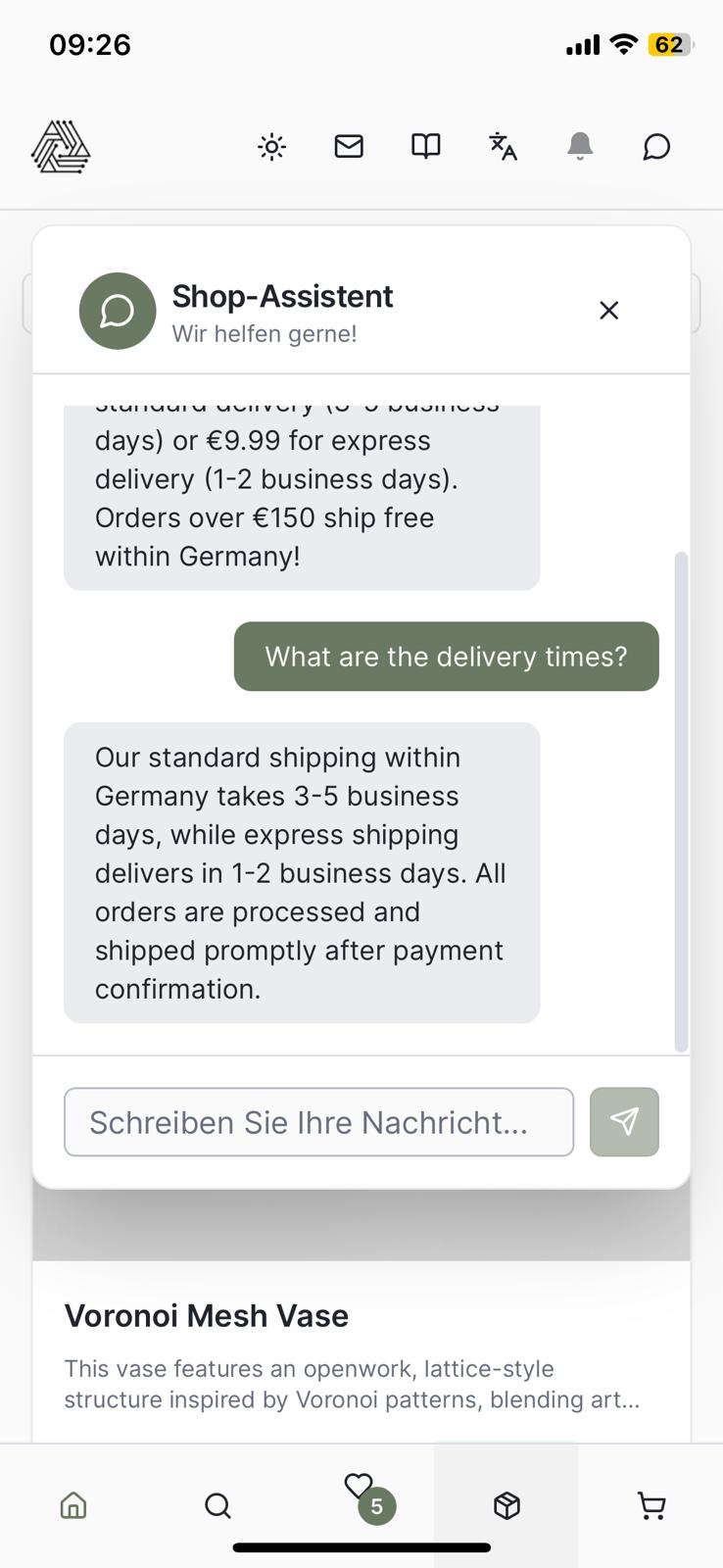

- AI Chatbot Integration: OpenRouter-powered customer support chatbot using DeepSeek V3 model with comprehensive shop knowledge (furniture categories, shipping, payment, returns, interior design advice) in DE/EN.

- Live Product Search: Chatbot automatically detects product queries (e.g., „show me vases under €50“) and performs real-time WooCommerce searches with category, price, and sale filters.

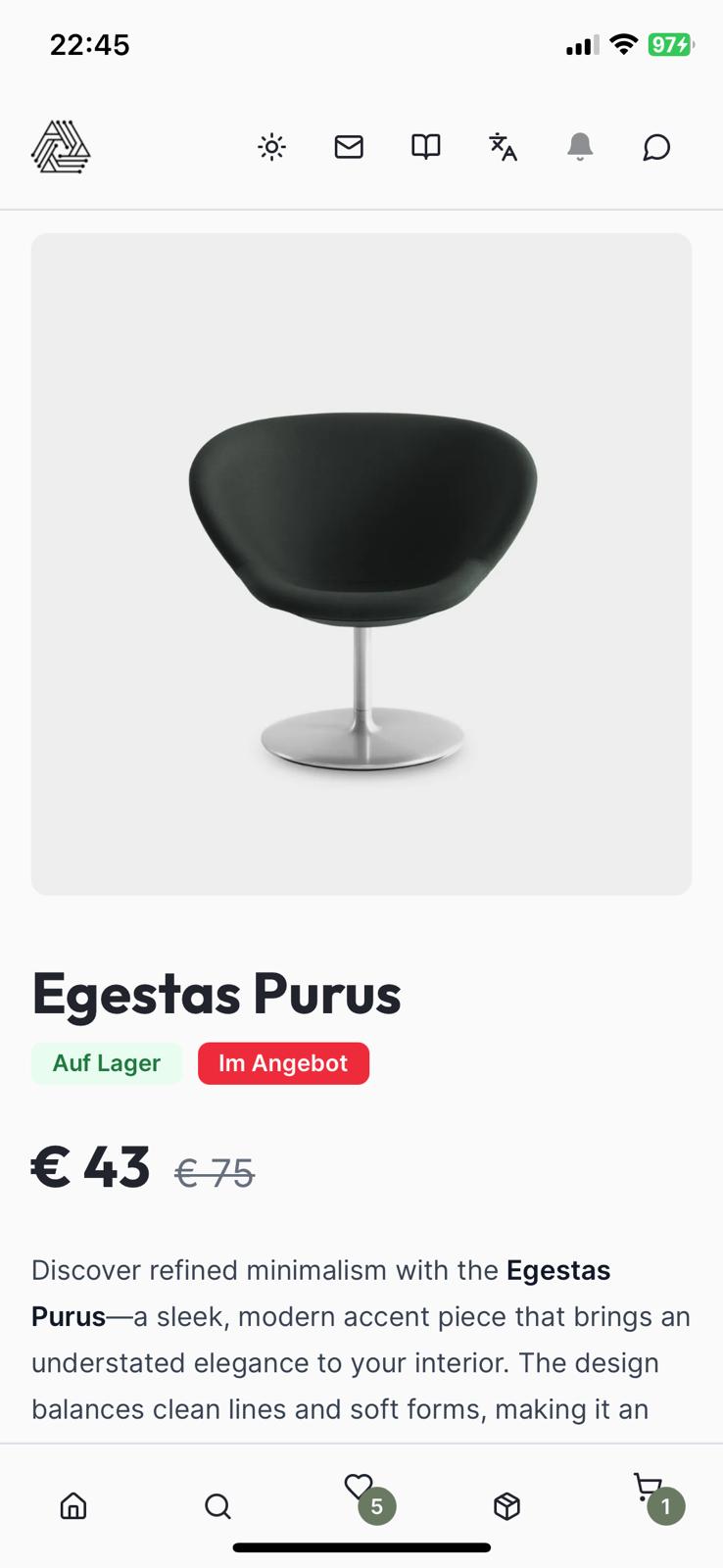

- Interactive Product Cards: Search results display as clickable cards inline with chat responses, showing product images, prices, sale badges, stock status, and deep-links to product detail pages.

- Multi-language Support: Product search works seamlessly in both German and English with automatic keyword detection for categories (Möbel/Furniture, Vasen/Vases, Beleuchtung/Lighting, etc.).

Feature Specifications

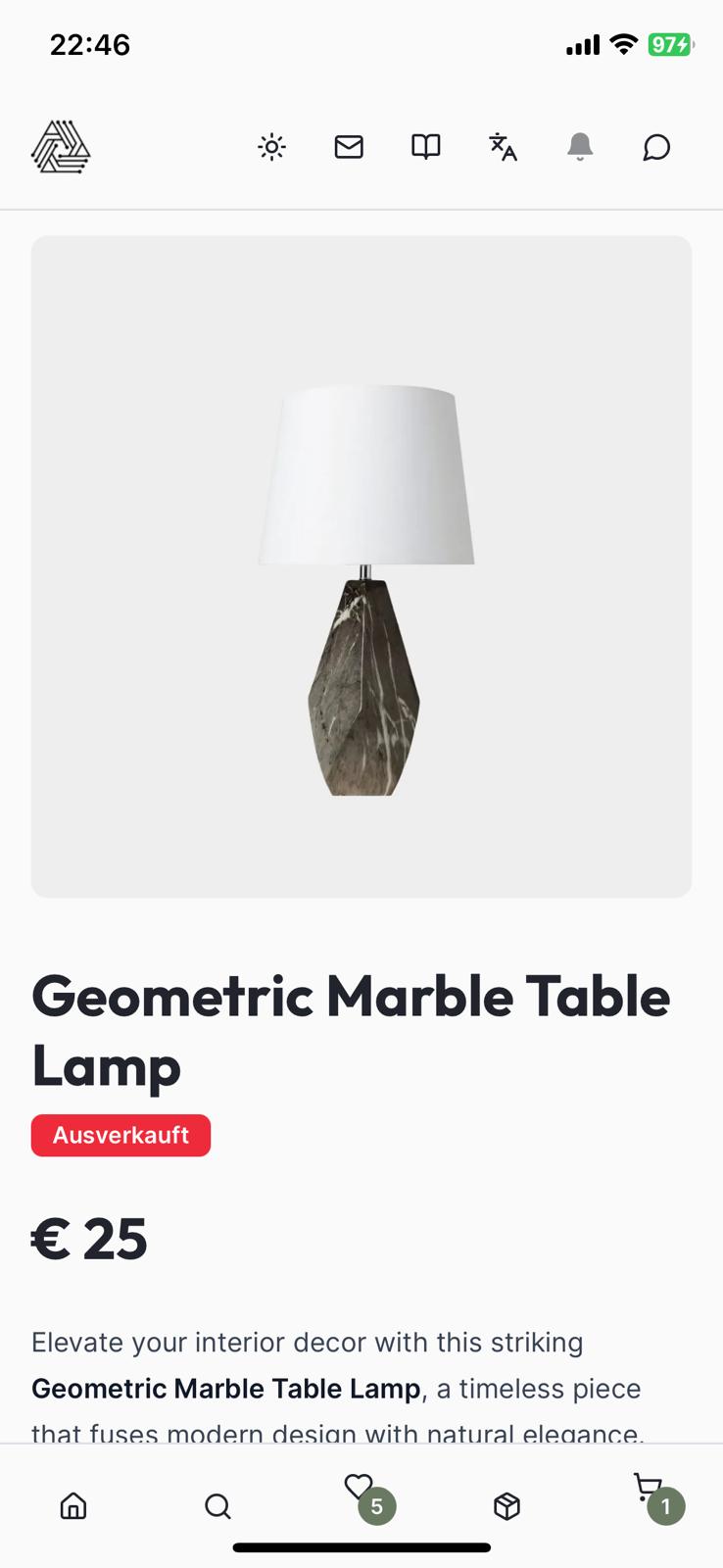

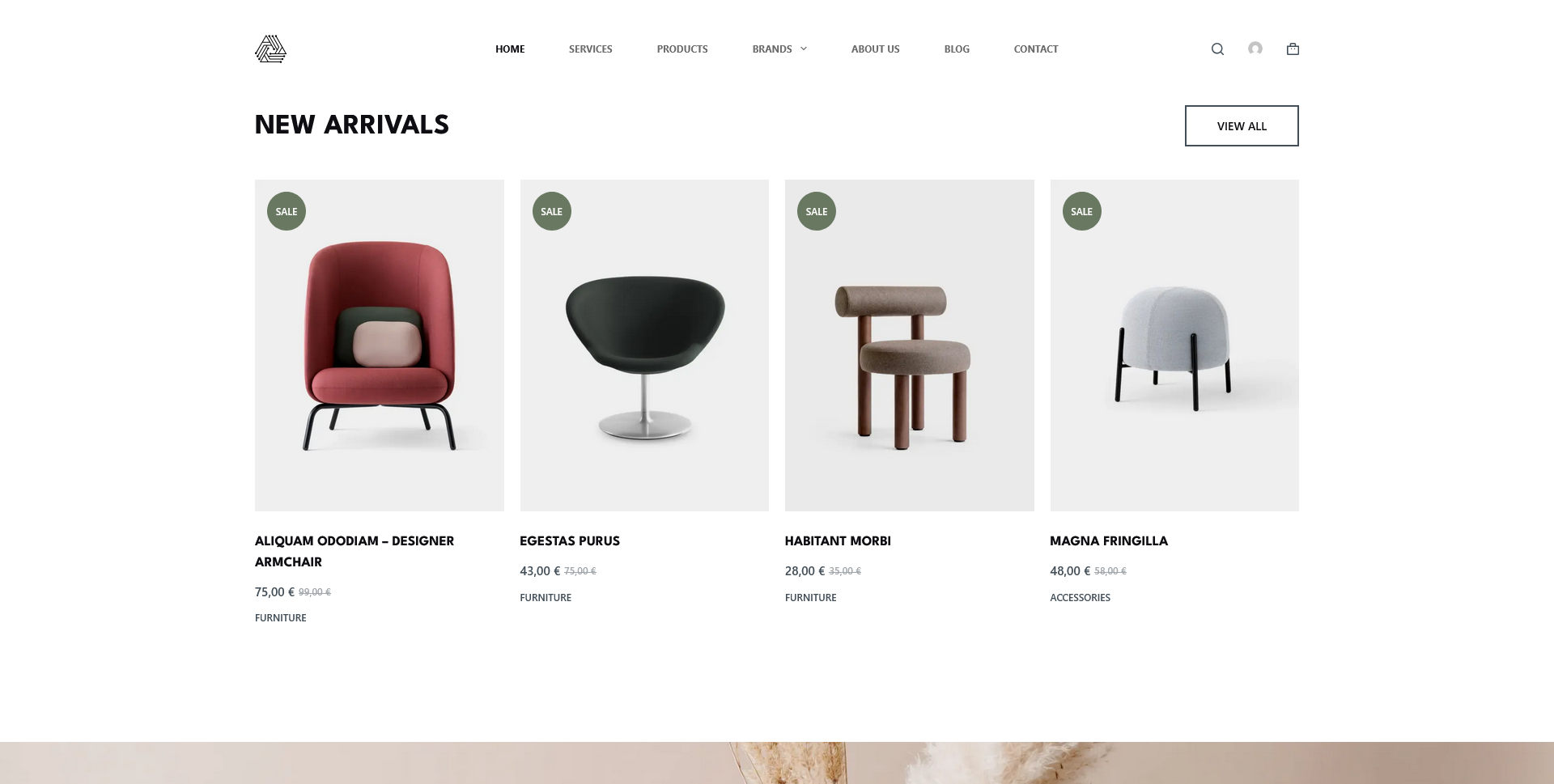

- Product listing with categories, filters, and fuzzy search.

- Product detail pages with variant selection.

- Shopping cart with persistence.

- WooCommerce native checkout with payment gateways.

- German/English language support.

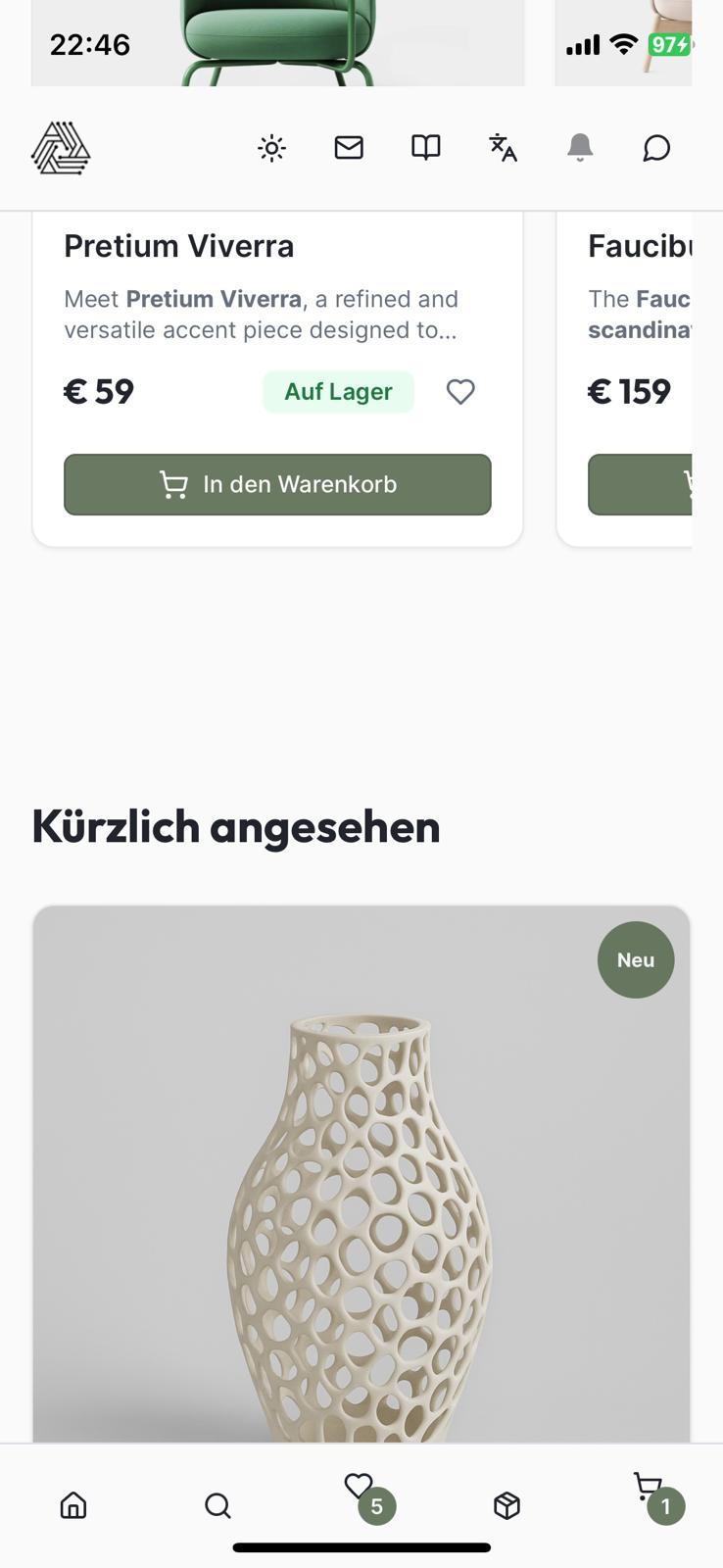

- Recently viewed products.

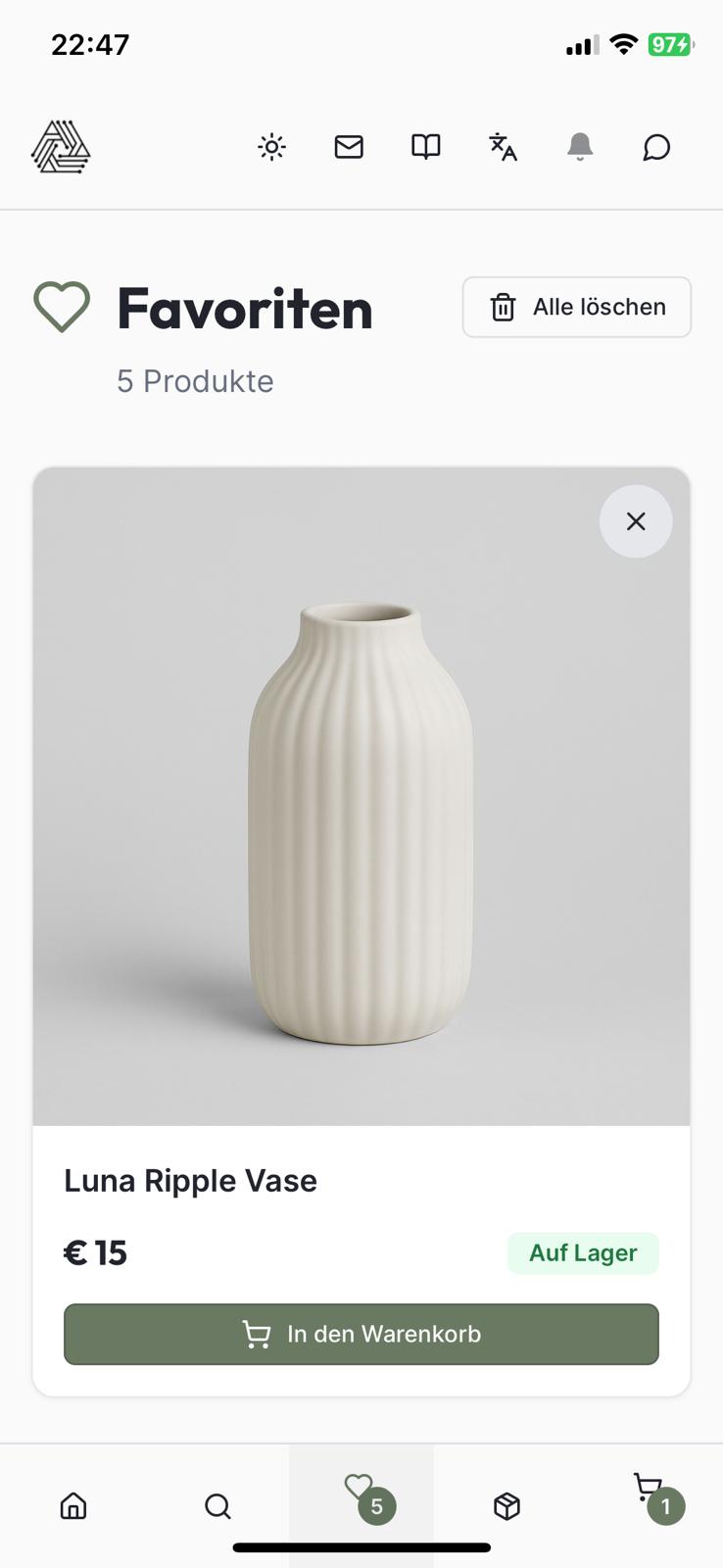

- Wishlist/favorites with persistence.

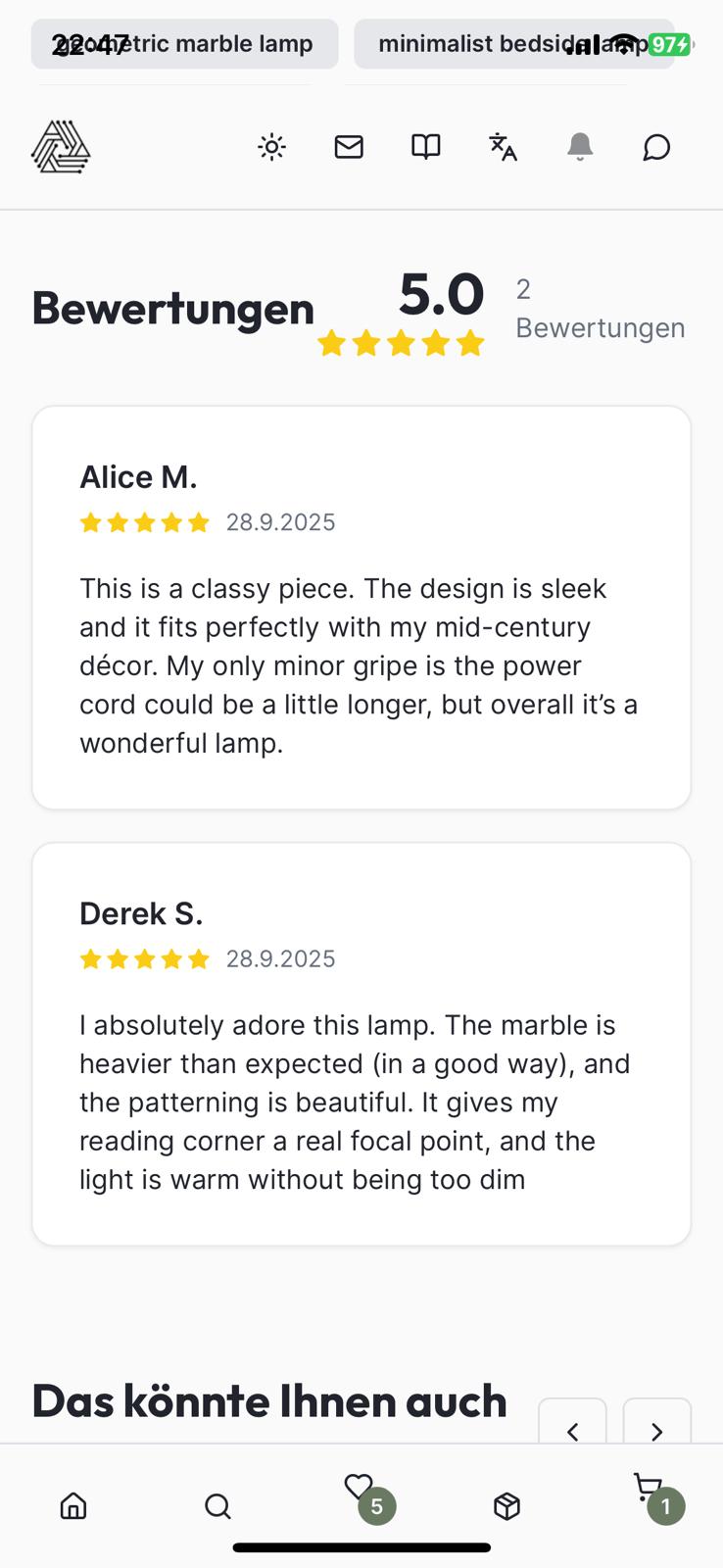

- Product reviews display with WooCommerce integration.

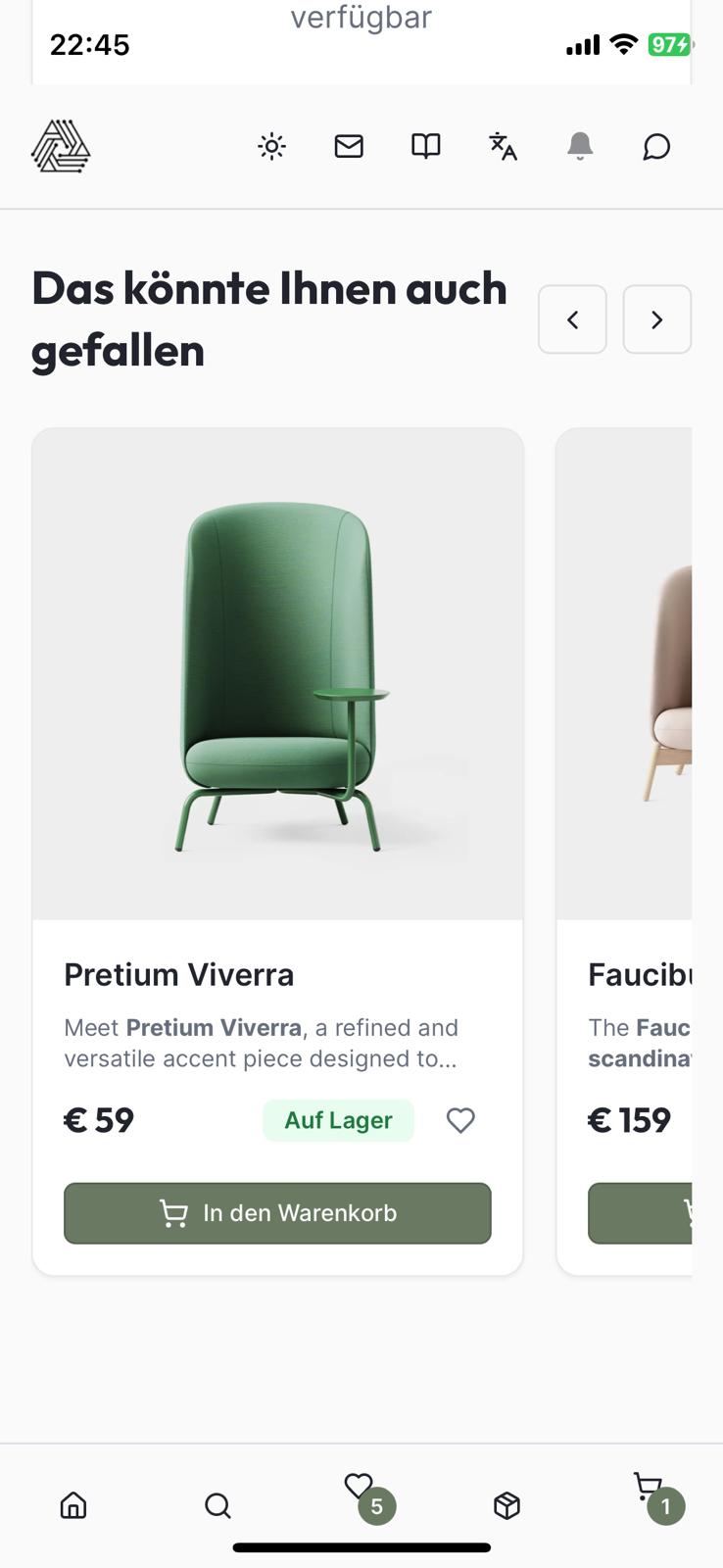

- Related/Similar products recommendations.

- Pagination system and tags filtering.

- Comprehensive footer with dynamic content.

- Firebase Cloud Messaging (FCM) for push notifications.

- Blog page displaying WordPress posts with category filtering, sorting (newest/oldest/title), and pagination (12 posts/page).

- AI-powered customer support chatbot with floating bubble UI, accessible on all pages, providing instant answers to product inquiries, shipping costs, payment methods, and general shop assistance.

External Dependencies

- WooCommerce REST API: Used for product management, categories, reviews, payment gateways, order creation, and dynamic tax/shipping calculations.

- WordPress REST API: Used for blog posts and categories via /wp-json/wp/v2 endpoints.

- Firebase: Utilized for push notifications through Firebase Cloud Messaging (FCM).

- PostgreSQL (Neon-backed): Cloud-hosted database for persistent storage of FCM tokens.

- OpenRouter AI: Powers the customer support chatbot using DeepSeek V3 model for cost-effective, intelligent responses with comprehensive shop context.

WordPress / WooCommerce Shop

Die Datenbasis der App

Diese PWA / Shopping App wurde von mir im Rahmen meiner Weiterbildung zum KI Consultant konzipiert / entwickelt und wird demnächst hier zum Download verfügbar sein.

Meine Erfahrungen mit Replit

Replit ist ein sehr leistungsstarkes KI-Tool für Entwickler und „No Coder“ und hat in diesem Projekt hervorragende Arbeit geleistet. Das Tool versteht die Aufgabenstellungen extrem schnell, trifft gute Entscheidungen, „denkt“ mit, stellt intelligente Fragen, überprüft stets die eigenen Logiken und Codes und auch der generierte Quellcode ist sauber und wird gut dokumentiert. Die Rollback Funktion ermöglicht es stets, zurück zu gehen und an einer vorangegangenen Aufgabenstellung erneut anzusetzen. Die integrierte Github Anbindung ermöglicht es zudem die Projektstände stets mit dem eigenen Repo aktuell zu halten. Für mich als Software-Entwickler ein absoluter Mehrwert wenn es darum geht, KI- oder Software Projekte effizient zu entwickeln.Eine derartige App auf „herkömmlichen“ Wege zu entwickeln hätte weitaus mehr Zeit in Anspruch genommen – schätzungsweise das 10 fache.

Beeindruckt hat mich die Intelligenz von Replit, vor allem bei der Erkennung und Implementierung von externen APIs wie z.B. die WooCommerce Rest API oder auch Firebase und Openrouter. Die Rest Endpunkte waren allen korrekt, die JSON Calls exakt – ein manuelles Eingreifen oder Korrekturen waren nicht notwendig. Die permantente „Selbstkontrolle“ der von Replit erzeugten Codes sorgte zudem für ein automatisiertes „Debugging“ und wurde sehr gut umgesetzt.

Die einzige „Schwäche“, die ich in diesem Projekt erfahren habe war ein mehrstündiger Ausfall der kompletten Replit Plattform. Dennoch gingen keine Daten verloren, nach dem Ausfall war alles wieder hergestellt. An manchen Stellen bzw. bei manchen Aufgabenstellungen benötigt Replit mehr Zeit zur „Lösungsfindung“ als wenn man diese manuell eingebaut hätte (man muss also hier und da ein wenig Geduld aufbringen) – aber unter dem Strich ist das mehr als verkraftbar wenn bedenkt in welcher Zeit die gesamte App entstanden ist. Auch für „No Coder“ – also Anwender, die keinerlei Programmierkenntnisse haben – ist Replit eine sehr gute Wahl denn die Plattform hilft bei kniffligen Sachen und gibt Step-By-Step Anleitungen.

Fazit: empfehlenswert!

Ein herzliches Dankeschön an A-Leecon und allen Dozenten

… vor allem Karima Charles – die ihr mir im Laufe der Weiterbildung so viel Neues und Spannendes mit auf den Weg gegeben habt!

A-Leecon als Bildungsträger kann ich nur jedem empfehlen, der ernsthaft sein Wissen erweitern möchte. Die Lernplattform ist sehr intelligent und auf jeden Teilnehmer abgestimmt. Die Dozenten waren immer „Up to date“, erreichbar wenn es Fragen gab, sehr angenehm, herzlich und immer offen für Problemlösungen, Vorschläge oder auch eigene Lernthemen. Auch der Austausch mit anderen Kursteilnehmern war dauerhaft gewährleistet wobei hierdurch noch zusätzliche Lerneffekte erzielt werden konnten.

Als Kursteilnehmer bekommt man genügend Zeit eingeräumt, um das Erlernte umzusetzen, Tools und Werkzeuge zu testen, eigene Erfahrungen zu sammeln und diese wiederum mit den Dozenten und Kursteilnehmern auszutauschen. Unter dem Strich ein sehr gelungenes Konzept – vor allem für Autodidakten wie mich 🙂

Vielen Dank für die schöne Zeit – jederzeit wieder mit Euch!