Pilotprojekt

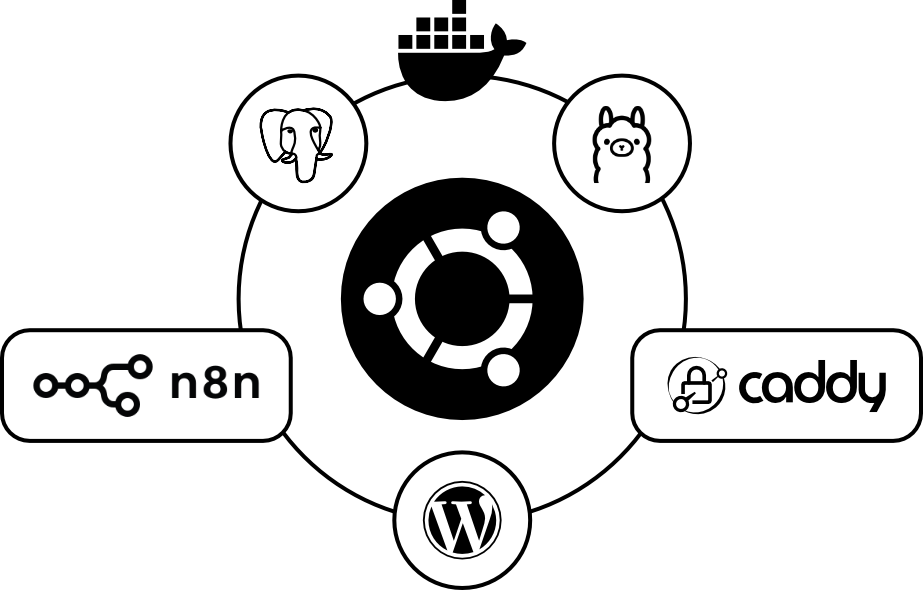

Basierend auf der KI-Readiness-Analyse von LANAKILA Sports hier ein praktischer Ansatz für die Umsetzung des KI Kunden ChatBots mit n8n, Ollama, Postgres Vector Store, Caddy und WooCommerce.

Installation von WordPress sowie n8n, Ollama, Postgres, Caddy mittels Docker.

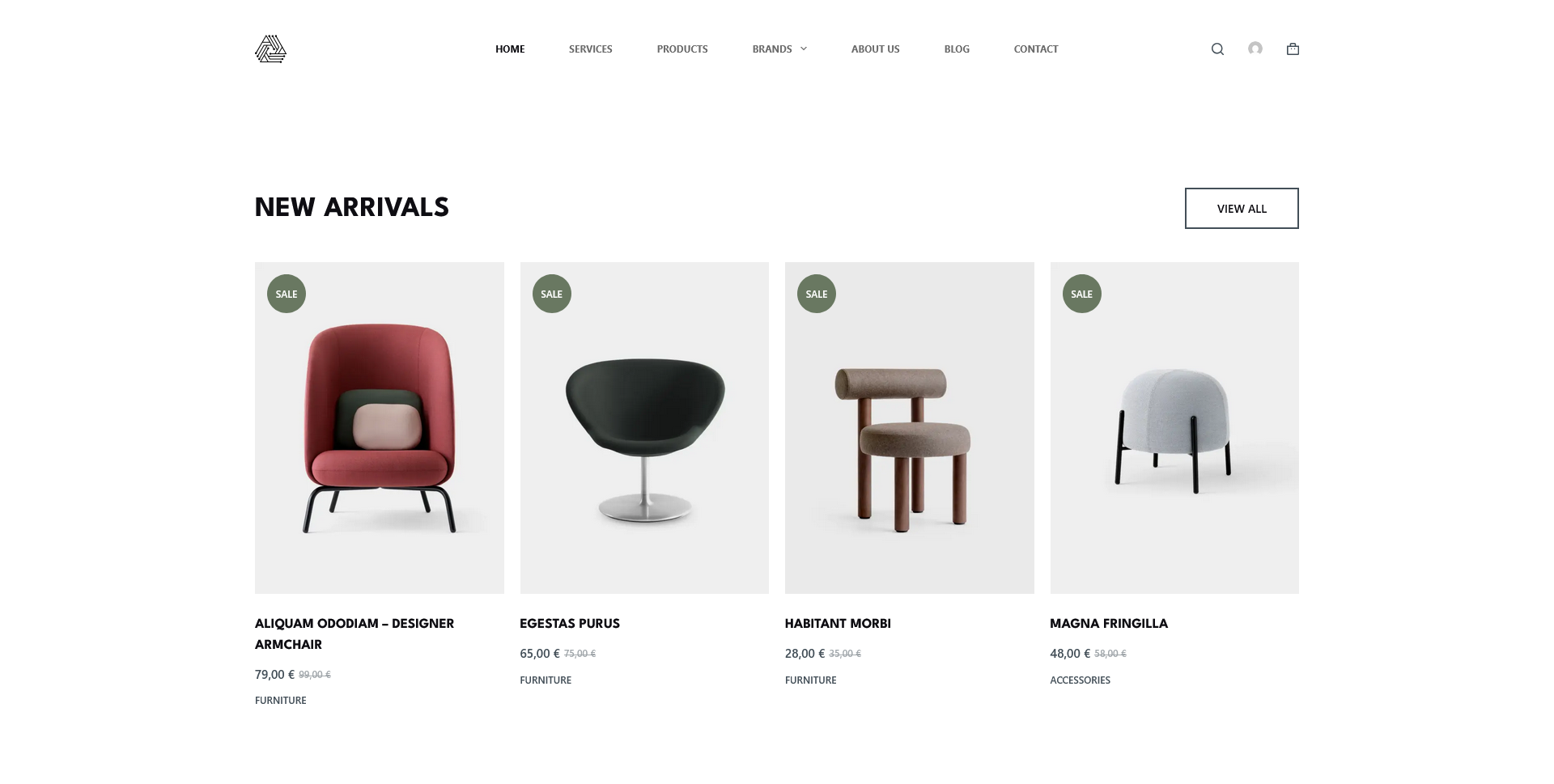

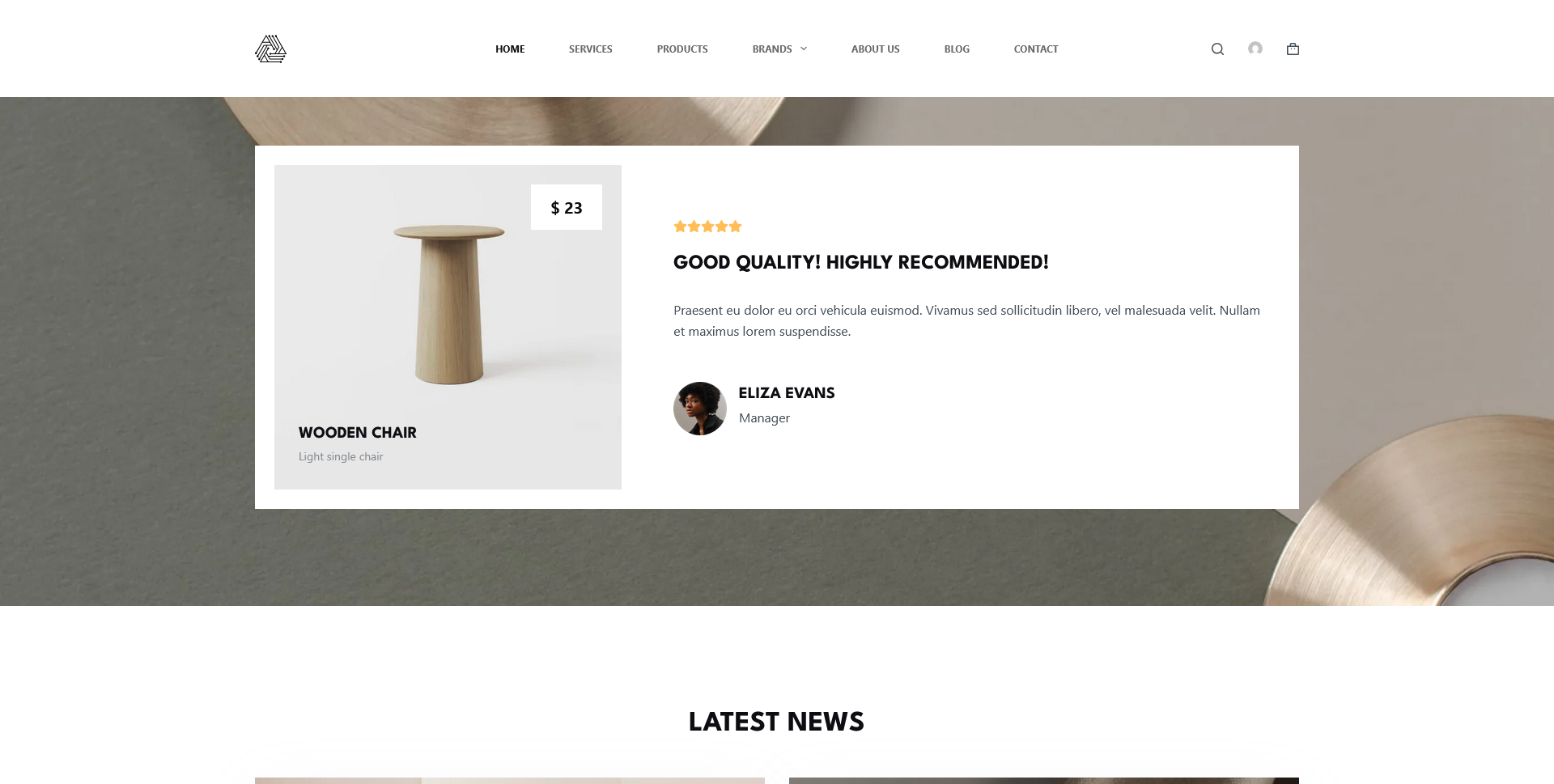

1. WooCommerce Demo Store

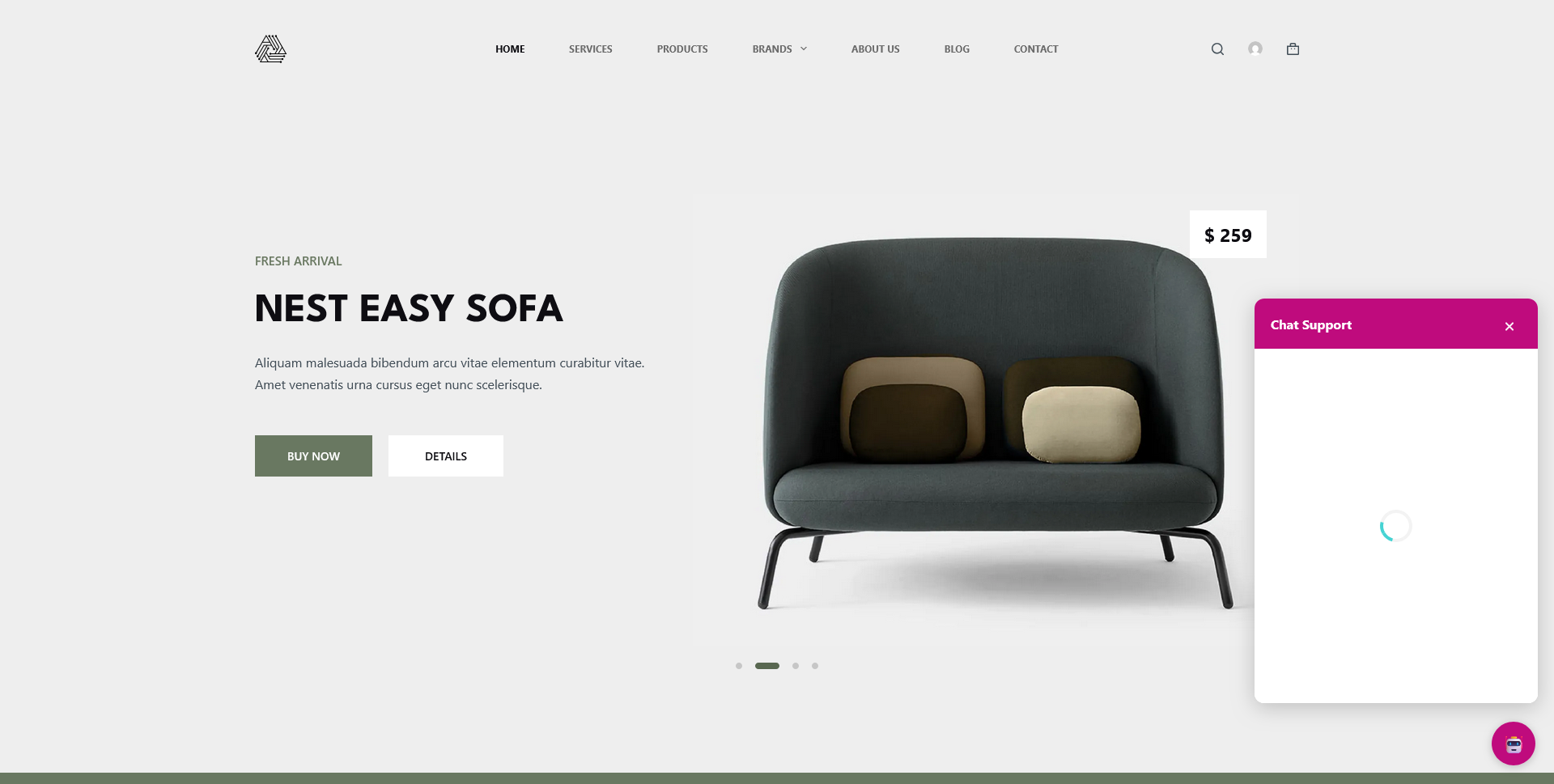

Installation und Einrichtung eines Demo Store (WordPress mit WooCommerce) nebst dem „n8n WordPress Chat Plugin“ auf dem Test-Server.

2. Installation n8n, Ollama, Caddy

Installation von n8n, Postgres-Datenbank-Server, Ollama, zwei Ollama LMM sowie Caddy (fungiert als Reverse Proxy) via Docker auf dem Test-Server.

3. Erstellung des ChatBot Workflows in n8n

Erstellung und Testen des n8n ChatBot Workflow via n8n.

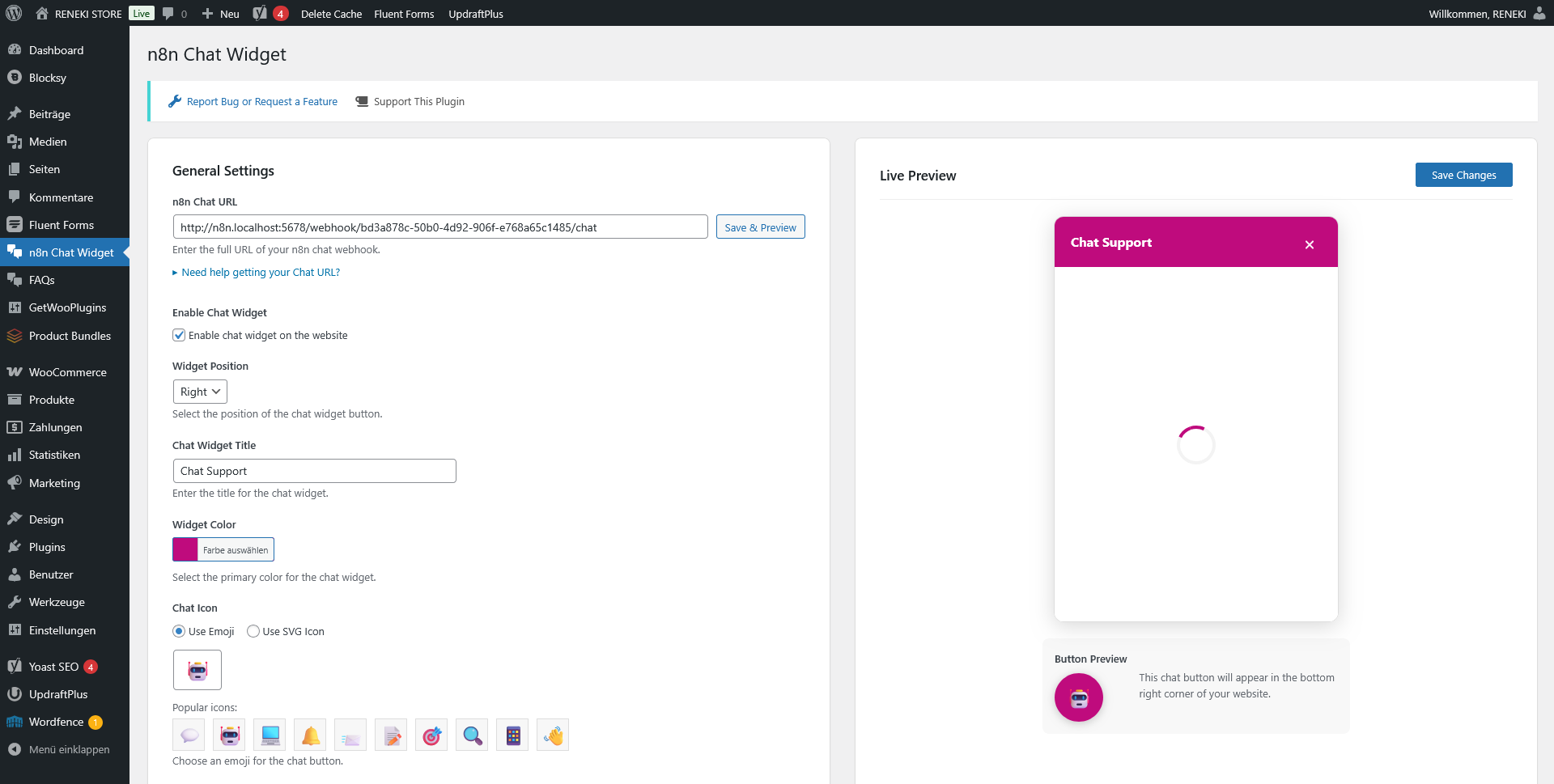

4. Implementierung des n8n ChatBots in WordPress

Implementierung des n8n ChatBots in den Demo Store.

1. Demo Store

Damit die Tests nicht im Live-Shop unter www.lanakilasports.de vorgenommen werden wurde ein Demo Store auf Basis von WordPress mit WooCommerce Plugin auf einem zweiten Server installiert und eingerichtet. Zum Demo Store

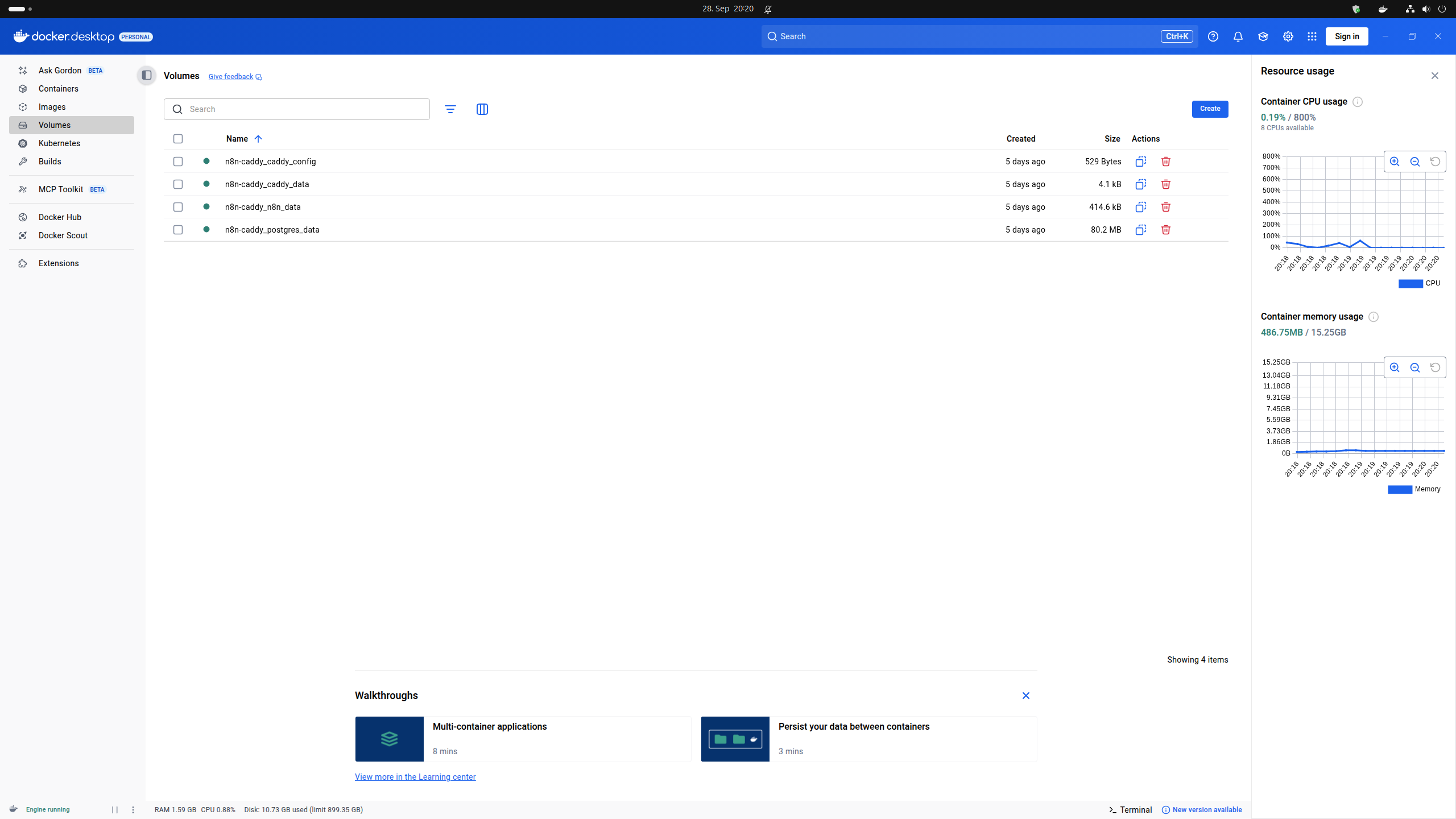

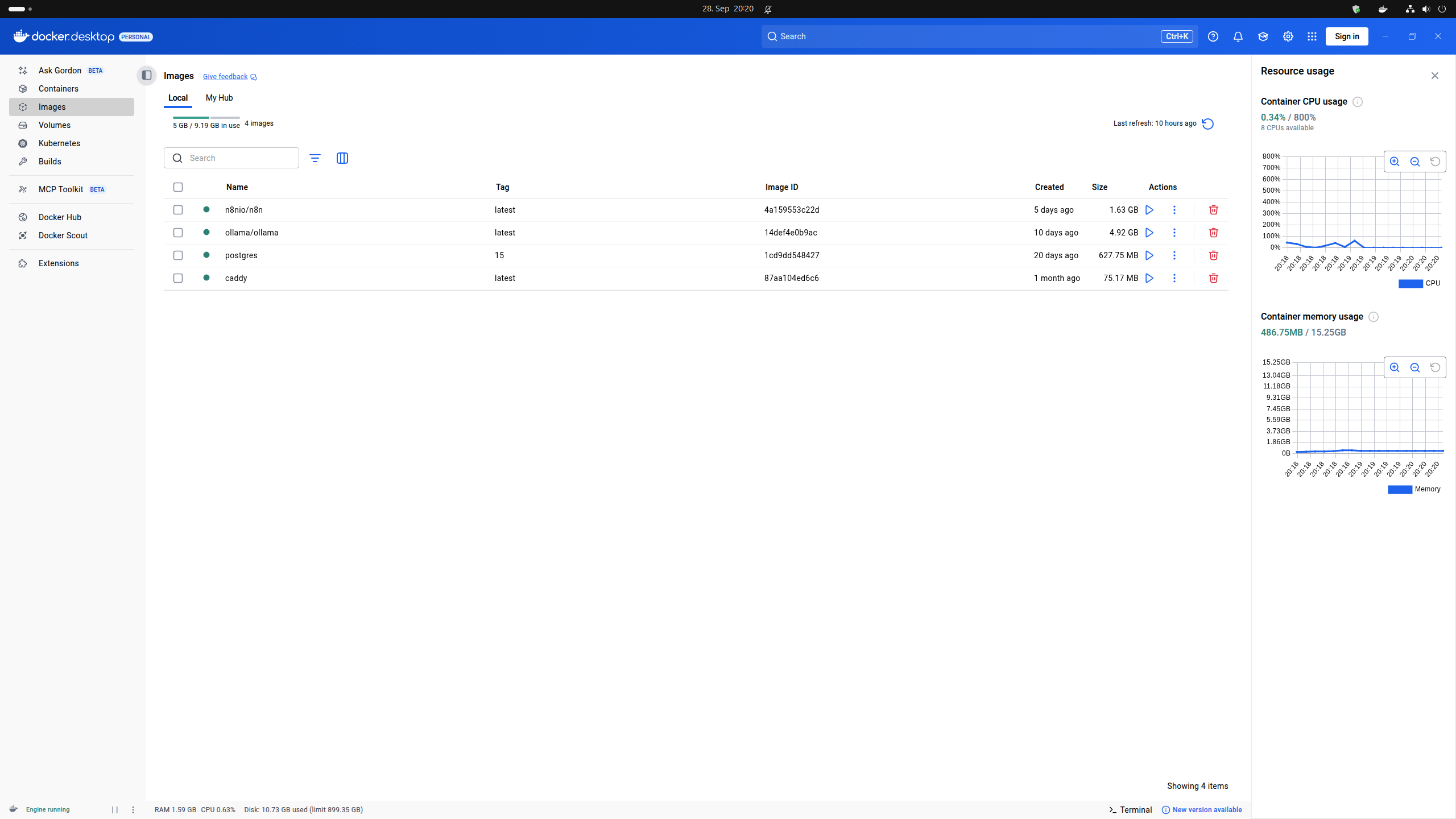

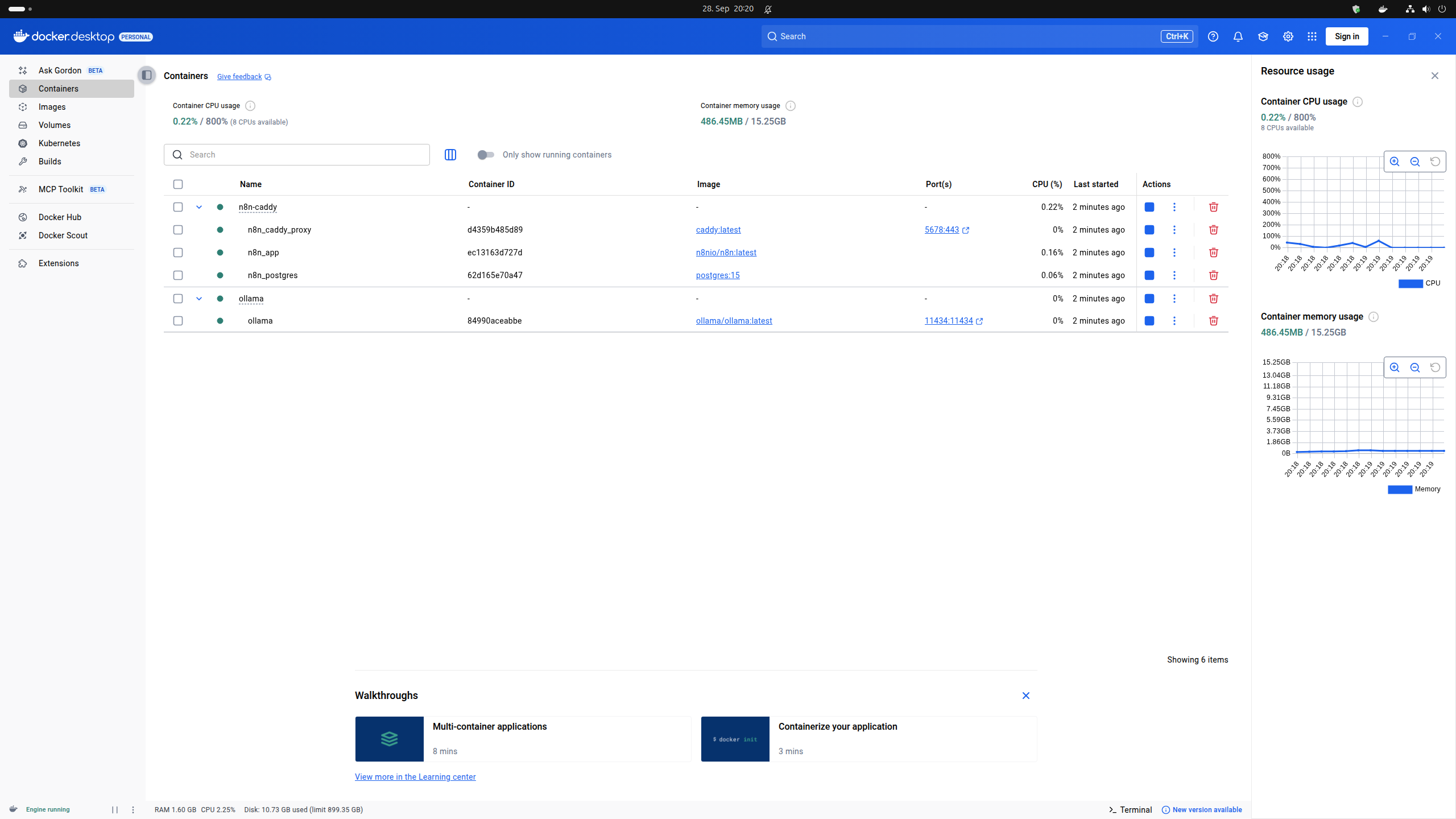

2. Installation n8n, Ollama, Postgres Datenbank Server und Caddy via Docker

Die Schritte zur Installation von n8n, Ollama und Caddy via Docker und Docker Compose sind auf folgender Seite gut dokumentiert.

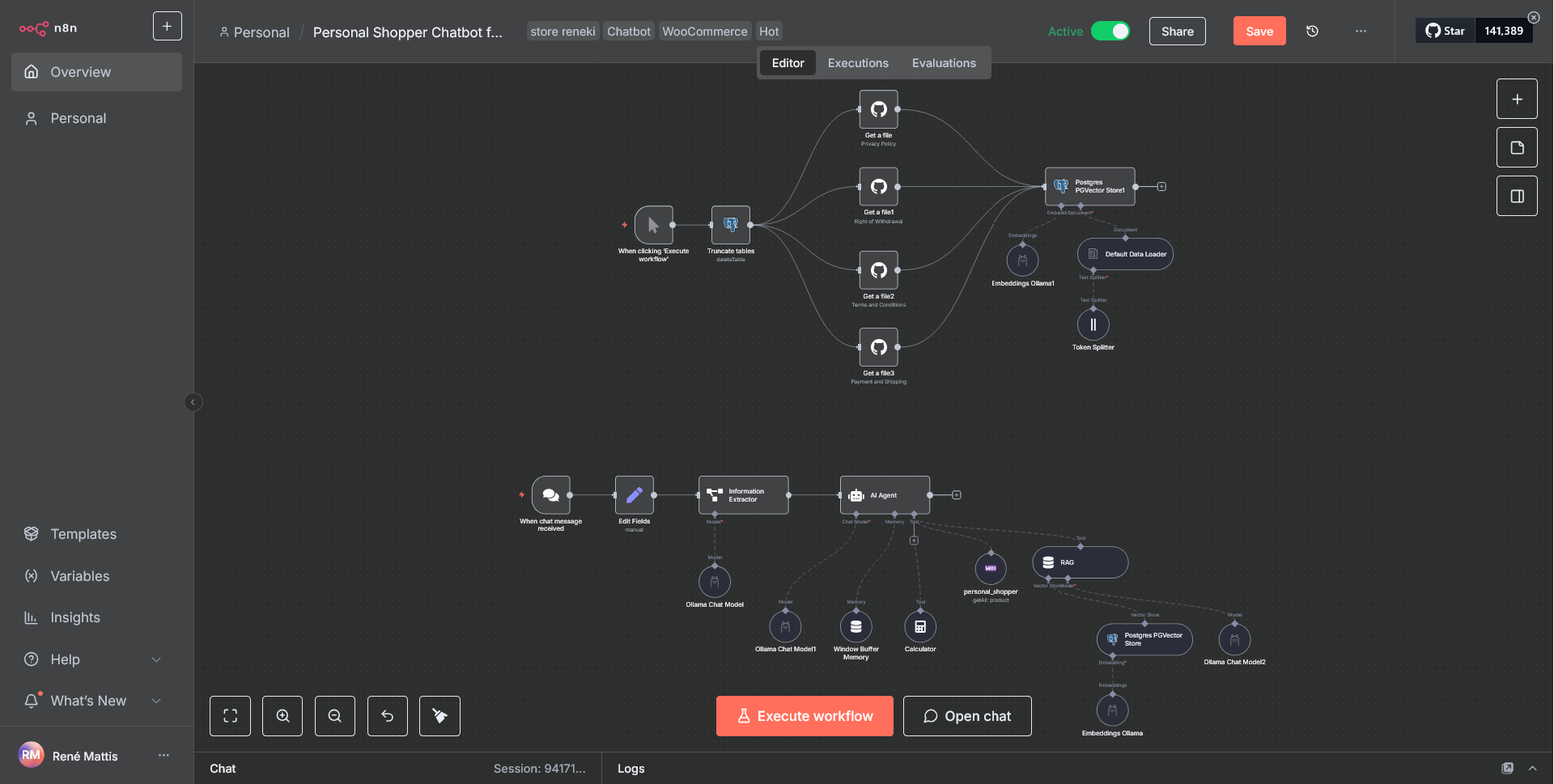

3. Erstellung des ChatBot Workflows

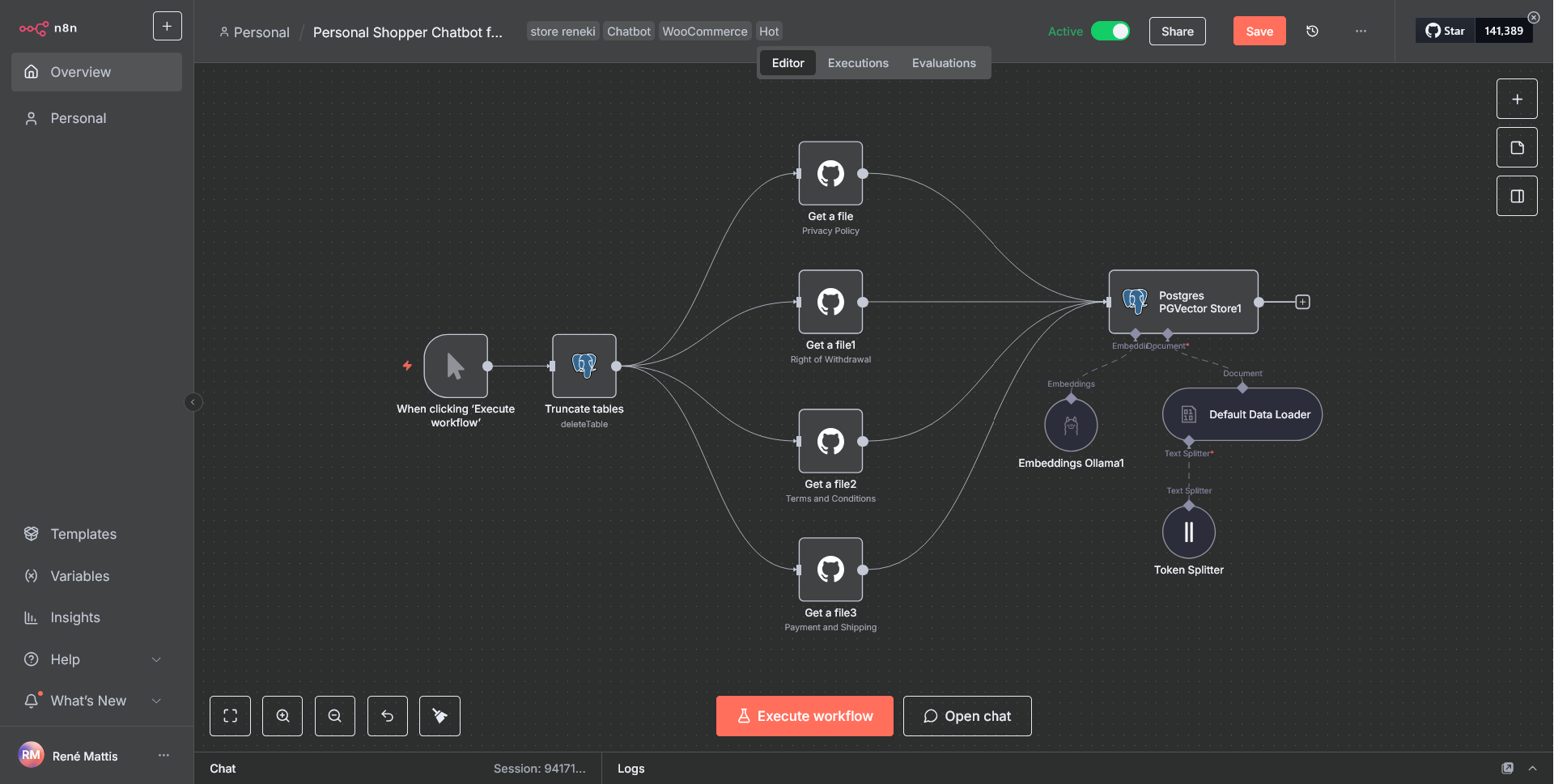

n8n Workflow 1

Postgres Vector-Datenbank

Dieser Workflow sammelt Informationen zu Versandkosten, Datenschutz, Privatsphäre, Widerrufsrechte, AGB und Zahlungsoptionen und speichert diese anschließend in einer eigens dafür angelegten Postgres Vector-Datenbank auf dem Test-Server. Die Dateien liegen alle in einem GitHub Repo und werden von da aus über den Workflow eingelesen und verarbeitet.

Hintergrund: sucht der User via unserem ChatBot nach Informationen zu diesen Themen und nicht speziell zu einem Produkt wird der ChatBot angewiesen, die Antworten aus dieser Vector-Datenbank zu beziehen.

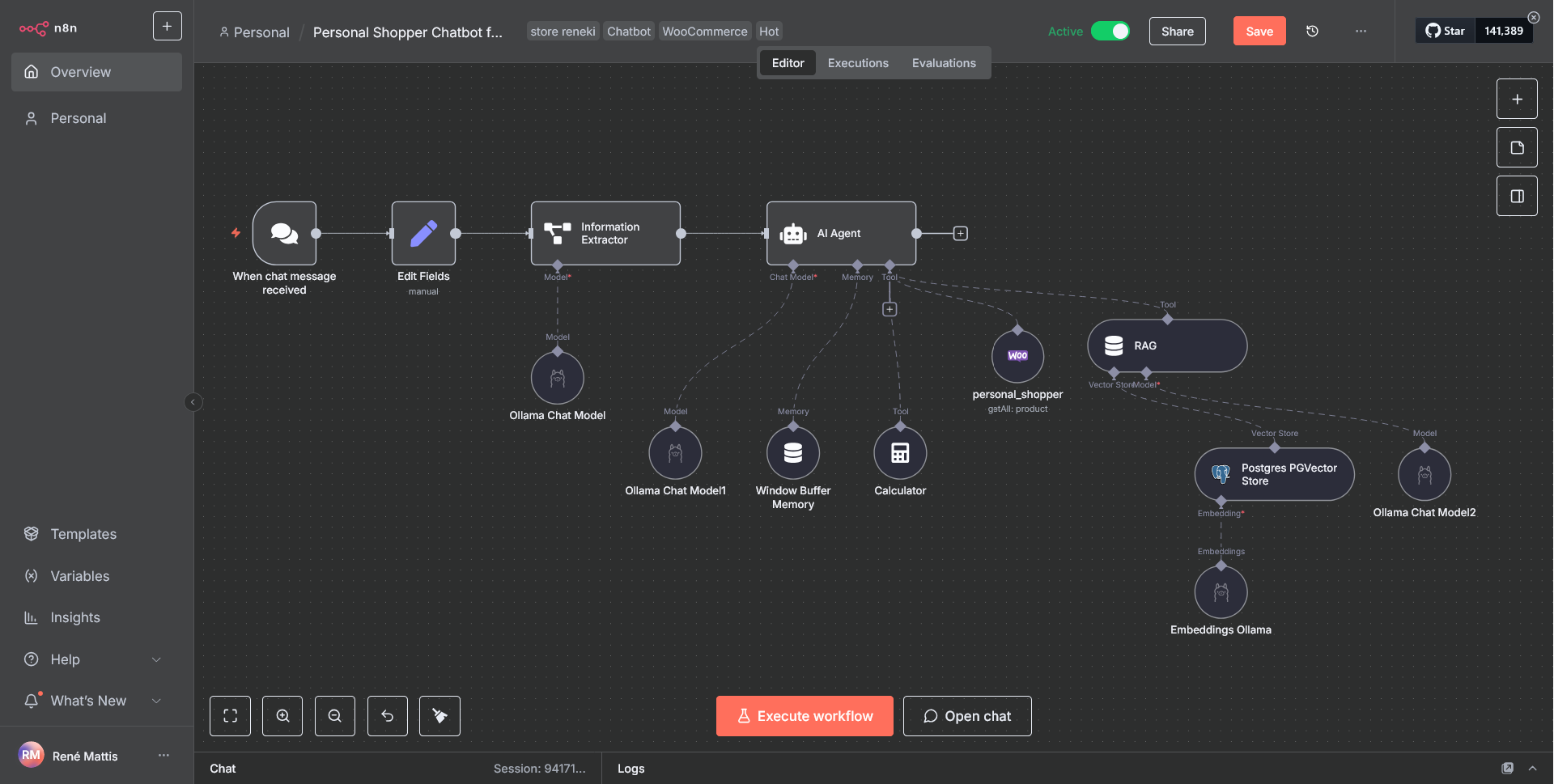

n8n Workflow 2

n8n Kunden ChatBot

Dieser Workflow ist das Herzstück des Kunden ChatBots. Im ersten Node wird mit Hilfe des Ollama ChatModels und dem LMM „llama3.2:3b“ die Chat-Eingabe des Users untersucht. Die KI erkennt dabei, ob der User nach Produktinformationen oder eine allgemeine Anfrage – z.B. zu Versandkosten, Rückgabe, Lieferzeiten etc. – hat. Der moderierte KI-Agent greift dann entweder auf die RAG / Postgres Vector-Datenbank via Ollama Embeddings (LMM „embeddinggemma“) zu oder formuliert eine entsprechende Datenbankabfrage (via WooCommerce Rest API). Hierbei ist der KI-Agent so moderiert, dass er versteht, ob eine bestimmte Artikelnummer abgefragt wurde und/oder ein Maximalpreis oder auch eine spezifische Kategorie.

Der Open Source Ansatz

Warum ein selbst-gehostetes n8n, Ollama?

Gewählt wurde zielgerichtet der Einsatz von Open Source Applikationen – zum Einen aus Gründen des Datenschutzes und letzlich auch aus kostengründen. Es konnte zudem getestet werden, ob der eingesetzte Server den Anforderungen für den Einsatz eines KI Kunden-ChatBots mit n8n und Ollama entspricht. Fazit: dieses Pilotprojekt hat deutlich gezeigt, dass der Einsatz von KI mittels selbstgehostetem n8n, Ollama und LMMs durchaus machbar ist allerdings einen sehr leistungsstarken Server, viel technisches Know-How sowie die Lust & Zeit am Ausprobieren voraussetzt.

"Wer immer tut, was er schon kann, bleibt immer das, was er schon ist."

– Henry Ford –