Pilotprojekt

KI-Readiness-Analyse „LANAKILA SPORTS"

LANAKILA SPORTS ist ein 2017 gegründetes mittelständisches Unternehmen mit Sitz in Sachsen, das sich auf nachhaltige, maßgeschneiderte Sportbekleidung für Triathlon, Radfahren, Laufen und Schwimmen spezialisiert hat. Das Geschäftsmodell kombiniert Individualisierung, Nachhaltigkeit (Produktion nach Bestellung, Verwendung recycelter Materialien), hochwertiges Design und eine große Community als Differenzierungsfaktoren im Wettbewerb. Vor dem Hintergrund zunehmender Marktdynamik, wachsender Kundenerwartungen an Schnelligkeit, Personalisierung und Service sowie des steigenden Drucks durch Wettbewerber, bietet der Einsatz von Künstlicher Intelligenz (KI) signifikante Chancen für Effizienzsteigerung, Kostenoptimierung und Kundenzufriedenheit.

https://www.instagram.com/lanakilasports/?hl=de

1. Analyse der Ausgangssituation

1. Unternehmensziele & Strategie

- Welche strategischen Unternehmensziele verfolgen Sie aktuell (z. B. Wachstum, Effizienzsteigerung, Kundenzufriedenheit, Innovation)?

- Gibt es bereits eine Digitalisierungs- oder Innovationsstrategie, in die KI eingebettet werden könnte?

- Welche Wettbewerbsvorteile erhoffen Sie sich von KI?

2. Prozesse & Arbeitsabläufe

- Welche Geschäftsprozesse verursachen derzeit die größten Kosten oder Engpässe?

- Wo gibt es wiederkehrende, regelbasierte Aufgaben, die automatisiert werden könnten?

- Welche Prozesse sind für den Unternehmenserfolg besonders kritisch (z. B. Vertrieb, Produktion, Kundenservice)?

- Gibt es bereits erste Erfahrungen mit Automatisierung oder KI (z. B. RPA, Chatbots, Predictive Analytics)?

3. Daten & Infrastruktur

- Welche Daten liegen aktuell vor (z. B. Kundendaten, Produktionsdaten, Logistikdaten)?

- In welchen Formaten und Systemen sind diese Daten gespeichert (ERP, CRM, Excel, Datenbanken)?

- Wie ist die Datenqualität (vollständig, konsistent, aktuell)?

- Gibt es bereits eine Datenstrategie oder ein Data-Governance-Modell?

- Welche IT-Infrastruktur (Cloud, On-Premise, Hybrid) wird genutzt?

4. Mitarbeiter & Kompetenzen

- Welche Fachbereiche sind offen für KI-gestützte Prozesse?

- Gibt es interne Kompetenzen im Bereich Datenanalyse, KI oder Automatisierung?

- Wie stehen die Mitarbeiter dem Thema KI gegenüber (Neugier, Skepsis, Sorge um Arbeitsplatzverlust)?

- Gibt es Schulungsprogramme oder Weiterbildungsinitiativen zu Digitalisierung?

5. Kunden & Markt

- Welche Erwartungen haben Kunden an Ihr Unternehmen in Bezug auf Service, Geschwindigkeit, Individualisierung?

- Gibt es Marktentwicklungen oder Wettbewerber, die bereits KI einsetzen?

- Welche Anforderungen an Datenschutz und Sicherheit erwarten Ihre Kunden?

6. Recht & Compliance

- Unterliegt das Unternehmen strengen regulatorischen Vorgaben (z. B. DSGVO, branchenspezifische Regularien)?

- Gibt es Compliance-Richtlinien, die beim Einsatz von KI berücksichtigt werden müssen?

7. Wirtschaftlichkeit & Investitionsrahmen

- Welches Budget steht für KI-Pilotprojekte zur Verfügung?

- Gibt es konkrete Erwartungen an den ROI (Return on Investment)?

- Welche Bereiche sollen vorrangig einen messbaren Nutzen von KI zeigen?

2. Untersuchung Unternehmensbereiche und Prozesse

1. Kunden

- Chatbot auf der Webseite

- automatische Beantwortung von E-Mail-Anfragen

2. Marketing

- automatische Newsletter-Generierung

- automatische Sozial Media Posts

3. Produktion

- automatische Produktbilderstellung

- automatische, SEO-optimierte Produktbeschreibungen

4. Mitbewerber

- Konkurrenzanalyse (Marktentwicklung, Preisentwicklung)

3. KI-Readiness-Bewertung

1. Bewertungsdimensionen

Die Analyse erfolgt entlang von 7 Dimensionen, die für eine erfolgreiche Einführung von KI entscheidend sind:

1. Strategie & Vision – Gibt es eine klare Vorstellung, welchen Beitrag KI zur Unternehmensstrategie leisten soll?

2. Prozesse & Use Cases – Sind relevante Anwendungsfelder identifiziert und priorisiert?

3. Daten & Technologie – Wie ist die Verfügbarkeit, Qualität und Nutzbarkeit der Unternehmensdaten sowie die technologische Infrastruktur?

4. Organisation & Kultur – Wie offen sind Mitarbeiter und Führungskräfte für KI? Gibt es Veränderungsbereitschaft?

5. Kompetenzen & Skills – Verfügt das Unternehmen über Daten-, Analyse- und KI-Know-how intern oder durch Partner?

6. Governance & Compliance – Sind Datenschutz, Ethik und rechtliche Rahmenbedingungen berücksichtigt?

7. Investitionsbereitschaft & Ressourcen – Stehen Budget, Zeit und Personal für Pilotprojekte und Skalierung bereit?

2. Reifegradmodell (5 Stufen)

Jede Dimension wird auf einer Skala von 1 bis 5 bewertet:

1. Initial – Kein Bewusstsein, keine Maßnahmen.

2. Experimentell – Erste Diskussionen, Pilotideen, aber unstrukturiert.

3. Definiert – Strategien, erste Projekte und Verantwortlichkeiten sind klar.

4. Implementiert – KI wird produktiv in einzelnen Bereichen eingesetzt, messbarer Nutzen sichtbar.

5. Optimiert – KI ist integraler Bestandteil der Wertschöpfung, kontinuierliche Optimierung und Innovation.

3. Bewertungsinstrument

Fragebogen / Interviews: Pro Dimension 5–8 gezielte Fragen (z. B. aus dem Fragenkatalog von eben).

Punktesystem: Jede Antwort wird in den Reifegrad eingeordnet (1–5 Punkte).

Scoring: Durchschnittswerte je Dimension und Gesamt-Readiness-Score (zwischen 7 und 35 Punkten).

4. Ergebnisdarstellung

Radar-/Spider-Chart: Visualisierung der Stärken und Schwächen je Dimension.

Heatmap: Übersicht über die Bereiche mit höchster Handlungspriorität.

Roadmap-Empfehlung:

- Quick-Wins (kurzfristig, geringe Hürde, hoher Nutzen)

- Mid-Term-Projekte (mittelfristig mit klarer ROI-Erwartung)

- Long-Term-Vision (z. B. datengetriebenes Geschäftsmodell, KI-gestützte Innovationen)

5. Vorgehensweise im Projekt

1. Kick-off & Erwartungsmanagement

2. Datenerhebung (Interviews, Workshops, Dokumentenanalyse)

3. Scoring & Auswertung

4. Präsentation der Ergebnisse (mit Reifegradprofil)

5. Ableitung einer KI-Roadmap mit klaren Handlungsempfehlungen

2. Identifikation von KI-Potenzialen

Potenzielle Einsatzbereiche für KI bei LANAKILA

- Kunden Chatbot auf der Webseite

- automatische Generierung + Veröffentlichung von Social Media Posts

- automatische Produktbilderstellung

- automatische Generierung SEO-optimierter Produktbeschreibungen

- Konkurrenzanalysen (z.B. wöchentlich per E-Mail)

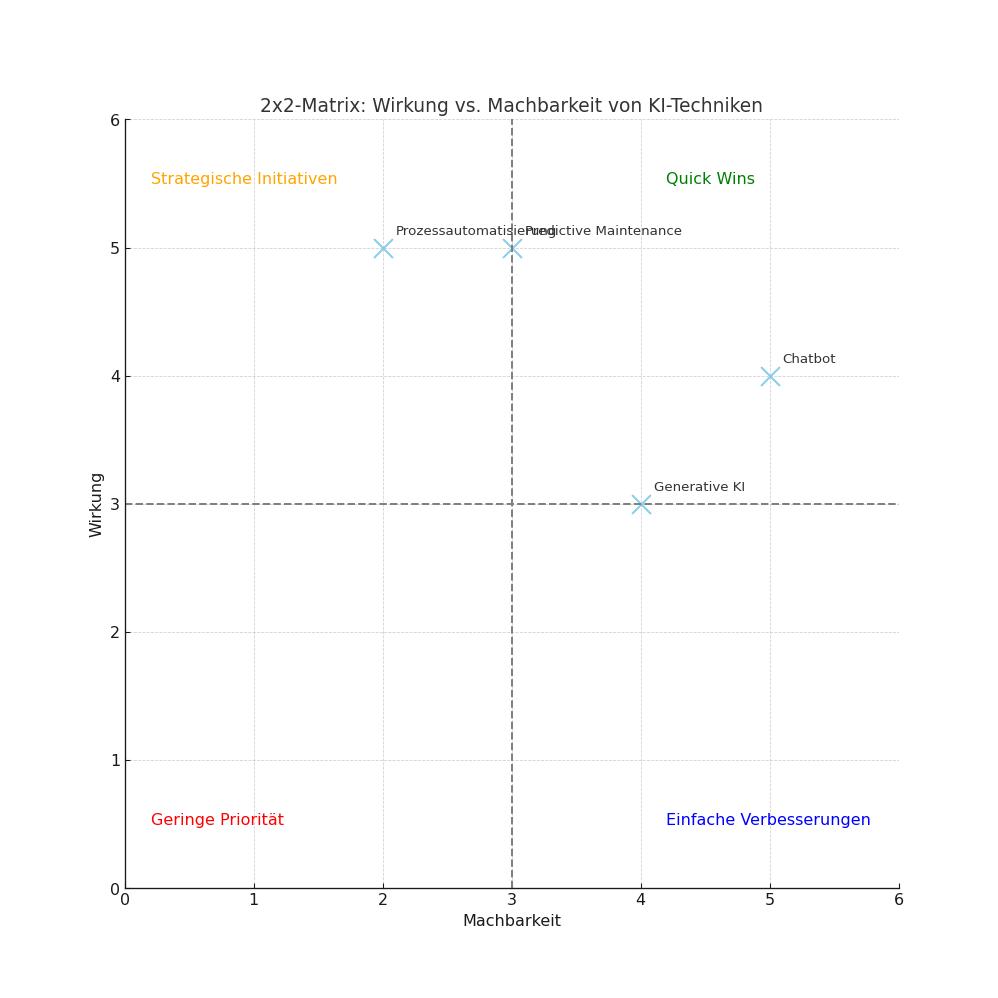

Priorisierung nach Machbarkeit und erwarteter Wirkung

1. Kriterien definieren

Die Bewertung erfolgt entlang von zwei Hauptachsen:

Wirkung (Impact):

- Geschäftswert (Kostenersparnis, Umsatzsteigerung)

- Beitrag zur Unternehmensstrategie

- Verbesserung der Kundenzufriedenheit

- Innovationspotenzial

Machbarkeit (Feasibility):

- Datenverfügbarkeit und -qualität

- Technologische Voraussetzungen (Systeme, Infrastruktur)

- interne Kompetenzen oder Partnerzugang

- rechtliche/regulatorische Machbarkeit

2. Bewertungsraster

Jede KI-Technik (z. B. Chatbots, Predictive Maintenance, Prozessautomatisierung, Generative KI für Marketing) wird entlang der Kriterien 1–5 Punkte bewertet:

1 = sehr gering

5 = sehr hoch

KI-Technik | Wirkung | Machbarkeit | Priorität | Bemerkungen |

Chatbot im Kundenservice | 4 | 5 | 20 | Schneller Quick-Win |

Predictive Maintenance | 5 | 3 | 15 | Hoher Nutzen, aber Datenqualität prüfen |

Generative KI für Texte | 3 | 4 | 12 | Marketing-Optimierung möglich |

Prozessautomatisierung/ Produktbilderstellung | 5 | 2 | 10 | Technische Hürden hoch |

3. Visualisierung / 2×2-Matrix („Impact vs. Machbarkeit“)

oben rechts:

Quick Wins (hoher Impact, hohe Machbarkeit) → sofort starten

oben links:

Strategische Initiativen (hoher Impact, geringe Machbarkeit) → vorbereiten, langfristig planen

unten rechts:

Einfache Verbesserungen (niedriger Impact, hohe Machbarkeit) → optional für schnelle Erfolge

unten links:

Low Priority (niedriger Impact, geringe Machbarkeit) → nicht priorisieren

Der Chatbot im Kundenservice vereint hohe Wirkung und hohe Machbarkeit – er liefert schnelle Erfolge bei vergleichsweise geringen Risiken. Damit ist er ein idealer Einstiegs-Use-Case für KI, der Vertrauen schafft und den Weg für komplexere Projekte ebnet.

Warum Chatbots im Kundenservice besonders vielversprechend sind:

1. Hoher Geschäftswert (Impact)

- Kostensenkung: Viele Anfragen im Kundenservice sind wiederkehrend (z. B. Lieferstatus, Rechnungen, FAQs). Ein Chatbot kann einen großen Teil dieser Anfragen automatisiert abwickeln, was Personalkosten reduziert.

- 24/7 Erreichbarkeit: Kunden erhalten sofort Antworten – unabhängig von Arbeitszeiten. Dies steigert Kundenzufriedenheit und Wettbewerbsfähigkeit.

- Skalierbarkeit: Ein Chatbot kann problemlos Tausende parallele Anfragen bedienen – im Gegensatz zu menschlichen Mitarbeitern.

2. Hohe Machbarkeit (Feasibility)

- Gute Datenbasis: FAQs, E-Mail-Templates und Support-Wissen sind in der Regel bereits vorhanden und lassen sich für Training nutzen.

- Technologische Reife: Chatbot-Lösungen sind marktreif und in verschiedensten Varianten verfügbar (z. B. integrierbar in Website, WhatsApp, CRM).

- Geringe Einstiegshürde: Im Gegensatz zu komplexeren KI-Anwendungen (z. B. Predictive Maintenance) ist kein aufwendiges Datenengineering notwendig.

3. Schnelle Erfolge (Quick Wins)

- Chatbots können in wenigen Wochen pilotiert und produktiv eingesetzt werden.

- Erste messbare Ergebnisse wie Kostensenkung, schnellere Bearbeitung und Kundenzufriedenheit sind kurzfristig erreichbar.

- Pilotprojekte lassen sich mit klar umrissenen Use Cases starten (z. B. „Lieferstatus abfragen“) und sukzessive ausbauen.

4. Positive Wirkung auf Mitarbeiter und Organisation

- Entlastung der Servicemitarbeiter von Routineaufgaben → mehr Fokus auf komplexe, wertschöpfende Tätigkeiten.

- Mitarbeiterakzeptanz ist höher, weil sie nicht ersetzt, sondern unterstützt werden.

- Chatbots fördern die Akzeptanz von KI im Unternehmen, da der Nutzen für alle Stakeholder sichtbar ist.

5. Langfristige Perspektive

- Ein Chatbot kann sukzessive erweitert werden: von einfachen FAQ-Bots → zu intelligenten Assistenten mit NLP (Natural Language Processing) → bis hin zu Omnichannel-Integration (E-Mail, Telefon, Chat, Social Media).

- Damit wird der Chatbot ein zentraler Baustein der Digital Customer Experience.

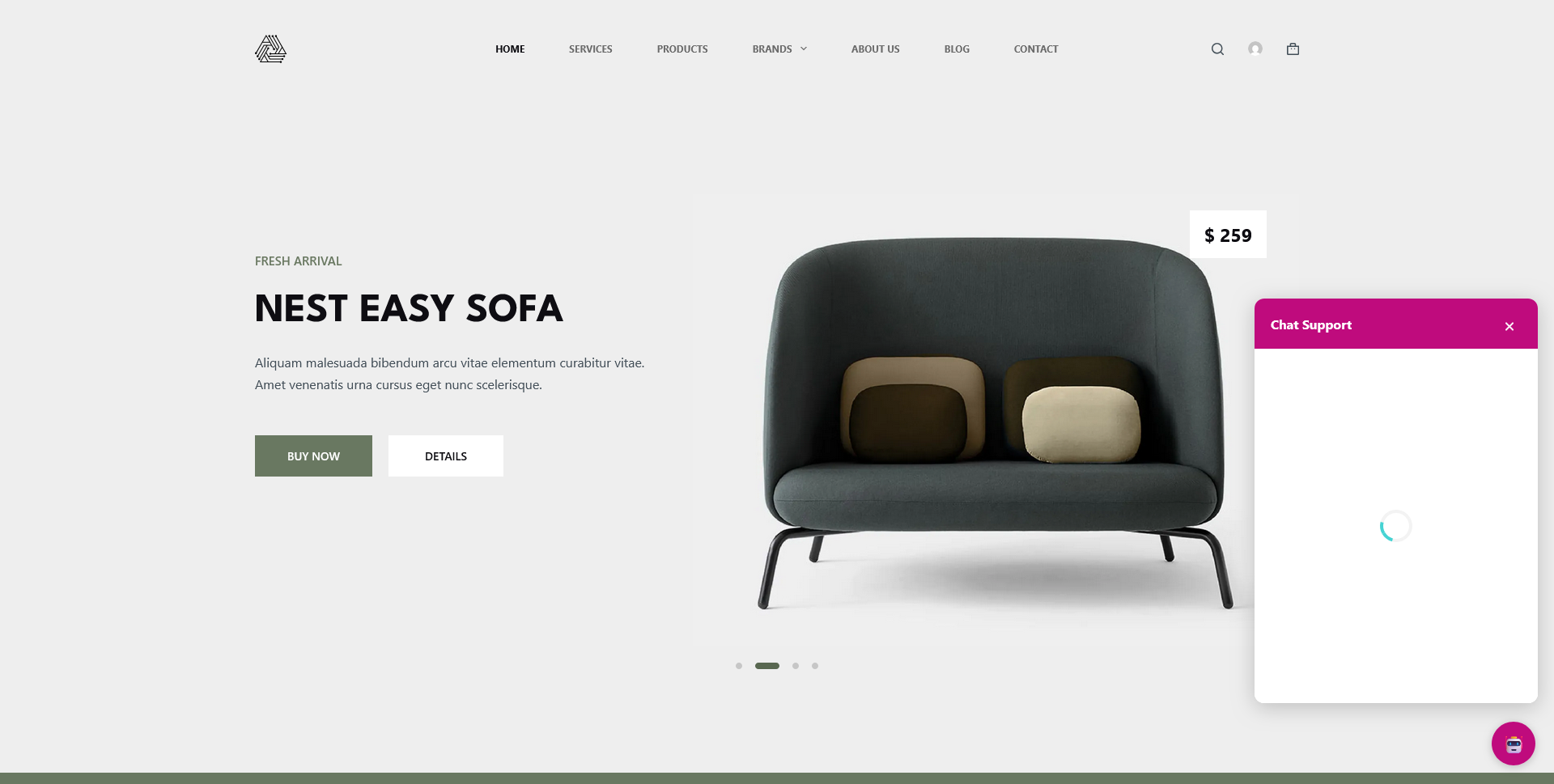

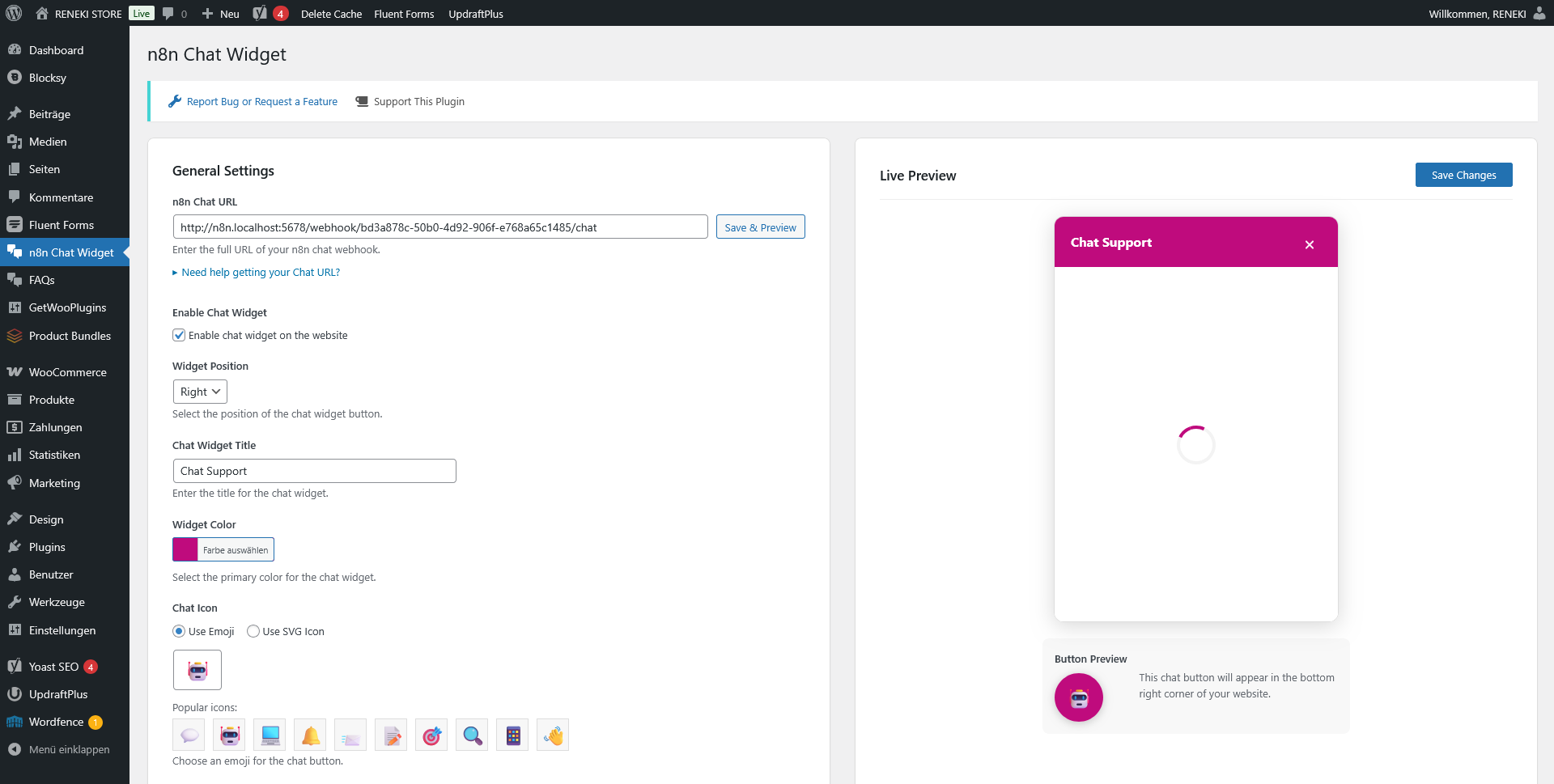

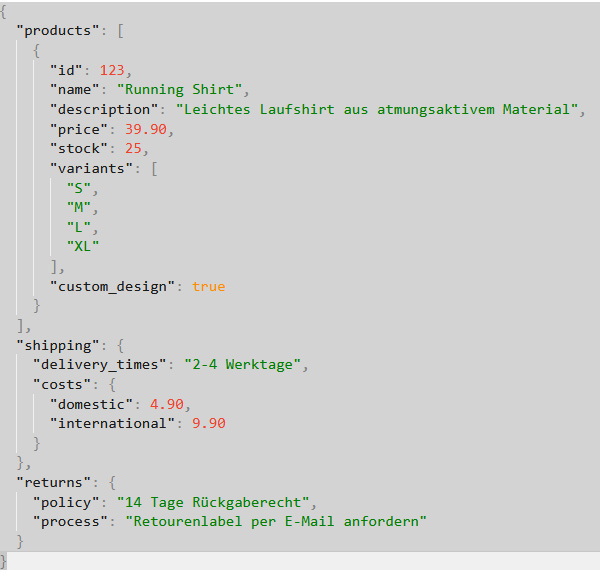

3. Konzeption eines KI-Pilotprojekts

Als Pilotprojekt soll ein Kunden Chatbot auf einer eigens dafür eingerichteten Test-Seite (WordPress mit WooCommerce /Webshop) realisiert werden. Dieser Chatbot soll dem Kunden Fragen und Empfehlungen zu den hinterlegten Produkten aber auch zu Lieferzeiten, Versandkosten, individualisierten Designs (Custom Designs) sowie Retouren-Abwicklung beantworten.

Projektplan / Meilensteine

Projektziele

- Einführung eines KI-gestützten Chatbots für die Kundenkommunikation

- Automatisierte Beantwortung von Fragen zu:

+ Produkten (Empfehlungen, Varianten, Größen etc.)

+ Lieferzeiten & Versandkosten

+ Retourenabwicklung

+ Individualisierte Designs (Custom Designs) - Stündliche Bereitstellung einer strukturierten JSON-Datei (via Cronjob)

aus der WordPress-Datenbank zur Aktualisierung der Chatbot-Wissensbasis

Projektphasen & Meilensteine

Phase 1 – Anforderungsanalyse & Konzeption (2–3 Wochen)

Meilensteine:

- Kick-off-Workshop mit Stakeholdern.

- Definition der Use Cases (z. B. Produktempfehlungen, Retourenprozess).

- Technische Analyse:

+ WooCommerce-Datenstruktur (Produkte, Lagerbestand, Versandregeln).

+ Identifikation der relevanten Tabellen/Custom Fields.

+ Entscheidung: Hosting & Integration des Chatbots

(z. B. eigenes Plugin, externer Anbieter, API).

Phase 2 – Architektur & Datenaufbereitung (3–4 Wochen)

Meilensteine:

- Entwurf der Datenstruktur für die JSON-Datei (Produkte, Versand, Retouren, Designs).

- Entwicklung des Cronjobs:

+ Export relevanter Daten z.B. stündlich.

+ JSON-Datei im definierten Schema erzeugen.

+ Ablage in sicherem Verzeichnis oder Übergabe via API.

+ Test der JSON-Generierung mit Beispielinhalten.

Phase 3 – Chatbot-Entwicklung & Integration (4–6 Wochen)

Meilensteine:

- Auswahl/Entwicklung des Chatbot-Frameworks (z. B. n8n, Flowise, GPT-Integration)

- Anbindung an die JSON-Datei als Wissensbasis

- Aufbau von Intent- und Antwortlogiken:

+ Produktanfragen (Preis, Verfügbarkeit, Größe, Farbe)

+ Lieferzeiten & Versandkosten

+ Retourenprozess

+ Custom Design Anfragen - UI-Integration des Chatbots in die WordPress-Webseite (z. B. als Widget)

- Interne Tests (Produktdaten, typische Kundenfragen simulieren)

Phase 4 – Testing & Optimierung (2–3 Wochen)

Meilensteine:

- Technische Tests: JSON-Aktualisierung, Cronjob-Stabilität, Ladezeiten

- Funktionale Tests: Kundenfragen → Antworten

- UX-Tests: Nutzerfreundlichkeit, mobile Darstellung

- Optimierung von Antwortqualität & Performance

Phase 5 – Go-Live & Monitoring (1–2 Wochen)

Meilensteine:

- Finaler Rollout auf Test-Domain/ Webshop

- Monitoring von Chatverläufen und Systemlast

- Einrichtung von Feedback-Kanälen (z. B. Bewertung der Antworten)

- Dokumentation & Schulung interner Mitarbeiter

Phase 6 – Betrieb & Weiterentwicklung (laufend)

Meilensteine:

- Regelmäßige Updates & Erweiterungen (z. B. neue Produkte, FAQ-Erweiterung)

- Optimierung durch Kundenfeedback

- Erweiterung auf weitere Kanäle (z. B. WhatsApp, Instagram)

Zeitplan (grobe Schätzung)

- Gesamtprojektdauer: ca. 12–16 Wochen bis zum Go-Live

- Danach: kontinuierliche Optimierung

Resourcenbedarf

1. Personalbedarf

Für die Einführung des Chatbots sind typischerweise mehrere Rollen beteiligt. Je nach Größe des Teams können Rollen kombiniert werden:

- Projektleitung / Product Owner (ca. 10–20 % Kapazität über die Projektlaufzeit)

+ Steuerung, Abstimmung mit Stakeholdern, Priorisierung - Technischer Entwickler (1 FTE über ~12 Wochen)

+ Entwicklung des Cronjobs (JSON-Export)

+ Integration in WordPress/WooCommerce

+ API-Schnittstellen zum Chatbot - KI-/Chatbot-Entwickler (1 FTE über ~12 Wochen)

+ Einrichtung der Chatbot-Plattform/ Workflow-Tool

+ Training von Intents & Antwortlogiken

+ Anbindung an die JSON-Datenquelle - Frontend-/Webentwickler (0,5 FTE über ~4 Wochen)

+ Einbindung Chatbot-Widget ins WordPress-Frontend

+ Anpassung an CI/CD der Website (Design, UX) - QA/Tester (0,5 FTE über ~3 Wochen)

+ Funktionstests, UX-Tests, End-to-End-Prüfungen - Support & Betrieb (laufend, nach Go-Live, ca. 10 % FTE)

+ Monitoring, Optimierung, Content-Pflege

Realistisch kann man mit 2–3 Kernpersonen rechnen, die über die Projektlaufzeit 12–16 Wochen in unterschiedlicher Intensität eingebunden sind.

2. Zeitbedarf

Gesamtprojektdauer: ca. 12–16 Wochen (wie im Projektplan)

Aufwandsschätzung in Personentagen (PT):

- Konzeption & Planung: ~15 PT

- Entwicklung JSON/Cronjob: ~20 PT

- Chatbot-Setup & Training: ~30–40 PT

- Integration Frontend/Widget: ~15 PT

- Test & Optimierung: ~15 PT

- Go-Live & Monitoring: ~5 PT

- Gesamt: ~100–120 PT

3. Budgetbedarf

Die Kosten hängen stark davon ab, ob externe Dienstleister eingebunden werden oder alles intern umgesetzt wird. Orientierungswerte (für Agenturen/Freelancer in Deutschland):

- Tagessatz Entwickler/Consultant: 600–900 €

- Tagessatz Projektleitung: 700–1000 €

Szenario A – Umsetzung mit internen Ressourcen (nur Hosting & Lizenzkosten extern):

- Personalkosten intern → abhängig von Gehältern, nicht direkt Projektbudget

- Externe Tools (Chatbot-Framework, Hosting, evtl. GPT API):

+ ~200–600 €/Monat (bei GPT-Integration abhängig von API-Nutzung)

Szenario B – Umsetzung mit externem Dienstleister:

- 100–120 PT × Ø 750 € = 75.000 – 90.000 €

- Zusatzkosten: Hosting (u.a. HETZNER), API, Monitoring: ca. 5.000 – 8.000 €/Jahr

4. Empfehlung

- Für einen MVP-Chatbot mit Basis-Funktionalität (Produkte, Versand, Retouren, Designs) sollte man mit ca. 3 Monaten Entwicklungszeit und 60–80 PT Aufwand rechnen (~40–60k € bei externer Umsetzung).

- Für eine ausgereifte Lösung mit intelligenter Produktempfehlung & Skalierung eher 100–120 PT (~75–90k €).

- Danach: laufende Kosten für Betrieb, Optimierung & API-Nutzung einplanen.

4. Datenstrategie und Infrastruktur

Diese Datenstrategie stellt sicher, dass der Chatbot verlässlich, skalierbar und compliant arbeitet – und gleichzeitig flexibel genug ist, um später um KI-Features erweitert zu werden.

1. Ziele der Datenstrategie

- Bereitstellung konsistenter, aktueller und strukturierter Produkt- und Serviceinformationen für den Chatbot

- Sicherstellung von Datenqualität (korrekt, aktuell, vollständig)

- Vermeidung redundanter Datenhaltung → Single Source of Truth (WordPress/WooCommerce)

- Einhaltung rechtlicher Anforderungen (DSGVO)

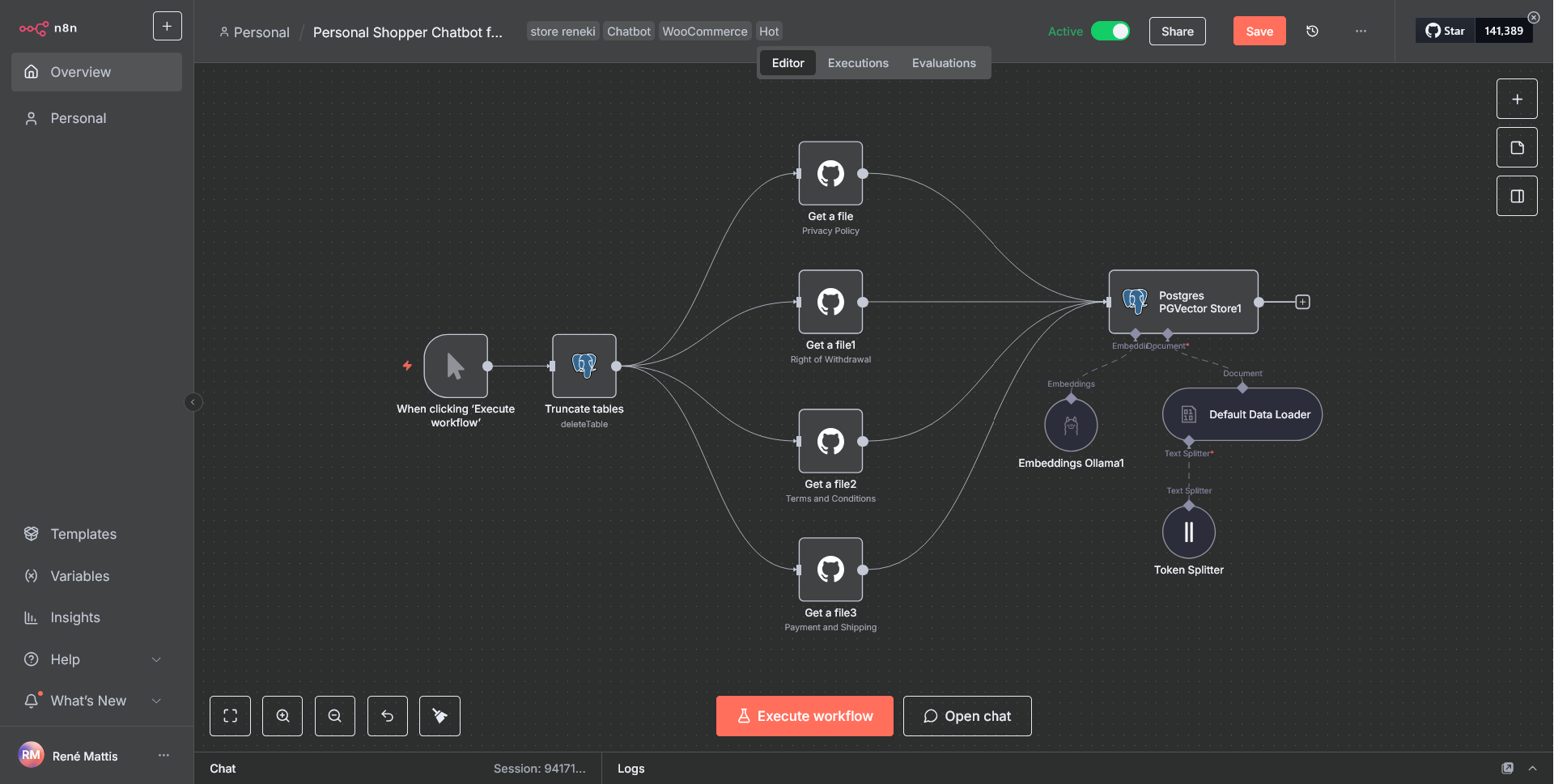

2. Datenquellen & Single Source of Truth

- WordPress/WooCommerce-Datenbank als primäre Datenquelle:

+ Produkte (Name, Beschreibung, Preis, Lagerbestand, Varianten)

+ Versand & Lieferzeiten (WooCommerce Settings + Custom Fields)

+ Retouren-Regeln (eigene Datenbanktabelle oder Policy-Dokumente)

+ Custom Design Optionen (extra definierte, markierte Produkte) - Zusätzliche Quellen (falls benötigt):

+ Interne Dokumente (Retourenrichtlinien, FAQ)

+ CRM-Daten (Bestellhistorie, Kundenservice-Infos → späterer Ausbau)

3. Datenaufbereitung

- Entwicklung eines ETL-Prozesses (Extract – Transform – Load):

+ Extract: Cronjob zieht Daten aus der WordPress/WooCommerce-Datenbank

+ Transform:

+ Umwandlung in ein standardisiertes JSON-Schema

+ Konsolidierung (z. B. Versandkostenregeln in klarer Logik)

+ Normalisierung von Textfeldern (kein HTML, saubere Strings)

+ Load: Ablage im sicheren Verzeichnis oder Push an Chatbot-Daten-Endpoint - Aktualisierungsintervall: stündlich (Cronjob)

4. Datenmodell / JSON-Struktur (Beispielskizze)

5. Datenqualität & Governance

- Validierung bei jeder JSON-Generierung (Schema-Check)

- Monitoring: Fehler-Logging bei Cronjob (E-Mail/Slack Alert)

- Versionierung: JSON-Dateien archivieren (Debugging bei falschen Antworten)

- Ownership:

+ IT/Dev: technische Erstellung und Wartung des Exports

+ E-Commerce-Team: Pflege der Produkt- & Versanddaten in WooCommerce

+ Customer Service: Pflege von Retourenrichtlinien & FAQs

6. Sicherheit & Datenschutz

- Datenschutz (DSGVO):

+ Keine Speicherung personenbezogener Daten im Chatbot-JSON

+ Kundendaten ausschließlich im WooCommerce-System - Sicherheit:

+ Zugriff auf JSON nur für den Chatbot (z. B. via Token)

+ Cronjob läuft serverseitig, nicht öffentlich - Hosting:

+ JSON-Dateien auf eigenem Server oder über gesicherte API-Schnittstelle

7. Weiterentwicklung

- Phase 1: Statische Produkt- und Policy-Daten (JSON-basiert)

- Phase 2: Dynamische Abfragen (z. B. Live-Bestandsabfrage aus WooCommerce API)

- Phase 3: Integration externer Systeme (CRM, ERP für Bestellstatus)

- Phase 4: Analytics & Machine Learning → Chatbot lernt von Nutzerfragen

Technische Infrastruktur

Zielbild (High-Level)

- Quelle (WooCommerce/WordPress) → Cron-Exporter (JSON + Schema-Validierung) → Objektspeicher/Cache → Chatbot-Service (LLM/RAG) → Widget auf Website

- Querschnitt: Monitoring, Security (WAF, TLS, Secrets), CI/CD, Backups, DSGVO

1) Hosting & Laufzeitumgebungen

- WordPress/WooCommerce (existiert bereits)

+ Webserver: Nginx (Reverse Proxy) und Apache + PHP-FPM, MariaDB/MySQL - Environments: Dev, Stage, Prod (separate DB + Media/Uploads)

- PHP-Erweiterungen: mbstring, intl, curl, json, gd/imagick

- Cron: systemd-cron + deaktiviertes WP-Cron (`DISABLE_WP_CRON`)

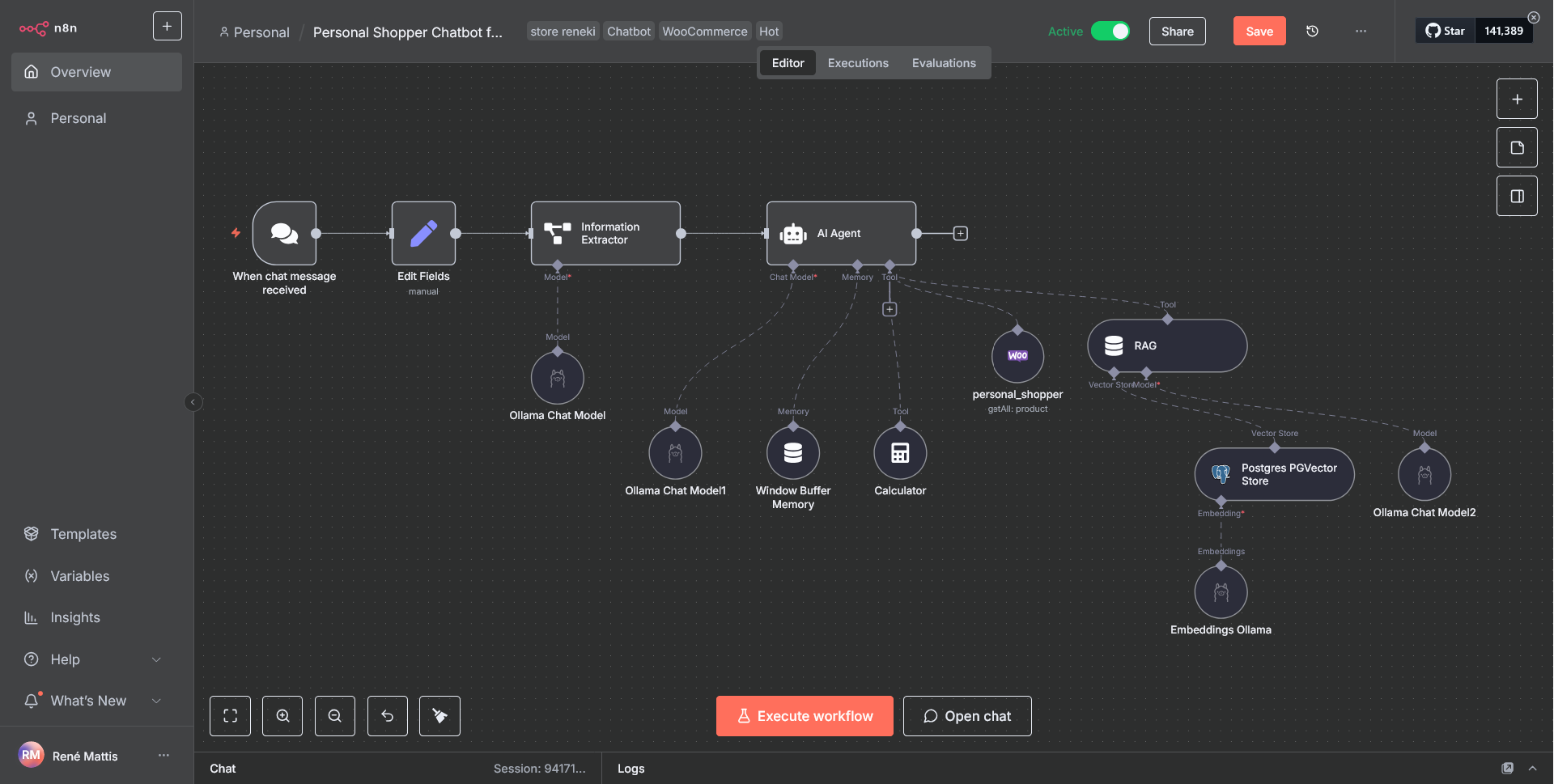

Chatbot

- Option A (SaaS/managed): z. B. Dialogflow/Intercom/Zendesk + eigener RAG-Endpoint

- Option B (Self-Hosted): Container (Docker/Kubernetes) mit:

+ Orchestrierung: Docker Compose (MVP) → Kubernetes (skalierend)

+ Runtime: Python/Node Service für Intent Handling, Retrieval (RAG) und Antwortlogik

+ LLM-Zugriff: API-basierte Modelle (z. B. OpenAI/Azure OpenAI/Ollama)

via Secret-Management

2) Datenpipeline (Export & Versorgung)

Exporter

- Stündlicher Cronjob: SQL/REST-Pull aus WooCommerce → Transform → JSON

gemäß Schema - Schema-Validierung vor Ablage (JSON Schema 2020-12)

- Versionierung (`metadata.version`) + Timestamp (`generated_at`)

- Speicherziel:

+ MVP: lokales, nicht-öffentliches Verzeichnis + Basic Auth/Token

+ Besser: S3-kompatibler Objektspeicher** (z. B. MinIO/S3) mit signierten URLs

+ Caching: Redis für Hot-Set (z. B. Top-Seller, häufige Versandregeln)

Konsum (Chatbot)

- Pull (stündlich) oder Event-getrieben (Webhook/Queue)

- Delta-Erkennung: ETag/If-Modified-Since, um unnötige Re-Indizierung zu vermeiden

3) Wissensbasis & Suche (RAG)

- Vektorindex (Produkttexte, FAQs, Policies):

+ MVP: SQLite/FAISS in Container

+ Skalierung: Qdrant, Weaviate oder PGVector (Postgres) - Dokument-Loader: JSON → Chunking (semantikgerechte Abschnitte)

- Re-Indizierung: nach erfolgreichem Export (Change-Only)

- Ranking: Hybrid (BM25 + Vektor) für präzisere Produkttreffer

- Produktempfehlungen: Regeln (z. B. Kategorie/Tags)

+ optional Embedding-Ähnlichkeit

4) Chatbot-Service (Backend)

- Endpoints:

+ `/query` (Userprompt + Kontext) → Retrieval → LLM → Antwort

+ `/healthz`, `/metrics` (Prometheus) - Business-Logik:

+ Policies (Retouren, Lieferzeiten) priorisiert gegenüber generativer Halluzination

+ Guardrails: Antwort-Vorlagen, Toolformer-Calls (z. B. Preis/Lager live) - Observability:

+ Structured Logs (JSON), Korrelation pro Session

+ Traces (OpenTelemetry): Retrieval-Zeit, LLM-Latenz, Tokenkosten - Rate-Limiting/Throttling pro IP/Session

5) Frontend-Integration (Website)

- Widget: JS-Snippet, Lazy-Load, CSP-kompatibel

- Design: Theme-kompatibel, Dark/Light

- Telemetrie: Consent-Aware (Opt-In), anonymisierte Metriken

- Fallback: Übergabe an Kontaktformular / E-Mail

6) Sicherheit & DSGVO

- Transport: TLS 1.2+, HSTS, nur HTTPS

- WAF/CDN: Stichwort DDoS, Bot-Mitigation, Rate-Limit

- Secrets: z.B. 1Password; niemals im Repo

- Least Privilege: getrennte IAM-Rollen für Export/Leser/Indexer

- PII-Minimierung: Der JSON-Export enthält keine personenbezogenen Daten

- Data Processing: ggf. AV-Verträge/DPA mit LLM-/Hosting-Anbietern

- Logging-Retention: 30–90 Tage, IP-Anonymisierung, Löschkonzepte

7) CI/CD & Qualität

- Repo-Setup: Monorepo (wp-plugin + chatbot) oder getrennt

- Pipelines** (GitHub Actions/GitLab CI):

+ Lint/Tests (PHPUnit/Jest/PyTest)

+ Schema-Tests: Export gegen Schema validieren

+ Build Docker Images (SBOM, Vulnerability-Scan)

+ Deploy: Dev → Stage → Prod (manuelle Gates) - Feature Flags: schrittweiser Rollout (z. B. 10% der User)

8) Monitoring & Alerts

- APM: New Relic/Datadog/Elastic APM (PHP + Node/Python)

- Logs: ELK/OpenSearch; strukturierte Felder (session_id, user_agent)

- Metrics: Prometheus + Grafana Dashboards (Latenz, Fehlerraten, Tokenverbrauch)

- Uptime: Pingdom/StatusCake

- Cron-Wächter: Alert bei Exportfehlern/Leeres JSON etc.

9) Backups & Datenrettung (DR)

- DB-Backups: täglich voll, 7–14 Tage Aufbewahrung; Point-in-Time (binlog) empfohlen

- Objektspeicher: Versioning + Lifecycle Policies

- Infra-IaC: Terraform/Ansible → reproduzierbare Wiederherstellung

(RTO/RPO definieren) - Runbooks: Wiederherstellungstest z.B. 1×/Quartal

10) Größenordnung & Kapazitäten (Richtwerte)

- WP-Server: 2–4 vCPU, 4–8 GB RAM (Trafficabhängig), PHP-OPcache aktiv

- Chatbot-API: 2 vCPU, 4 GB RAM (Autoscaling bis 4–8 vCPU)

- Vektor-DB: 2 vCPU, 4–8 GB RAM (10k–100k Chunks)

- Redis: 1–2 GB RAM (TTL-basierte Caches)

- S3-Storage: < 5 GB (JSON-Historie/Artefakte)

- Kosten grob/Monat (Cloud, EU-Region):

+ MVP: 200–600 € (Compute + Storage + Monitoring light)

+ Mit WAF/CDN/APM & höherer Last: 600–1.500 €

+ LLM-API: stark nutzungsabhängig (Budget-Limits + Alerts setzen)

11) Minimal Viable Architecture (MVP)

- WP auf bestehendem Hosting (Prod + Stage)

- Eigenes WP-Plugin: stündlicher Export + Schema-Validierung + Upload zu S3-Bucket (signierte URL)

- Kleiner Chatbot-Service (Docker Compose) + FAISS-Index

- Widget via JS-Snippet

- Monitoring: Uptime + Fehler-E-Mail + einfache Logs

- Backups: DB täglich, S3 Versioning aktiv

12) Skalierungs-Pfad

- Redis-Cache, Qdrant/PGVector, horizontale Skalierung via Kubernetes

- Live-Bestands-/Preis-Lookup über WooCommerce REST (Tool-Call)

- Fine-Grained Guardrails/Content-Moderation, Analytics-Pipeline (BigQuery/Snowflake optional)

5. Change Management und Schulungsplan

Dieser Plan stellt sicher, dass alle betroffenen Mitarbeiter früh eingebunden, gezielt geschult und motiviert werden – und der Chatbot nicht als „Blackbox“, sondern als Helfer im Arbeitsalltag verstanden wird.

1. Ziele

- Akzeptanz des Chatbots bei Mitarbeitern und Kunden sicherstellen

- Transparenz über Ziele, Nutzen und Veränderungen

- Schulung & Befähigung der Mitarbeiter, den Chatbot aktiv einzusetzen, zu überwachen und weiterzuentwickeln

- Kontinuierliche Verbesserung durch Feedbackschleifen

2. Stakeholder-Analyse

- Geschäftsführung → Strategische Entscheidung, Budget, Erfolgsmessung

- E-Commerce-Team → Datenpflege (Produkte, Versand, Retouren) → Basis für Chatbot

- Kundenservice → Nutzung als „First-Level-Support“, Eingreifen bei Eskalationen

- Marketing → Nutzung für Kampagnen, Custom Designs, Markenkommunikation

- IT/Dev → Betrieb, Wartung, Schnittstellenpflege

3. Change Management Maßnahmen

Kommunikation

- Kick-Off-Meeting mit allen betroffenen Abteilungen: Ziele, Nutzen, Projektplan

- Regelmäßige Updates im Intranet/Slack (Meilensteine, Tests, Erfolge)

- Feedback-Kanal für Mitarbeiter (z. B. Formular oder Slack-Channel „#chatbot-feedback“)

Einbindung

- Pilotphase: ausgewählte Mitarbeiter testen den Chatbot, bevor Kunden ihn sehen

- Co-Creation: Kundenservice und E-Commerce liefern reale FAQs und typische Fragen

- Champions: je Abteilung ein „Chatbot-Verantwortlicher“ als Multiplikator

Akzeptanzförderung

- Vorteile herausstellen:

+ Entlastung im Support (Routinefragen)

+ Schnellere Bearbeitung → bessere Kundenzufriedenheit

+ Weniger Fehler durch konsistente Antworten

4. Schulungsplan

Zielgruppenbezogene Schulungen

1. Kundenservice-Team

- Bedienung der Chatbot-Oberfläche (Monitoring, Eskalation an Support)

- Erkennen von Verbesserungspotenzial (falsche Antworten dokumentieren)

- Nutzung des Feedback-Dashboards

2. E-Commerce/Marketing-Team

- Pflege von Produktdaten → direkte Auswirkung auf Chatbot

- Aktualisierung von Versand-/Retouren-Informationen

- Integration von Promotions/Custom Design Angeboten in FAQs

3. IT/Entwicklung

- Überwachung Cronjobs, JSON-Schema-Validierung, Logs

- Fehlerbehebung bei Export/Chatbot-Verbindung

- Sicherheits- und Datenschutzrichtlinien

Formate

- Workshops (remote oder vor Ort): Einführung, Live-Demo, Q&A

- Hands-on Trainings: Testumgebung mit typischen Kundenszenarien

- Dokumentation:

+ Quick-Start-Guides (1–2 Seiten)

+ Wiki/Confluence-Seite mit Anleitungen & Troubleshooting - Video-Tutorials (5–10 Min.) für wiederkehrende Schulung

Zeitplan

- 2 Wochen vor Go-Live: Erste Schulungen für Key-User

- 1 Woche vor Go-Live: Breite Schulung aller betroffenen Mitarbeiter

- Go-Live-Woche: On-Demand-Support, tägliche Q&A-Sessions

- Nach 4 Wochen: Feedback-Workshop, Optimierung des Chatbots

5. Erfolgsmessung

- KPIs für Change Management & Schulung:

+ Teilnahmequote an Schulungen (>90 %)

+ Mitarbeiterzufriedenheit (Feedback-Bögen)

+ Anzahl gemeldeter Verbesserungen in den ersten 4 Wochen

+ Reduktion von Routineanfragen im Kundenservice nach 3 Monaten

6. Nachhaltigkeit

- Regelmäßige Refresher-Schulungen (halbjährlich, neue Features)

- Knowledge Sharing (Best Practices im Kundenservice-Team)

- Feedback-Loop: fortlaufende Verbesserung von FAQs, Policies, Antwortqualität

Interne Kommunikationsstrategie

1. Ziele der Kommunikation

- Transparenz: Alle Mitarbeiter verstehen, warum und wie der Chatbot eingeführt wird

- Akzeptanz: Vorbehalte (z. B. „nimmt uns die Arbeit weg?“) abbauen, Vorteile hervorheben

- Einbindung: Mitarbeiter werden aktiv beteiligt (Feedback, Pilotphasen)

- Motivation: Projekt als Innovationsschritt für LANAKILA präsentieren

2. Kernbotschaften

- Vision: „Der Chatbot entlastet uns von Routinefragen, damit wir mehr Zeit für individuelle Kundenwünsche haben.“

- Nutzen für Mitarbeiter: Weniger Standardanfragen, mehr Fokus auf Beratung & komplexe Fälle

- Nutzen für Kunden: Schnellere Antworten, 24/7 verfügbar, klare Infos zu Produkten & Retouren

- Sicherheit: Chatbot ist ein unterstützendes Werkzeug, kein Ersatz für Mitarbeiter

- Qualität: Antworten basieren auf denselben Daten, die ohnehin im Shop gepflegt werden

3. Zielgruppen & Kommunikationswege

- Geschäftsführung: Statusberichte, ROI & Kundenzufriedenheit → Management-Reportings, Steering Committee

- Kundenservice-Team: täglicher Nutzen, Rückmeldungen → Workshops, Feedback-Runden, Slack-Channel

- E-Commerce/Marketing: Pflege von Produkt- & Versandinfos → Intranet-Beiträge, Demos

- IT/Dev: Technische Details, Monitoring → Stand-Ups, Confluence-Wiki

- Alle Mitarbeiter: Überblick, Motivation → Newsletter, Townhall-Meetings, Video-Updates

4. Kommunikationskanäle & Formate

- Projekt-Kickoff (Townhall): Live-Event oder Video mit Vision, Zielen, Zeitplan

- Intranet/Slack-Kanal „#chatbot-projekt“: Regelmäßige Updates, FAQs, Feedback-Sammlung

- Projektnewsletter (z.B. 2-wöchentlich): Fortschritte, Erfolgsgeschichten, nächste Schritte

- Demos & Testphasen: Pilotzugang für ausgewählte Mitarbeiter + Live-Feedback

- Video-Tutorials (5–10 Min.): Kurze Schulungsvideos für Kundenservice & Marketing

- FAQ-Dokument: Beantwortet interne Fragen („Wer pflegt Daten?“, „Wie erkenne ich Fehler?“)

5. Feedback- & Beteiligungskultur

- Slack-/Teams-Channel: Direkter Kanal für Ideen & Probleme

- Feedback-Umfragen: Kurzbefragungen nach Schulungen & Pilotphasen

- Mitarbeiter-Champions: Multiplikatoren aus jeder Abteilung als Sprachrohr ins Projektteam

6. Erfolgsmessung

- Quantitativ:

+ Anzahl Beiträge/Feedback im Slack-Kanal

+ Newsletter-Öffnungsraten (Tracking)

+ Teilnahme an Schulungen - Qualitativ:

+ Mitarbeiter-Feedback zu Transparenz und Nutzen

+ Wahrnehmung des Projekts (z. B. in internen Umfragen)

Mögliche Widerstände & Gegenmaßnahmen

1. Jobangst („Der Chatbot ersetzt uns“)

Bedenken: Mitarbeitende im Kundenservice fürchten, dass durch Automatisierung Arbeitsplätze wegfallen.

Antwort/Strategie:

- Frühzeitig kommunizieren: Chatbot = Unterstützung, nicht Ersatz

- Klare Botschaft: Der Bot übernimmt Routinefragen (Versand, Retouren), Mitarbeiter kümmern sich um individuelle, komplexe Fälle

- Beispiele bringen: „Wie viel Zeit sparen wir bei Standardanfragen?“ → Fokus auf Qualitätsberatung

2. Skepsis gegenüber Zuverlässigkeit

Bedenken: „Der Bot gibt falsche Antworten und sorgt für unzufriedene Kunden.“

Antwort/Strategie:

- Pilotphase mit internem Test durch Service-Mitarbeiter

- Einrichtung eines Feedback-Buttons im Chatbot („War die Antwort hilfreich?“)

- Schnelles Korrekturverfahren: Wenn Fehler erkannt werden, Anpassung der JSON-Daten/FAQs innerhalb weniger Stunden

3. Technische Überforderung

Bedenken: Mitarbeiter (z. B. im Kundenservice) haben Angst, die Technik nicht zu verstehen oder Fehler nicht beheben zu können.

Antwort/Strategie:

- Einfache Tools & Dashboards statt komplexer Entwickler-Interfaces

- Schulungen mit praxisnahen Szenarien („Was mache ich, wenn der Bot nicht weiter weiß?“)

- Kurze „Quick-Guides“ und Video-Tutorials (5 Minuten statt Handbücher)

4. Verlust an direktem Kundenkontakt

Bedenken: „Wir verlieren die Nähe zum Kunden, wenn der Chatbot übernimmt.“

Antwort/Strategie:

- Betonung: Der Chatbot ist „Erstkontakt“, aber Service-Mitarbeiter bleiben entscheidend für Eskalationen, Reklamationen, Beratung

- Definierte „Eskalations-Workflows“: Der Bot übergibt komplexe Fälle nahtlos an den Menschen

- KPI-Kommunikation: Chatbot steigert Erreichbarkeit → mehr Kundeninteraktionen insgesamt

5. Daten- und Datenschutzsorgen

Bedenken: „Was passiert mit den Kundendaten? Werden wir überwacht?“

Antwort/Strategie:

- Transparente Information: Der JSON-Export enthält keine personenbezogenen Daten

- LLM/Chatbot verarbeitet nur Produkt- und Policy-Daten

- DSGVO-Compliance klar darstellen (Serverstandort, AV-Verträge)

- Monitoring erklärt: Nur zur Qualitätssicherung, nicht zur Mitarbeiterkontrolle

6. „Wir haben schon genug Tools“

Bedenken: Überlastung durch weitere Systeme und Prozesse.

Antwort/Strategie:

- Integration in bestehende Plattformen

(z. B. Slack für interne Meldungen, WooCommerce als Datenquelle) - Minimale zusätzliche Oberfläche, Chatbot läuft im Webshop

- Fokus auf Nutzerfreundlichkeit: Einfache Bedienung, kein Extra-Login nötig

Zusammenfassung der Maßnahmen

- Frühzeitige Kommunikation → Ziel, Nutzen, Grenzen klar machen

- Einbindung der Mitarbeiter → Feedback-Loop, Champions, Pilotphase

- Schulung & Support → Hands-on-Training, Quick-Guides, On-Demand-Hilfe

- Transparenz bei Datenschutz & Monitoring → Klarstellen, dass der Bot kundenorientiert ist, nicht kontrollorientiert

- Positive Narrative → Chatbot als „Kollege“, der Standardaufgaben übernimmt

6. Erfolgsmessung und Skalierung

1. KPIs für das Pilotprojekt

Nutzerinteraktion

- Anzahl der Chat-Sessions pro Tag/Woche (zeigt Akzeptanz der Kunden)

- Durchschnittliche Session-Dauer (zeigt, ob Bot genutzt wird, statt abgebrochen)

- Wiederkehrende Nutzer (Retention)

Antwortqualität

- Answer Resolution Rate (ARR): Anteil der Anfragen, die der Bot ohne menschliche Hilfe löst (Ziel: 60–70 % im Pilot)

- Escalation Rate: Anteil der Anfragen, die an den Kundenservice übergeben werden (Ziel: < 40 %)

- Customer Satisfaction (CSAT): Bewertung nach Chat („War die Antwort hilfreich?“)

Betrieb & Effizienz

- Antwortzeit: Bot < 2 Sekunden für Standardfragen

- Verfügbarkeit: Uptime > 99 %

- Support-Entlastung: Reduktion der Routineanfragen beim Kundenservice (Ziel: -20 % nach 3 Monaten)

Geschäftsrelevanz

- Conversion Rate aus Chatbot-Sessions (z. B. Produktklicks → Kauf)

- Umsatz aus Chatbot-Empfehlungen (Tracking über WooCommerce/ Matomo)

- Retouren-Quote nach Bot-Empfehlungen (zeigt Qualität der Beratung)

2. Prozess zur Evaluation des Pilotprojekts

Phase 1 – Vorbereitung

- Definition der KPIs (siehe oben)

- Einrichtung von Tracking & Monitoring (Matomo (Self-hosted), Chatbot-Logs, Support-CRM-Daten)

- Schulung interner Mitarbeiter zur Feedback-Sammlung

Phase 2 – Durchführung (3 Monate Pilot)

- Laufende Sammlung von Quantitativen Daten (KPIs)

- Qualitatives Feedback:

+ Kundensicht: Mini-Surveys nach Chat

+ Mitarbeitersicht: wöchentliche Feedback-Runden im Kundenservice

Phase 3 – Auswertung

- KPI-Review: Erreichung der Pilotziele

- Identifikation von „Fehler-Patterns“ (z. B. falsche Produktempfehlungen, Lücken in Retourenprozess)

- Gegenüberstellung „Ziel vs. Ist-Werte“

Phase 4 – Entscheidung

- Empfehlung: Rollout, Erweiterung oder Anpassung

- Erstellung eines „Pilot-Reportings“ für Management (KPIs, Learnings, Handlungsempfehlungen)

3. Fahrplan zur unternehmensweiten Skalierung von KI-Lösungen

Phase A – Stabilisierung & Optimierung

- Beheben von Pilot-Schwächen (z. B. Datenlücken, Intents nachtrainieren)

- Aufbau eines „AI Governance Frameworks“: Datenschutz, Ethik, Monitoring-Regeln

- Definieren eines „Center of Excellence (CoE)“ oder zumindest eines Kernteams „AI@Lanakila“

Phase B – Erweiterung Chatbot

- Integration zusätzlicher Datenquellen (CRM, ERP, Support-Tickets)

- Multichannel-Strategie: Chatbot auch auf WhatsApp, Instagram, Facebook einbinden

- Einführung von „Live-Agent-Handover“ (nahtlose Übergabe an Support)

Phase C – Weitere KI-Anwendungsfälle

- Marketing: Personalisierte Produktempfehlungen, KI-gestützte Kampagnen-Texte

- Operations: Nachfrageprognosen für Lagerbestände

- Support: Automatische Klassifizierung & Priorisierung von Supporttickets

Phase D – Skalierung & Industrialisierung

- Aufbau einer „unternehmensweiten KI-Infrastruktur“ (z. B. zentraler Vektorindex, API-Layer)

- Standardisierung von „Datenschnittstellen & Governance“

- Einführung eines „AI Lifecycle Management“ (Training, Deployment, Monitoring)

- Change Management 2.0: Schulungen für alle Abteilungen (KI-Kompetenzaufbau)

Zusammenfassung

- KPIs messen Akzeptanz, Antwortqualität, Effizienz und Business Impact

- Evaluation erfolgt in einem strukturierten 4-Phasen-Prozess (Vorbereitung → Durchführung → Auswertung → Entscheidung)

- Skalierung erfordert neben technischer Erweiterung vor allem Governance, Change Management und eine Roadmap für weitere KI-Anwendungsfälle

Kostenanalyse

1. Annahmen

Damit die Analyse greifbar ist, nehme ich folgende Vergleichsparameter an:

- Nutzungsszenario: ca. 50.000 Requests pro Monat

(Textgenerierung, Automatisierungen) - Durchschnittliche Eingabe/Ausgabe: ca. 1.500 Tokens pro Request

(entspricht ~1.000 Wörter Text) - Hosting-Optionen:

+ Self-hosted: Hetzner Dedicated GPU-Server

+ Cloud: GPT-4 (über OpenRouter), n8n Cloud

2. Self-hosted Lösung: n8n + Ollama bei Hetzner

Fixkosten (monatlich)

- GPU-Server bei Hetzner (z. B. NVIDIA A40 / A100 oder RTX 4090): ca. €400 – €900/Monat je nach Modell

- Speicher & Backup: ca. €50 – €100/Monat

- Sonstige Infrastruktur (Monitoring, Domains, SSL, Load Balancer): ca. €20 – €50/Monat

Gesamtkosten: ~ €500 – €1.050 / Monat (unabhängig von der Anzahl Requests)

Variable Kosten

- Keine API-Kosten pro Request (nur Strom/Hardware)

- Mehrlast erfordert ggf. zusätzliche Server

Vorteile

- Volle Kostenkontrolle, planbar

- Keine steigenden API-Kosten bei hohem Volumen

- DSGVO-konform, Daten bleiben im Haus/Rechenzentrum

3. Cloud-Lösung: GPT-4 über OpenRouter + n8n Cloud

Fixkosten (monatlich)

- n8n Cloud (Pro-Tarif): ab ca. €50 – €100/Monat

- Keine Hardwarekosten

Variable Kosten

- GPT-4 via OpenRouter (Stand 2025, ca.-Preise):

+ Eingabe: ~$0.01 – $0.03 pro 1k Tokens

+ Ausgabe: ~$0.03 – $0.06 pro 1k Tokens

Beispielrechnung:

50.000 Requests × 1.500 Tokens = 75 Mio. Tokens/Monat

- Eingabe: 37,5 Mio. × $0.03 = $1.125

- Ausgabe: 37,5 Mio. × $0.06 = $2.250

- Gesamt: ~$3.375/Monat (~ €3.200)

Gesamtkosten: ~ €3.200 – €3.500 / Monat (variabel mit Nutzungsvolumen)

Vorteile

- Kein Wartungsaufwand, sofort einsatzbereit

- Automatische Skalierung

- Zugriff auf neuste Modelle (GPT-4, Claude, Gemini etc.)

4. Fazit

Self-hosted mit Hetzner + Ollama lohnt sich besonders, wenn:

- Sehr hohes Anfragevolumen (> 100.000 Requests/Monat) zu erwarten ist

- Datenschutz höchste Priorität hat

- Das Unternehmen über technische Kapazitäten zur Betreuung der Infrastruktur verfügt

Cloud (GPT-4 + n8n Cloud) ist zu empfehlen, wenn:

- Höchste Modellqualität gewünscht ist

- Schnelle Time-to-Market ohne DevOps-Aufwand zählt

- Das Anfragevolumen eher „moderat“ bleibt (< 30.000 Requests/Monat)

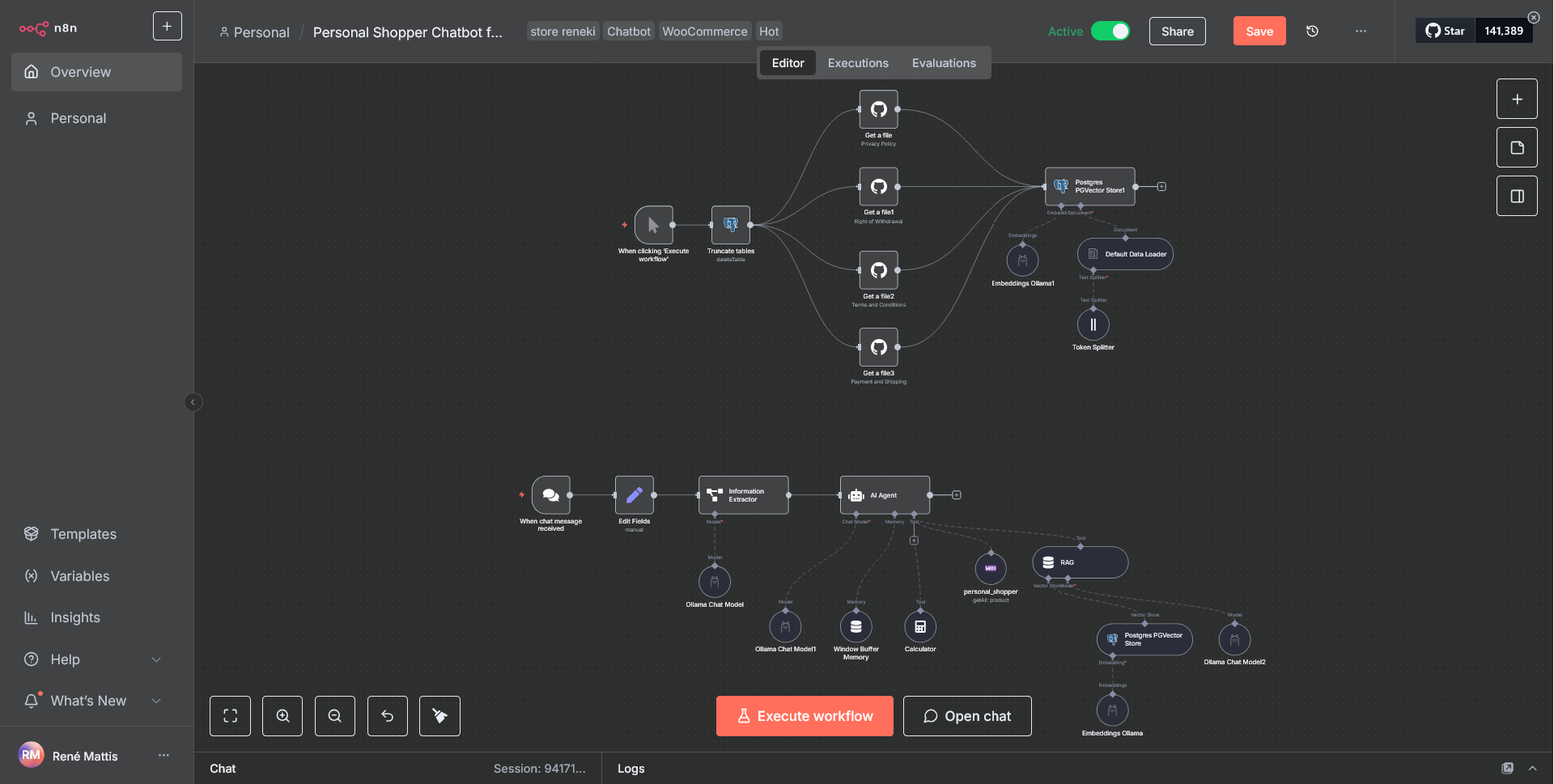

7. Implementierung EINER spezifischer KI-Anwendung

Self-hosted interne KI-Anwendung (Kunden ChatBot) mit n8n, Ollama via Docker

Zielstellung

Auf einem Test-Server soll ein WebShop (WordPress mit WooCommerce) installiert werden, der einen ChatBot auf der Seite integriert bekommt. Dieser Chatbot soll Fragen zu den eingepglegten Produkten (virtueller Verkaufsassistent), Lieferzeiten, Versandkosten etc. beantworten und dem Kunden ggf. Produktvorschläge liefern. Hierbei soll der ChatBot allerdings nicht auf die Datenbank direkt zugreifen sondern auf zwei via Cron stündlich aktualisierte JSON-Dateien (Produkte, FAQ).

Für den Workflow sollen die OpenSource Applikationen n8n und Ollama zum Einsatz kommen.

Das Betriebssystem des Test-Servers soll ein Linux-System mit Root-Zugriffsrechten sein, um alle notwendigen Komponenten, Dienste und Applikationen installieren und einrichten zu können.

Vorbereitungen

Installation und Konfiguration von WordPress mit WooCommerce Plugin (und Weitere), Docker, n8n und Ollama, Webserver (Apache2, Nginx), Datenbank-Server (mySQL), E-Mail Server und SSL-Zertifikate (via LetsEncrypt).

Test-Webshop: https://store.reneki.de

FAQ-Seite: https://store.reneki.de/faq/

ToDo’s:

- Entwicklung eines WordPress Plugins zur Generierung der benötigten JSON-Dateien für den ChatBot in n8n (nebst Cron zur stündlichen Ausführung)

- Entwicklung des Workflows in n8n

- Einbindung des ChatBots in WordPress (via Plugin / Webhook)

Ollama, n8n & Docker

Ollama

Ollama hat sich als eine der beliebtesten Lösungen für das lokale Ausführen von Large Language Models (LLMs) etabliert. Mit seiner einfachen CLI und dem unkomplizierten Setup ist es die erste Wahl für viele Entwickler geworden. Man sollte mind. 8 GB RAM für das Ausführen von 7B Modellen (LMM), 16 GB für 13B Modelle und 32 GB für 33B Modelle haben. Ollama unterstützt eine Vielzahl an Sprachmodellen, welche unter https://ollama.com/library zu finden sind.

n8n

n8n ist eine Open-Source-Workflow-Automatisierungsplattform, die visuell gesteuerte Automatisierung mit der Flexibilität von Code verbindet — zudem bietet sie native KI-Integration und lässt sich auf einem eigenen Server hosten oder komfortabel in der Cloud betreiben.

n8n ist eine Plattform für flexible KI-Workflow-Automatisierung, welche die Präzision von Code mit der Geschwindigkeit von Drag-and-Drop verbindet — ideal für technische Teams, die komplexe, mehrstufige KI-Agenten und App-Integrationen umsetzen möchten.

n8n erlaubt die Integration von Ollama. Ollama ist ein Tool, das es einfach macht, große Sprachmodelle (LLMs) lokal auf dem eigenen Computer zu installieren, auszuführen und zu verwalten.

Docker

Docker ist ein Werkzeug, mit dem man Software in Containern verpackt. Ein Container enthält alles, was ein Programm braucht (z. B. Bibliotheken, Konfigurationen). Dadurch läuft es überall gleich – egal ob auf deinem PC, Server oder in der Cloud.

Vorteile von Docker

- Gleiche Umgebung: „Bei mir geht’s, bei dir nicht“ gibt es nicht mehr

- Einfache Verteilung: Container sind wie fertige Pakete, schnell startklar

- Ressourcenschonend: Brauchen weniger Speicher und starten schneller als VMs

- Skalierbar: Man kann beliebig viele Container derselben App starten

- Flexibel: Läuft auf fast allen Plattformen

Kurz gesagt: Docker sorgt dafür, dass Software überall gleich, leicht und effizient läuft.

In unserem Pilotprojekt wird Docker also eingesetzt, um n8n und Ollama in unseren Server einzubinden.

Vor- und Nachteilen beim Einsatz von n8n mit Ollama (Self-hosted) gegenüber Cloud-Lösungen

1. Kontrolle & Unabhängigkeit

Vorteile (Self-hosted mit n8n + Ollama):

- Volle Datenhoheit: Alle Daten bleiben auf eigener Infrastruktur, kein Abfluss sensibler Informationen in Drittsysteme

- Unabhängigkeit von Anbietern: Keine Bindung an SLA, AGB oder Preismodelle von Cloud-Anbietern

- Customization: Vollständige Kontrolle über Modellwahl, Versionen, Feintuning und Integrationen

Nachteile:

- Administrationsaufwand: Einrichtung, Updates, Monitoring und Wartung müssen selbst übernommen werden

- Fehleranfälligkeit: Höhere Komplexität in der Infrastruktur, ggf. Probleme mit Skalierung, Load Balancing oder Backups

2. Kosten & Skalierbarkeit

Vorteile (Self-hosted):

- Planbare Kosten: Keine variablen Kosten pro API-Call wie bei Cloud-Anbietern

- Skalierbar nach Ressourcen: Nutzung der vorhandenen Hardware (z. B. GPU-Server), ohne steigende Cloud-Gebühren

Nachteile:

- Hohe Einstiegskosten: Anschaffung leistungsfähiger Hardware (GPUs, Storage, RAM)

- Begrenzte Skalierbarkeit: Wachstum ist durch eigene Infrastruktur limitiert, während Cloud-Lösungen elastisch skalieren

3. Performance & Latenz

Vorteile (Self-hosted):

- Geringe Latenz intern: Modelle laufen im eigenen Netz, keine Internet-Roundtrips nötig

- Feinjustierung möglich: Optimierung der Inferenzleistung durch Hardware- und Modellanpassungen

Nachteile:

- Abhängig von eigener Hardware: Performance hängt von eingesetzten GPUs/CPUs ab

- Cloud-Anbieter oft optimiert: Cloud-Modelle laufen auf hochoptimierter Infrastruktur mit GPU-Clustern

4. Sicherheit & Compliance

Vorteile (Self-hosted):

- DSGVO- und Compliance-Vorteil: Besonders wichtig für regulierte Branchen, da keine Daten externe Rechenzentren verlassen

- Volle Transparenz: Kontrolle über Logs, Speicherorte und Zugriffsrechte

Nachteile:

- Eigenverantwortung: Man trägt die gesamte Verantwortung für Security-Patches, Verschlüsselung, Zugriffsmanagement

- Angriffsfläche: Ungepatchte Systeme oder Fehlkonfigurationen können zu Sicherheitslücken führen

5. Flexibilität & Innovationsgeschwindigkeit

Vorteile (Self-hosted):

- Modellfreiheit: Ollama ermöglicht lokale Nutzung verschiedener Open-Source-Modelle (z. B. LLaMA, Mistral, DeepSeek)

- Experimentierfreudigkeit: Einfaches Testen neuer Modelle ohne Cloud-Limits oder API-Anpassungen

Nachteile:

- Cloud-first Features fehlen: Anbieter wie OpenAI oder Anthropic bieten oft die neuesten Modelle und Features schneller

- Langsame Updates: Self-hosted Umgebungen müssen aktiv aktualisiert werden, während Cloud-APIs automatisch neue Modelle einspielen

Fazit

n8n + Ollama (Self-hosted) ist ideal, wenn Datenhoheit, Datenschutz, Kostenkontrolle und Flexibilität bei der Modellwahl im Vordergrund stehen.

Cloud-Lösungen sind sinnvoll, wenn Skalierbarkeit, geringere Wartung, höhere Performance und Zugang zu neuesten Modellen wichtiger sind.