Was ist Apertus?

Ein vollständig offenes, mehrsprachiges LLM der EPFL, ETH Zürich und des CSCS (Swiss National Supercomputing Centre). Veröffentlichung am 2. September 2025; Ziel: Transparenz, Compliance und digitale Souveränität. Verfügbar über Hugging Face und Partnerplattformen.

Varianten & Lizenz

Zwei Größen: 8B und 70B Parameter. Lizenz Apache-2.0; zusätzlich gilt eine Acceptable Use Policy (AUP).

Sprachen

Training auf > 1.000 Sprachen (40 % nicht-englisch), inkl. Schweizerdeutsch und Rätoromanisch. Die Model-Cards nennen 1.811 „nativ unterstützte Sprachen“ – je nach Quelle also „> 1.000“ bis „~1.800+“.

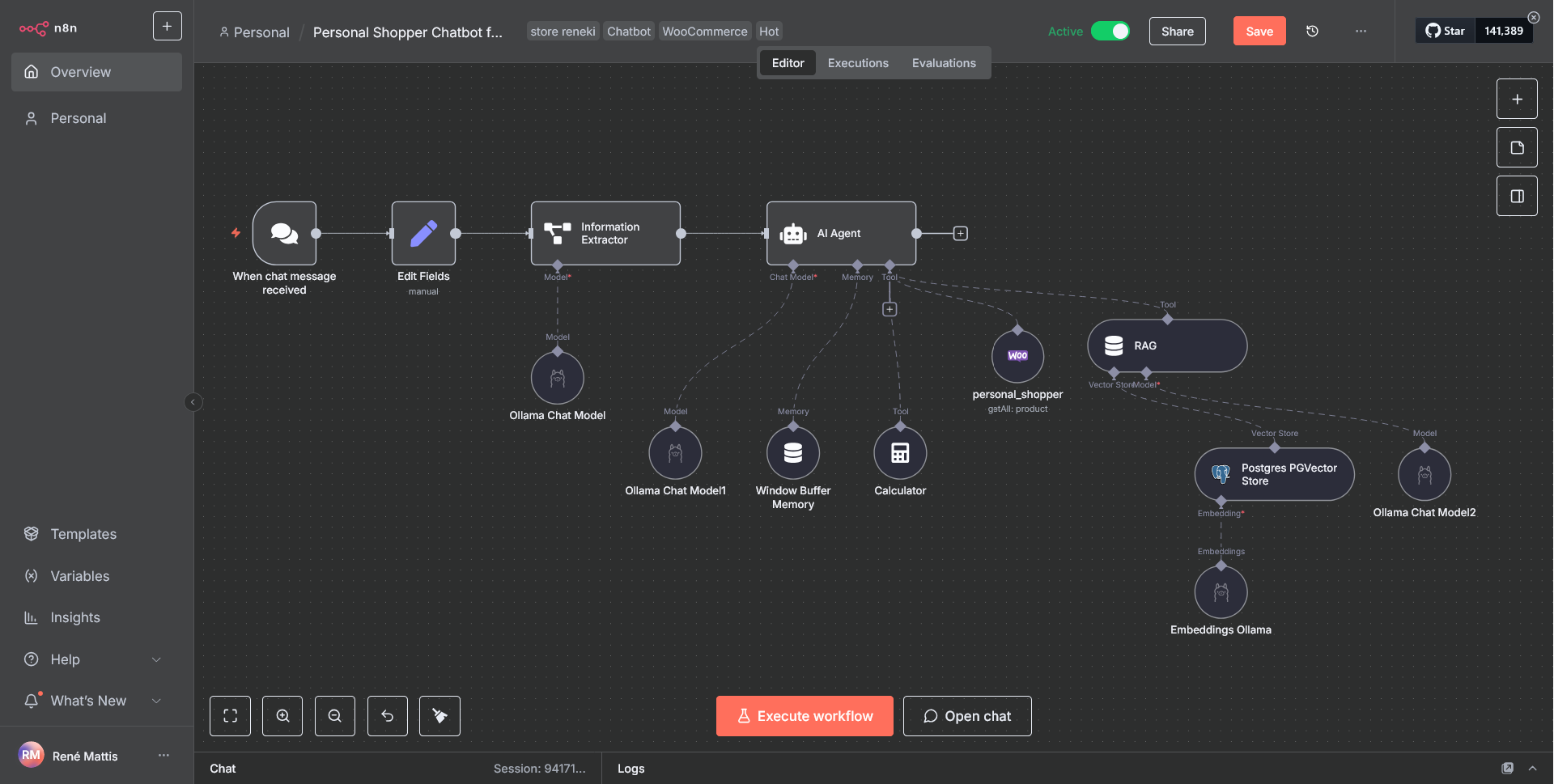

Architektur & Training

Decoder-only-Transformer, 15 Billionen Tokens Vortraining (Web/Code/Mathe, gestuftes Curriculum). xIELU-Aktivierung, AdEMAMix-Optimizer; Post-Training via SFT und QRPO. Kontextlänge: bis 65.536 Tokens; Tool-Use/Agent-Hooks vorgesehen.

Recheninfrastruktur

Training u. a. auf 4096 × NVIDIA GH200 (bf16) auf dem CSCS-Supercomputer Alps. Die Finanzierung nennt > 10 Mio. GPU-Stunden.

Benchmarks (Auszug, Pretraining-Phase)

Apertus-70B liegt beim gemittelten Wert ~67,5 % (ARC/HellaSwag/WinoGrande/XNLI/XCOPA/PIQA), in Reichweite offener Top-Modelle wie Llama 3.1-70B (~67,3 %). Vollständige Tabellen siehe Model-Card/Tech-Report.

Transparenz & Compliance

Offene Gewichte, Daten-Pipelines, Trainingsrezepte & Zwischen-Checkpoints – vollständig dokumentiert.

Training auf öffentlich zugänglichen Daten mit Respektierung von Robots/Opt-out; Ausrichtung an EU-AI-Act-Transparenz.

Verfügbarkeit & Einsatz

Hugging Face (Apertus-8B/70B & Instruct-Varianten). Läuft out-of-the-box mit Transformers ≥ v4.56, vLLM, SGLang sowie MLX (Apple/on-device).

Swisscom Swiss AI-Plattform (Business-Zugriff in CH) und Public AI Inference Utility (globaler Zugriff).

Wofür besonders geeignet?

Öffentlicher Sektor & regulierte Branchen: Hohe Nachvollziehbarkeit/Compliance, EU-konform.

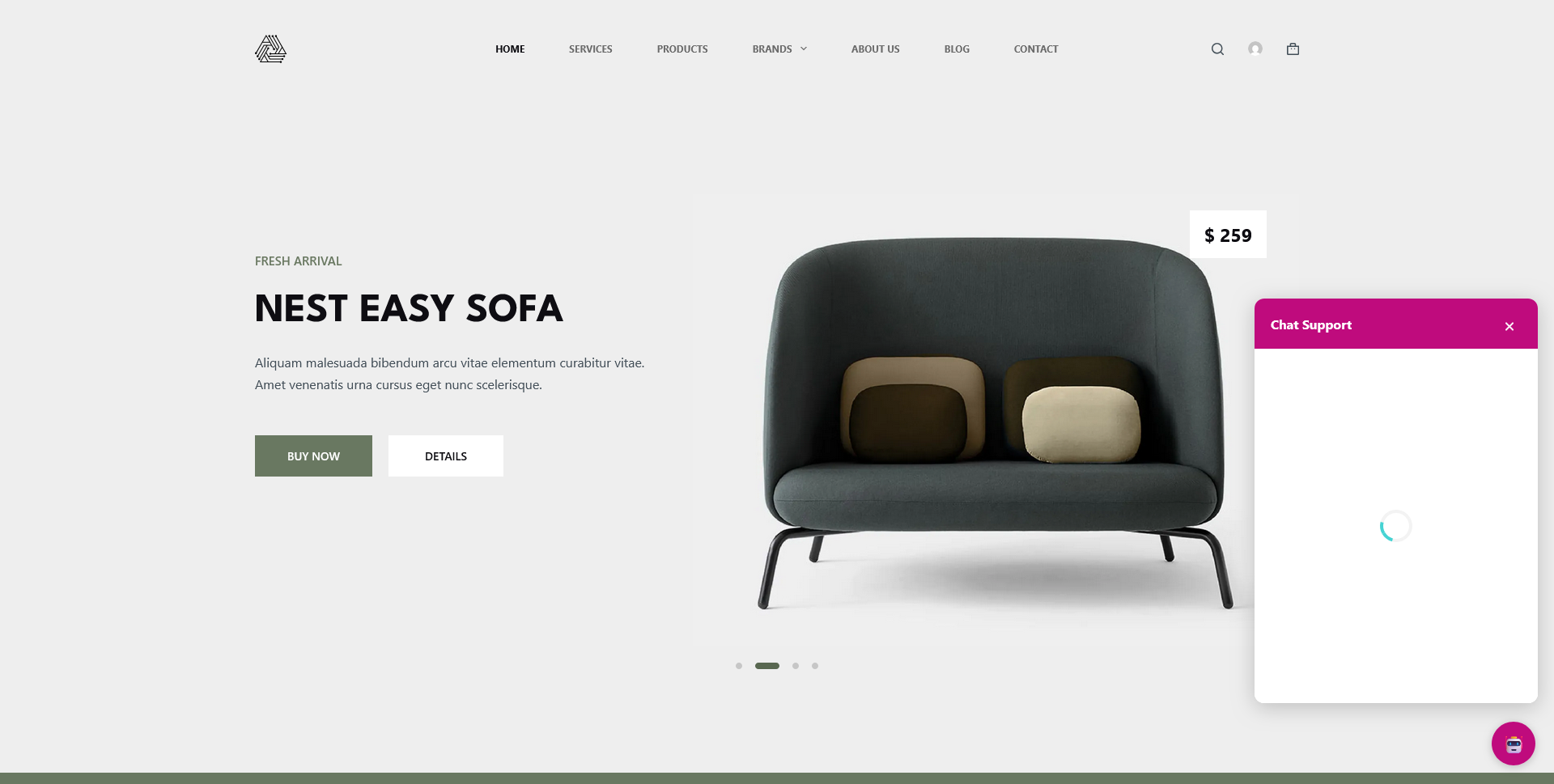

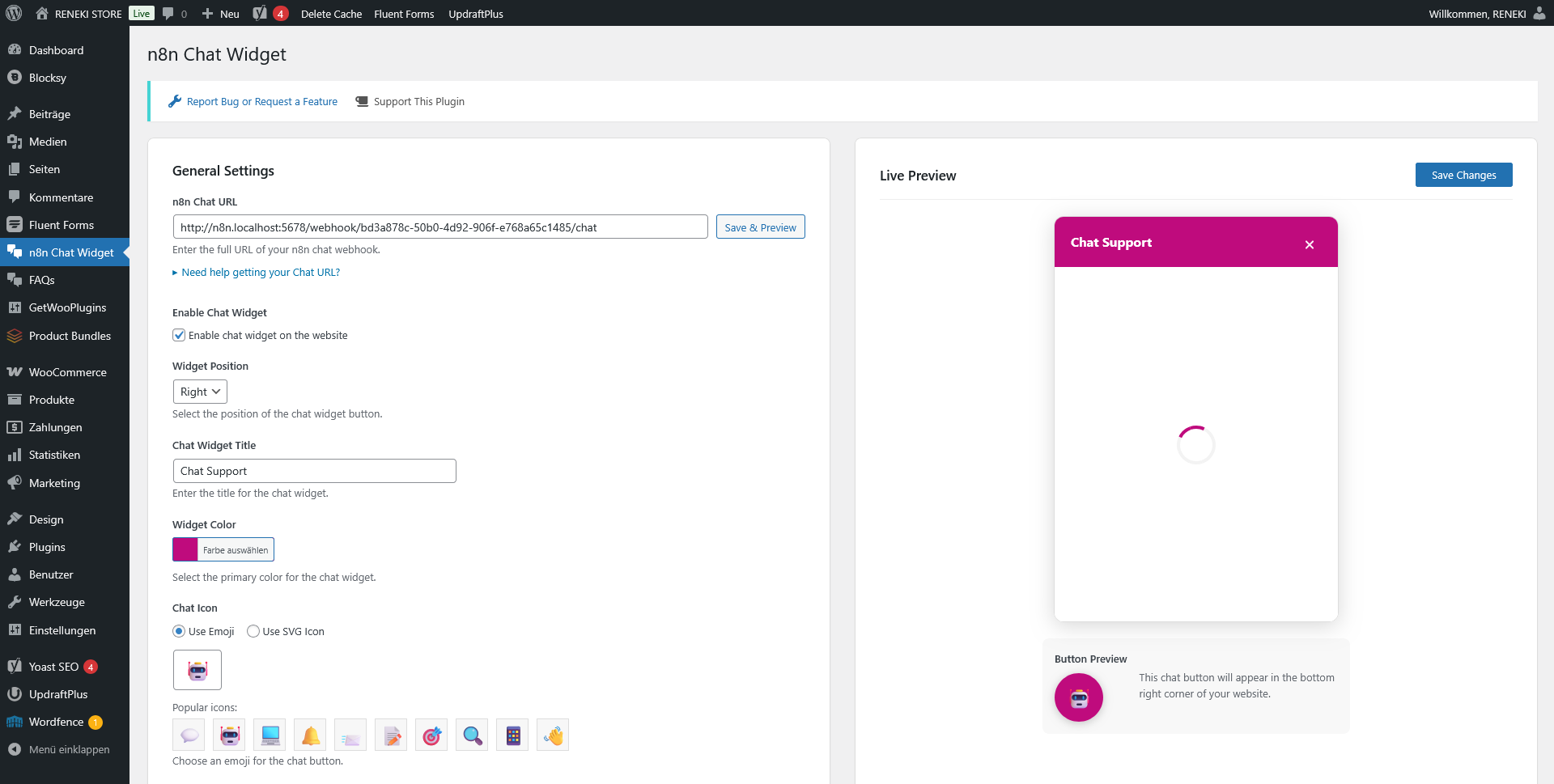

Mehrsprachige Anwendungen: Chatbots, Übersetzung, Bildung/Onboarding – v. a. für unterrepräsentierte Sprachen.

Forschung & Open-Source-Ökosystem: Reproduktion, Fine-tuning, Ableitungen/Quantisierung (8B für Edge/On-Prem).

Grenzen / Hinweise

Leistungsfähig, aber (noch) nicht auf Niveau der stärksten proprietären Modelle; die Projektziele sind Vertrauen & Souveränität, nicht Bench-Siege. Nutzung erfordert kritische Prüfung der Ausgaben (Bias/Halluzinationen).

Weiter Informationen unter:

https://ethz.ch/content/dam/ethz/main/news/eth-news/2025/09/250902-llm/MM_Apertus_LLM_de.pdf