AI TOOLS

Sprachmodelle & Tools

ChatGPT

ChatGPT (OpenAI) – Generalistischer Assistent (seit Aug./Sep. 2025 mit GPT-5) mit starkem Reasoning; unterstützt auch Realtime-Voice/speech-in, speech-out. Einsatz: Ideation & Schreiben, komplexe Wissensarbeit, Voice-Bots & Assistenten mit Live-Audio.

Perplexity

Perplexity – „Answer Engine“ mit Live-Websuche und Zitaten; Antworten sind quellenbasiert statt Linklisten. Einsatz: Faktenrecherche, aktuelle Nachrichten/Trends, schnelle Literature-Scans.

Claude.ai

Claude.ai (Anthropic) – für Entwickler, große Kontextfenster (bis 500K Enterprise); „Artifacts“ als Live-Arbeitsfläche für Code/Dokumente. Einsatz: Arbeiten mit langen Dokus/Codebasen, Teams & Enterprise-Governance.

DeepSeek

DeepSeek (R1) – Open-Source Reasoning-Modelle (MIT-Lizenz) mit distillierten kleineren Varianten; stark in Mathe/Code/Schlussfolgern. Einsatz: Forschung & Engineering, kosteneffiziente Self-Hosting-/On-Prem-Use-Cases.

Notebook LM

NotebookLM (Google) – KI-„Notizbuch“, das eigene Quellen (PDF, Docs, Websites, YouTube, Audio) zusammenfasst, verknüpft und als Audio Overviews erklärt. Einsatz: Onboarding-Reader, Dossier-Erstellung, Lernskripte aus internem Material, Podcasts erstellen.

Google Gemini

Google Gemini – Multimodaler Assistent (Gemini 2.5) + Workspace-Integration; Features wie Deep Research und große Kontextfenster in AI-Pro/Ultra. Einsatz: Arbeiten in Docs/Sheets/Meet, Recherchen mit Webbezug, Automationen/Flows.

Mistral

Mistral AI – Schlanke, schnelle Modelle (Mistral Large, Codestral für Code); verfügbar in Clouds/Vertex. Einsatz: Kosten-/Latenz-sensitive Deployments, Coding-Assistenz, europäische Daten-/Lizenzanforderungen.

Grok

Grok (xAI) – Assistent mit Fokus auf Echtzeitdaten (Web & X) und neuen Reasoning-Modellen (Grok 3 „Think“). Einsatz: News-/Trend-Analysen, Social-Kontext, experimentelles Reasoning.

Meta AI

Meta.ai – Persönlicher Assistent (Llama-basiert) in WhatsApp/Instagram/Facebook sowie als Standalone-App; legt Wert auf Personalisierung & Kontext. Einsatz: Alltagsassistenz in Social-/Messaging-Workflows, Voice-Interaktionen, leichte Content-Ideen.

Weitere Sprachmodelle

Neben den hier genannten Sprachmodellen (LMMs) gibt es eine Reihe weiterer. Unter folgendem Link könnt ihr euch auf edenai.co umfassend informieren.

Meta-Plattformen & Benchmark

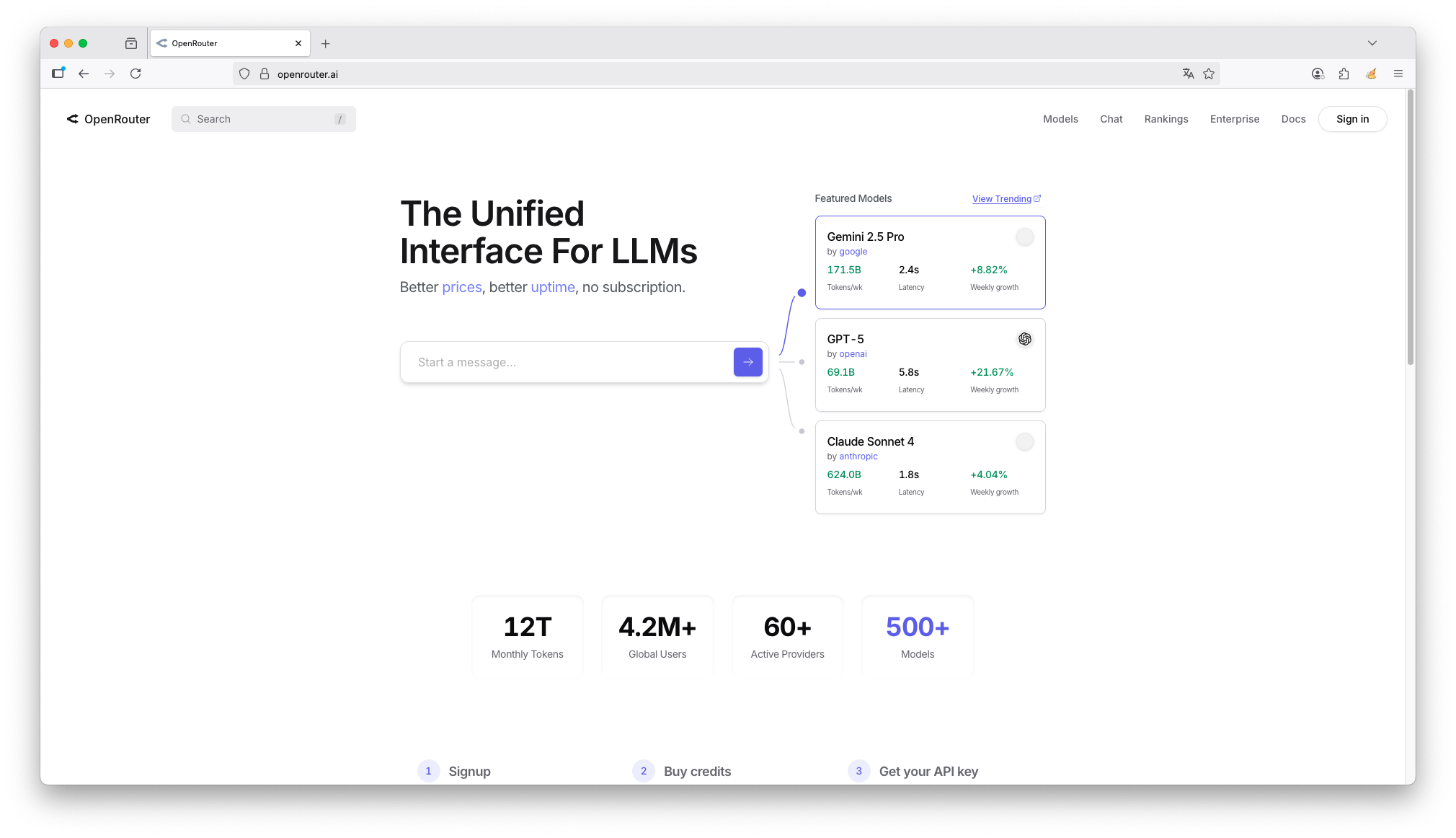

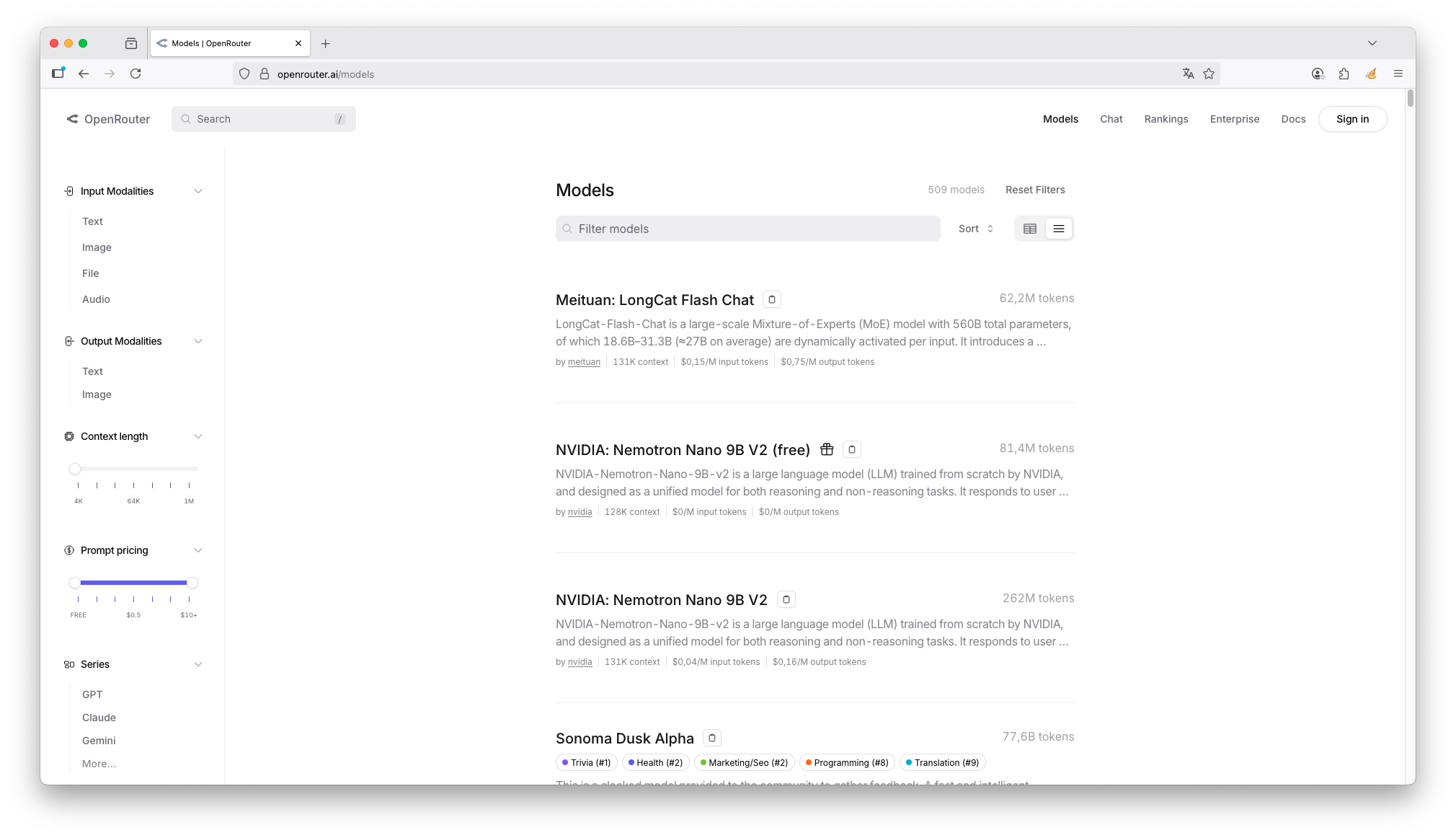

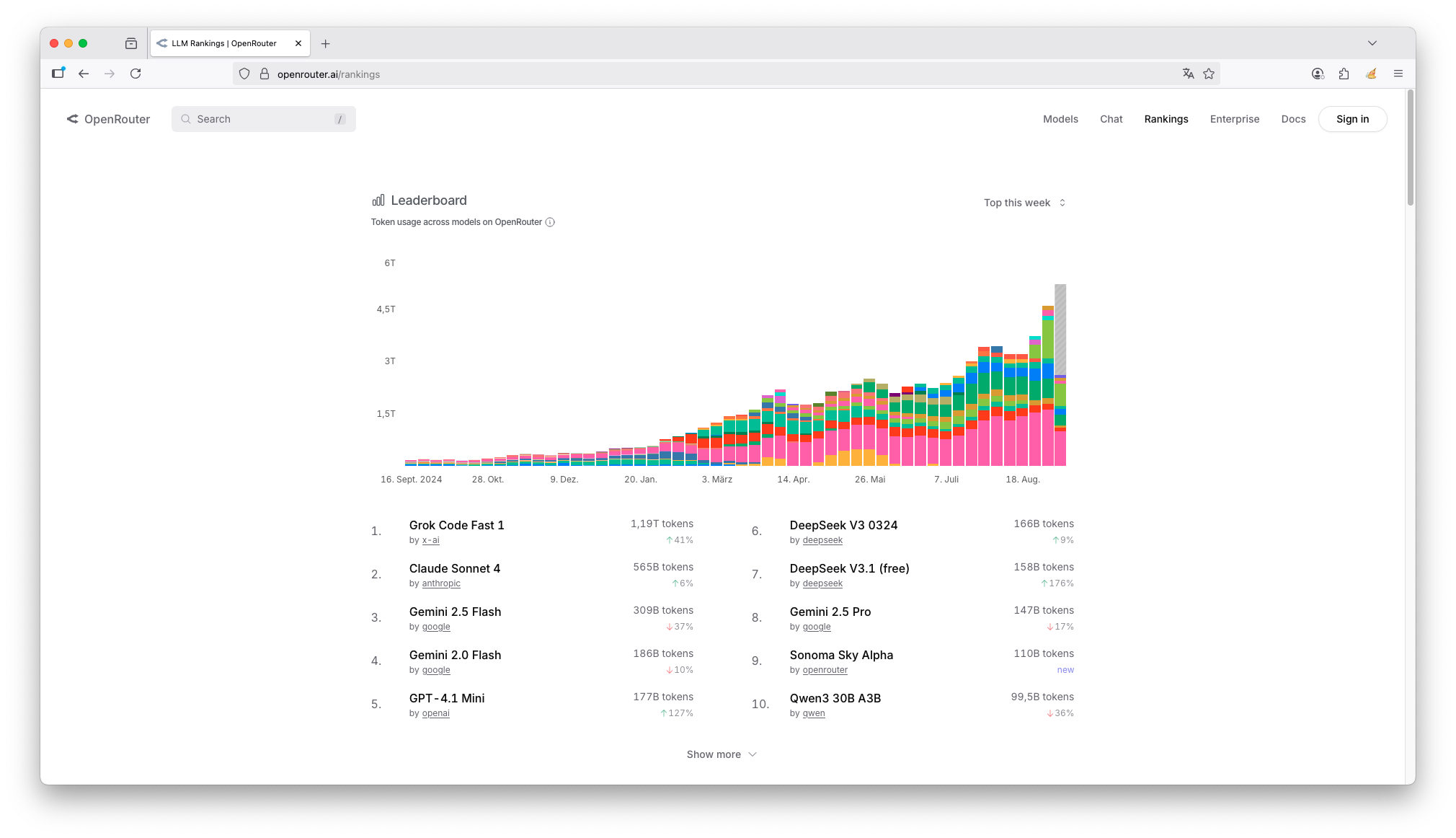

OpenRouter

https://openrouter.ai/

Was ist OpenRouter?

OpenRouter ist eine Meta-Plattform bzw. ein Aggregator für verschiedene KI-Sprachmodelle (wie ChatGPT, Claude, Gemini und viele andere). Statt sich bei jedem einzelnen Anbieter registrieren zu müssen, können Entwickler und Nutzer über die einheitliche Programmierschnittstelle (API) von OpenRouter auf eine große Auswahl der besten Sprachmodelle zugreifen.

Man kann es sich wie einen Vergleichsportal oder einen „Router“ für KI-Modelle vorstellen: Sie geben eine Anfrage ein, und OpenRouter leitet sie an das von Ihnen gewählte Modell (oder das beste/preiswerteste Modell) weiter und bringt Ihnen die Antwort zurück.

Wie funktioniert OpenRouter?

Einheitliche Schnittstelle (API): Entwickler integrieren nur die API von OpenRouter in ihre Anwendungen, Software oder Websites.

Modellauswahl: Der Nutzer (oder der Entwickler) kann entscheiden, welches Modell für eine bestimmte Anfrage verwendet werden soll. OpenRouter listet Dutzende von Modellen auf, inklusive Preisen und Leistungsdaten.

Weiterleitung: OpenRouter nimmt die Anfrage entgegen, leitet sie an den entsprechenden Anbieter (z.B. Anthropic für Claude, Google für Gemini) weiter.

Rückgabe: Die Antwort des Modells wird über OpenRouter wieder an den Nutzer zurückgegeben.

Die wichtigsten Funktionen und Vorteile

Zugang zu vielen Modellen an einem Ort: Das ist der größte Vorteil. Sie müssen keine einzelnen API-Schlüssel für OpenAI, Anthropic, Cohere, Mistral etc. verwalten. Ein Schlüssel für OpenRouter reicht aus.

Modellvergleich und -erkundung: Die Website von OpenRouter fungiert als Showcase. Sie können die Leistung verschiedener Modelle anhand von Bewertungen der Community vergleichen und testen, welches Modell für Ihren Use-Case am besten geeignet ist.

Kostenoptimierung: OpenRouter zeigt transparent die Preise pro Anfrage (Input/Output Token) für jedes Modell an. So können Sie das preiswerteste Modell wählen, das dennoch Ihre Qualitätsanforderungen erfüllt.

Standardisierte Abrechnung: Sie erhalten eine einzige Rechnung von OpenRouter für die Nutzung aller Modelle, anstatt mehrere Abrechnungen von verschiedenen Anbietern.

Benutzerauthentifizierung (OAuth): Für App-Entwickler ist dies ein Schlüsselmerkmal. OpenRouter kann das Login für Ihre App übernehmen. Nutzer melden sich mit ihrem OpenRouter-Account an und bezahlen direkt für ihre eigene KI-Nutzung, ohne dass der Entwickler die API-Kosten vorstrecken muss.

Privacy-First: OpenRouter betont, dass es standardmäßig keine Daten speichert, die durch API-Anfragen an ihn gesendet werden. Datenschutz ist ein zentrales Verkaufsargument.

Für wen ist OpenRouter gedacht?

Entwickler und Startups: Die primäre Zielgruppe. Sie sparen Zeit bei der Integration verschiedener Modelle und können ihre App schnell mit der besten/preiswertesten KI ausstatten.

Forscher und Enthusiasten: Ideal, um verschiedene Modelle miteinander zu vergleichen und zu experimentieren, ohne sich überall anmelden zu müssen.

Unternehmen: Können über eine einzige Schnittstelle flexibel auf verschiedene Modelle zugreifen und so Abhängigkeiten von einzelnen Anbietern vermeiden (Multi-Cloud-Strategie für KI).

Ein einfaches Beispiel

Stell die vor, du entwickelst eine Chat-App.

Ohne OpenRouter: Du musst dich für OpenAI, Anthropic und Mistral AI registrieren, drei separate API-Schlüssel verwalten, drei verschiedene Abrechnungen bezahlen und Code für drei verschiedene APIs schreiben.

Mit OpenRouter: Du registrierst dich nur bei OpenRouter, integrierst eine einzige API und kannst dann in deiner App dem Nutzer die Wahl lassen: „Möchtest du mit GPT-4, Claude 3 oder Mixtral chatten?“ Die Abrechnung läuft über OpenRouter.

Zusammenfassung

OpenRouter ist nicht der Betreiber der KI-Modelle (sie hosten die Modelle nicht selbst), sondern ein Vermittler und Router. Es vereinfacht den Zugang zur Welt der KI-Modelle erheblich, standardisiert die Abrechnung und gibt Entwicklern die Freiheit, das beste Tool für ihren Job auszuwählen, ohne vendor lock-in.

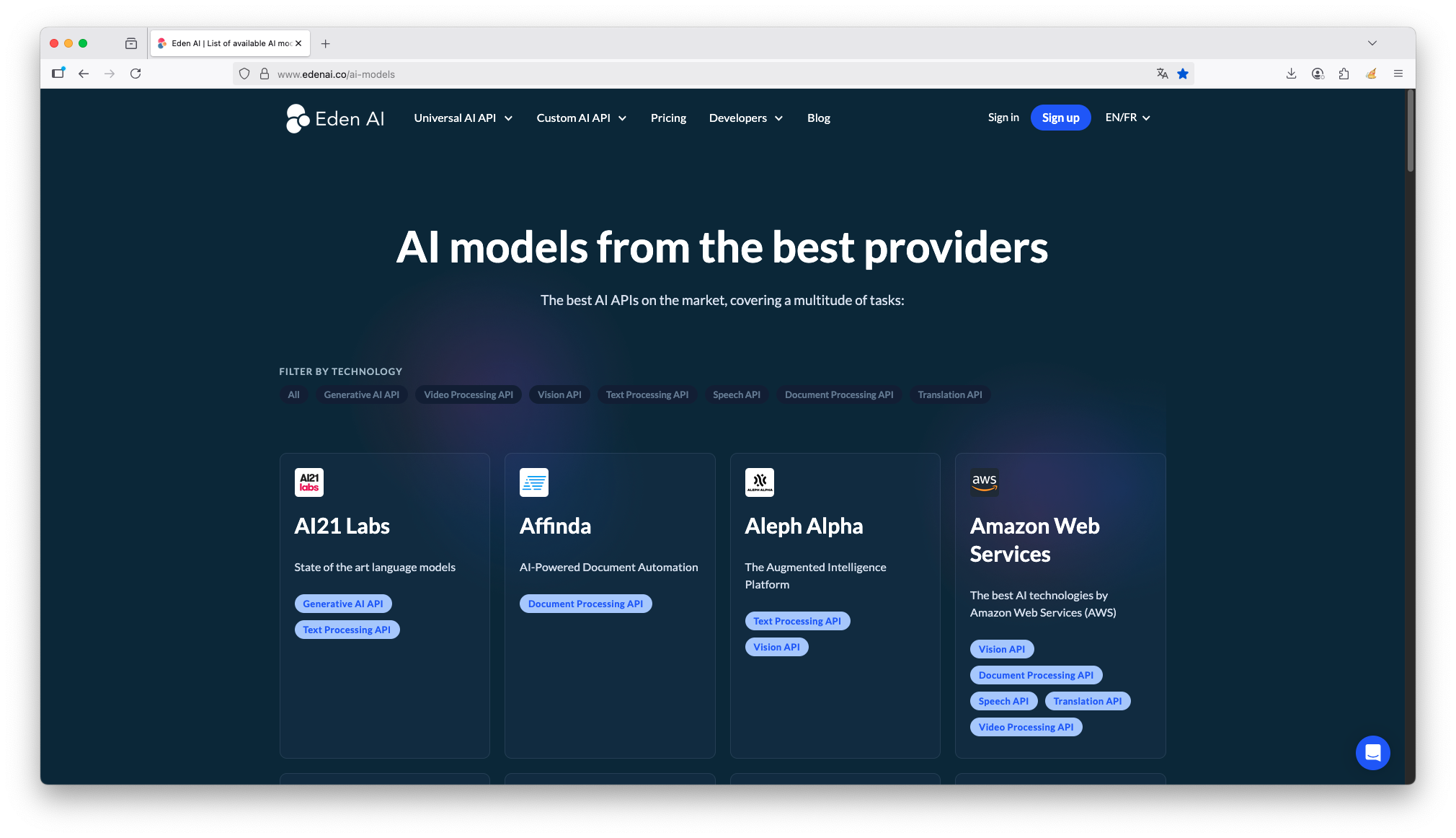

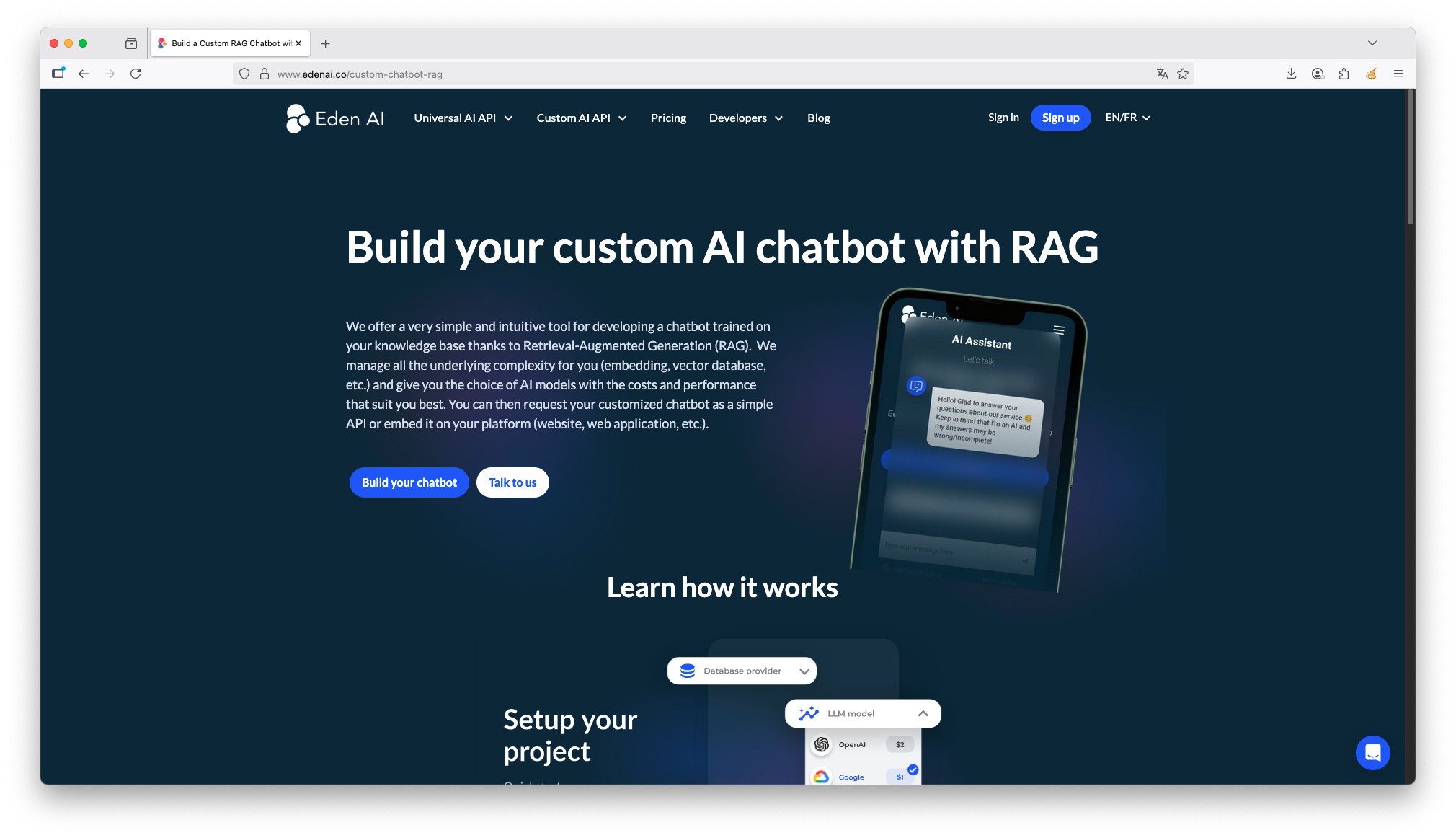

Eden AI

https://www.edenai.co/

Was ist Eden AI?

Eden AI ist eine Plattform, die sich als „All-in-One“-API für KI-Modelle verschiedener Anbieter versteht. Im Grunde genommen vereinfacht Eden AI den Zugang zu künstlicher Intelligenz für Entwickler und Unternehmen erheblich.

Das Kernkonzept: Eine API für (fast) alle KI-Dienste

Stell dir vor, du möchtest in deiner Anwendung/ App eine Texterkennung (OCR) integrieren. Dafür gibt es Dutzende Anbieter wie Google Cloud Vision, Amazon Textract, Microsoft Azure OCR, etc. Jeder hat seine eigenen Stärken, Schwächen und Preise.

Das klassische Problem:

Du musst dich für einen Anbieter entscheiden.

Du musst die spezifische API dieses Anbieters lernen und integrieren.

Wenn der Anbieter teurer wird oder schlechtere Ergebnisse liefert, ist ein Wechsel aufwendig.

Die Lösung von Eden AI:

Eden AI bietet eine einheitliche API für über eine Dutzend KI-Kategorien (wie OCR, Sprachgeneration, Übersetzung, Bildanalyse, etc.). Hinter dieser einen API kannst du dann ganz einfach zwischen verschiedenen Anbietern wechseln oder sogar mehrere Anbieter gleichzeitig nutzen (sog. „Fallback“-Mechanismus).

Die wichtigsten Vorteile im Überblick

Vereinfachte Integration: Du musst nur eine API integrieren, anstatt für jeden KI-Dienst eine separate.

Anbieter-Agnostizismus & Flexibilität: Du bist nicht an einen einzigen Anbieter gebunden. Du kannst die Ergebnisse verschiedener Anbieter (z.B. Google, OpenAI, Microsoft) über die gleiche Schnittstelle vergleichen und den besten für deinen Use Case auswählen.

Kosteneffizienz & Leistung: Du kannst einen Fallback-Modus einrichten. Beispiel: Zuerst fragt Eden AI den günstigsten Anbieter an. Wenn dessen Antwort zu langsam ist oder ein schlechtes Ergebnis liefert, wird automatisch der nächstbeste Anbieter angefragt. So optimierst du Kosten und Leistung.

Breites Technologie-Spektrum: Eden AI bündelt Zugang zu einer enormen Vielzahl von KI-Technologien:

Text: Übersetzung, Zusammenfassung, Stimmungsanalyse, Sprachgeneration (LLMs wie GPT-4), Erkennung sensibler Daten

Bild: Objekterkennung, Gesichtserkennung, Bildgeneration (z.B. mit Stable Diffusion), Explicit Content Detection

Audio: Spracherkennung (Speech-to-Text), Text-to-Speech

Video: Inhaltsanalyse

Dokumente: OCR (Texterkennung in gescannten Dokumenten und PDFs)

Transparente Preise: Du zahlst die Preise der ursprünglichen Anbieter plus einen kleinen Aufschlag von Eden AI. Es gibt keine versteckten Kosten.

Ein einfaches Anwendungsbeispiel

Ein Entwickler möchte eine App bauen, die Handschriften auf Fotos entziffert.

Ohne Eden AI: Er müsste sich für einen Anbieter (z.B. Google Vision) entscheiden, ein Konto dort erstellen, die SDKs integrieren und den Code spezifisch für Google schreiben.

Mit Eden AI: Er integriert die Eden AI API. In seinem Code sendet er einfach das Bild an

https://api.edenai.run/v2/ocr/ocrund erhält ein standardisiertes JSON-Resultat zurück. In seinem Eden AI Dashboard kann er dann testen, ob Google, Amazon oder vielleicht ein anderer Anbieter die beste Erkennungsrate für Handschrift hat, und diesen dann als Standard festlegen – ohne eine Zeile Code ändern zu müssen.

Für wen ist Eden AI gedacht?

Entwickler und Startups, die nicht die Zeit haben, jede KI-API einzeln zu evaluieren und zu integrieren.

Unternehmen, die Wert auf Redundanz und Flexibilität legen und nicht von einem einzelnen KI-Anbieter abhängig sein wollen.

Jeder, der mit mehreren KI-Technologien experimentieren und die besten Ergebnisse für seinen spezifischen Anwendungsfall finden möchte.

Zusammenfassung

Eden AI ist wie ein universeller Adapter oder ein Meta-Vermittler für Cloud-KI-Dienste. Es entfernt die Komplexität der Multi-Anbieter-Integration und gibt Entwicklern die Kontrolle und Flexibilität zurück, die besten KI-Tools für ihre Projekte zu nutzen.

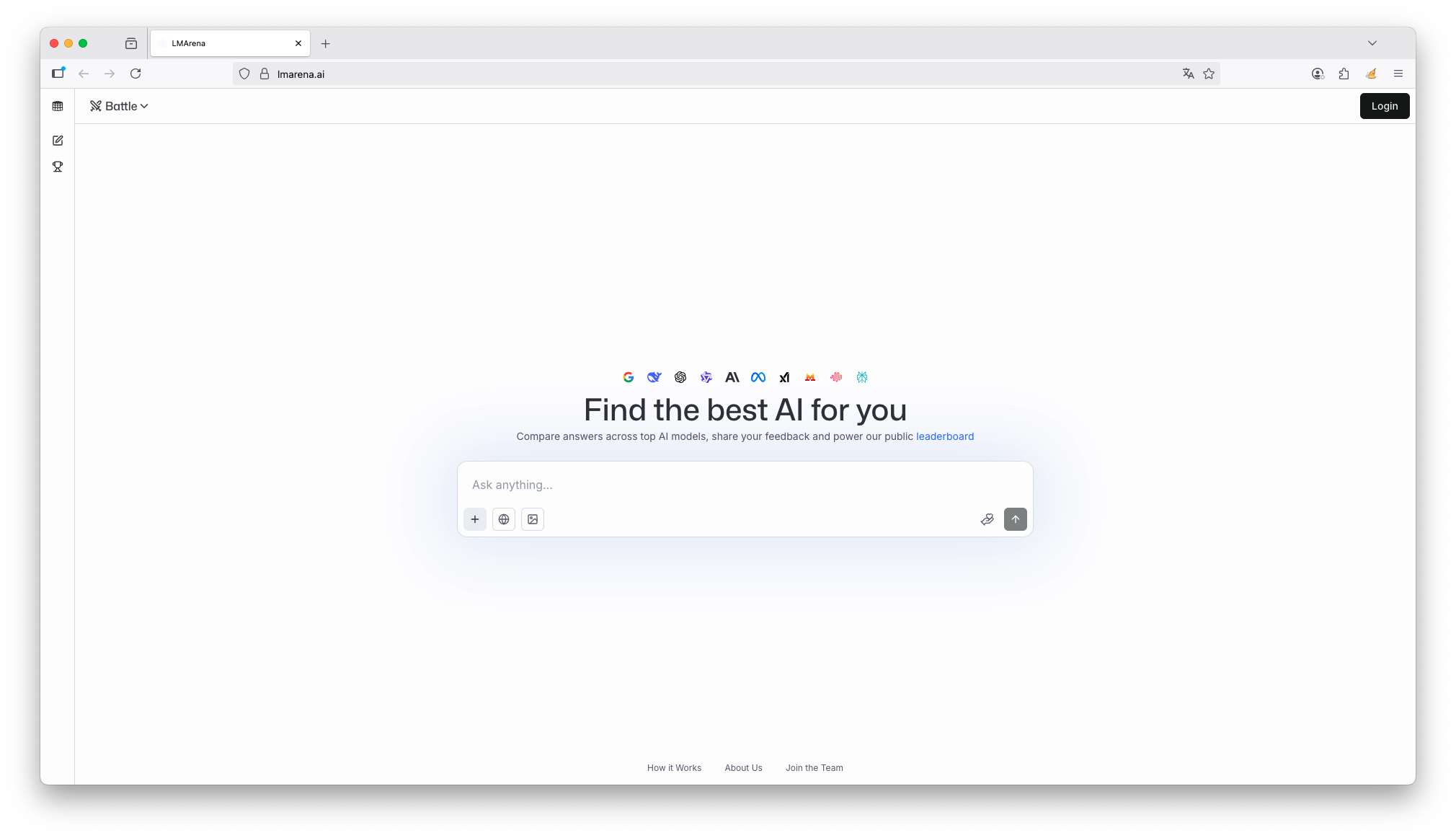

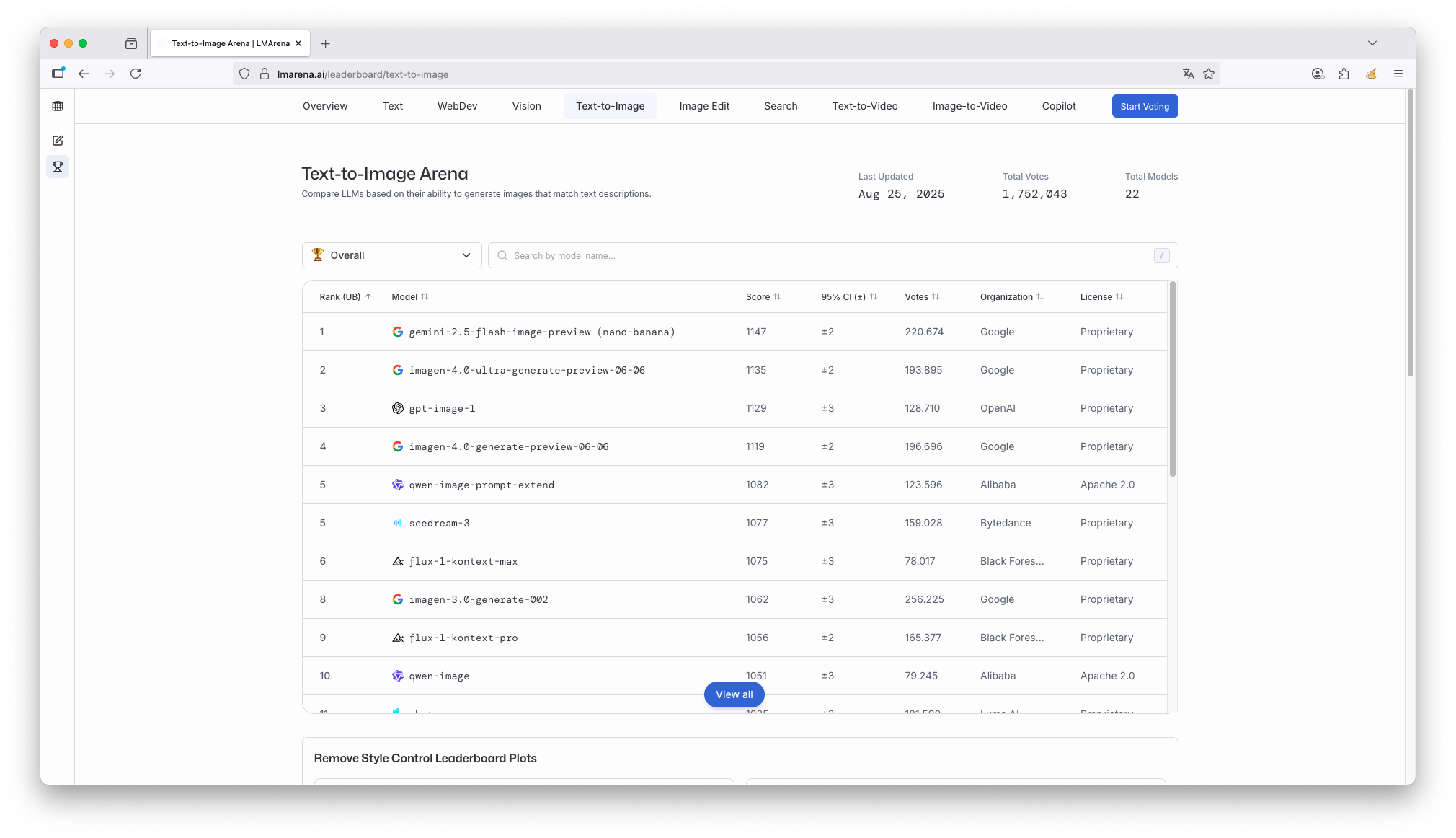

LM Arena

https://lmarena.ai/

Was ist LM Arena?

LM Arena ist eine interaktive Plattform, die es Nutzern ermöglicht, verschiedene große Sprachmodelle (LLMs) wie ChatGPT, Claude, Gemini und viele andere kostenlos und direkt miteinander zu vergleichen.

Man kann sich LM Arena wie eine „Spielwiese“ oder ein „Vergleichsportal“ für KI-Chats vorstellen.

Das Kernprinzip

Du stellst eine Frage (ein „Prompt“).

LM Arena sendet diese Frage gleichzeitig an zwei verschiedene KI-Modelle (z.B. ChatGPT 4 vs. Claude 3).

Du siehst die Antworten beider KIs nebeneinander und kannst sie in Echtzeit vergleichen.

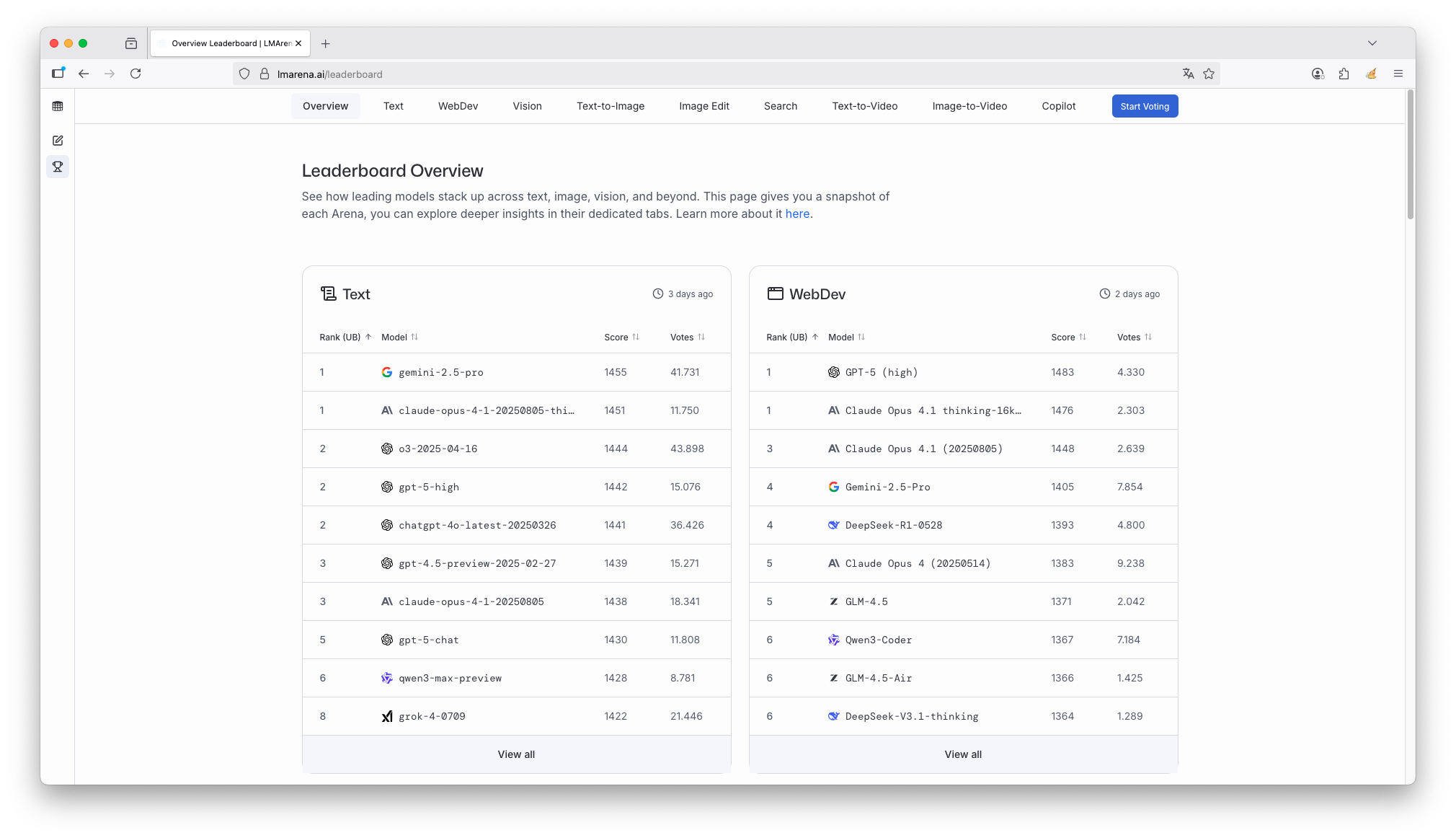

Du stimmst ab, welche Antwort deiner Meinung nach besser war. Diese anonymisierten Nutzerbewertungen speist LM Arena in eine öffentliche Rangliste ein, das „LLM Leaderboard“.

Die wDie wichtigsten Funktionen im Überblick

Kostenloser Zugang: Du brauchst keine eigenen, oft kostenpflichtigen, Accounts für die verschiedenen Modelle.

Side-by-Side-Vergleich: Der direkte Vergleich macht Stärken und Schwächen der verschiedenen Modelle sehr deutlich sichtbar.

Chat-Bereich („Playground“): Du kannst nicht nur einzelne Prompts eingeben, sondern auch ganze Konversationen mit einem Modell deiner Wahl führen.

Community-basiertes Ranking (Leaderboard): Die Rangliste zeigt, welche Modelle von der Community am häufigsten als „besser“ bewertet wurden. Das gibt einen guten Überblick über die aktuelle Leistungsfähigkeit.

Viele Modelle: Neben den bekannten Modellen von OpenAI, Anthropic und Google sind auch viele Open-Source-Modelle wie Llama 3, Mixtral und andere verfügbar.

Wer steckt dahinter?

LM Arena ist ein Projekt von LMSYS Org (Large Model Systems Organization), einem Konsortium aus Forschern der University of California, Berkeley, der University of California, San Diego und der University of Maryland, das von einem Industriekonsortium unterstützt wird.

Warum ist LM Arena wichtig?

Für normale Nutzer: Es ist ein fantastisches Tool, um die Welt der KI-Modelle zu erkunden, ohne sich für einen bestimmten Anbieter entscheiden zu müssen. Man findet schnell heraus, welches Modell für welche Aufgabe (z.B. kreatives Schreiben, Codierung, Analyse) am besten geeignet ist.

Für die Forschung: Die gesammelten Nutzerbewertungen (über 1 Million) sind ein wertvoller Datensatz, um die Modelle unvoreingenommen und auf breiter Basis zu bewerten und weiterzuentwickeln.

Zusammenfassend

LM Arena ist eine kostenlose Benchmarking-Plattform, die einen neutralen und benutzerfreundlichen Vergleich der Leistungsfähigkeit verschiedener großer Sprachmodelle ermöglicht.

AI Modelle lokal Hosten & nutzen

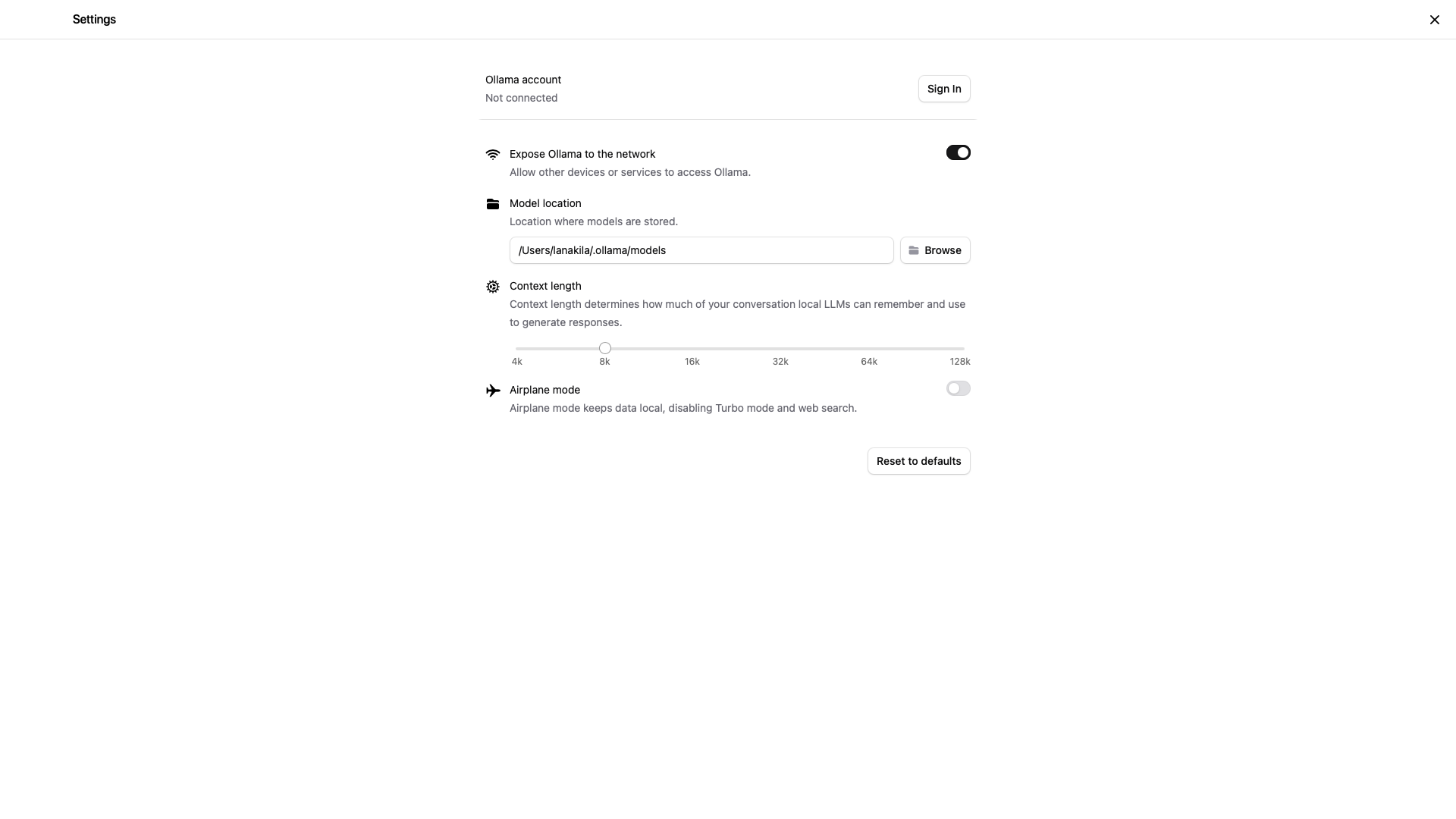

Ollama

https://ollama.com

Ollama hat sich als eine der beliebtesten Lösungen für das lokale Ausführen von Large Language Models (LLMs) etabliert. Mit seiner einfachen CLI und dem unkomplizierten Setup ist es die erste Wahl für viele Entwickler geworden. Du solltest mind. 8 GB RAM für das Ausführen von 7B Modellen (LMM), 16 GB für 13B Modelle und 32 GB für 33B Modelle haben. Ollama unterstützt eine Vielzahl an Sprachmodellen, welche unter https://ollama.com/library zu finden sind.

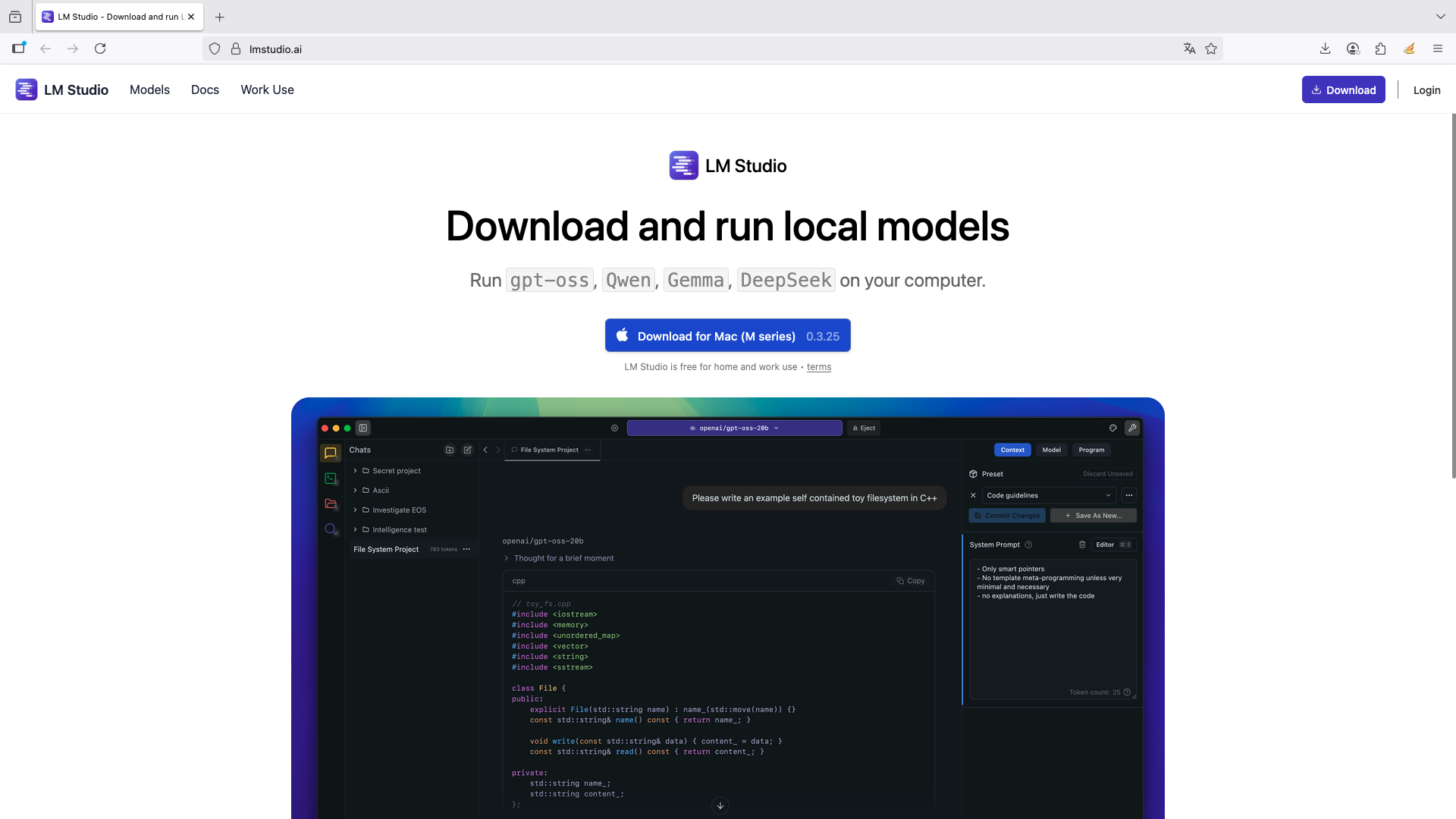

LM Studio

https://lmstudio.ai

LM Studio ist perfekt für alle, die eine grafische Oberfläche (GUI) bevorzugen. Eingebauter Model-Browser: Durchsuche und lade Modelle direkt von Hugging Face herunter. RAG-Support: Ziehe PDFs oder Textdateien per Drag & Drop in die App und stelle Fragen dazu. OpenAI-kompatible API: Nutze LM Studio als Drop-in-Replacement für die OpenAI API. LM Studio eignet sich besonders für: Einsteiger, die ohne technisches Vorwissen mit LLMs arbeiten möchten; Teams, die Wert auf Datenschutz legen und sensible Daten lokal verarbeiten müssen; Windows-Nutzer, die eine native Desktop-Experience suchen

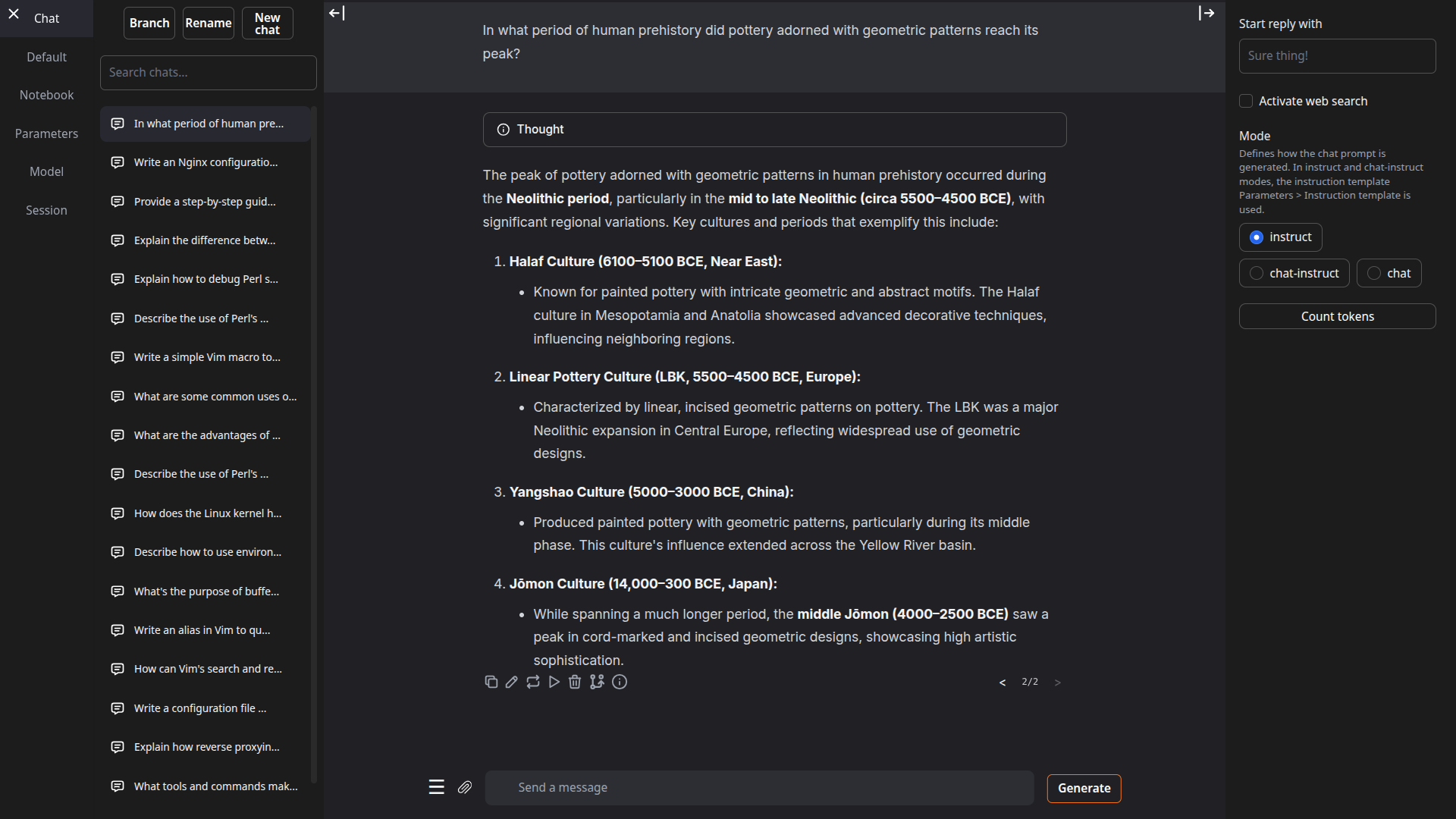

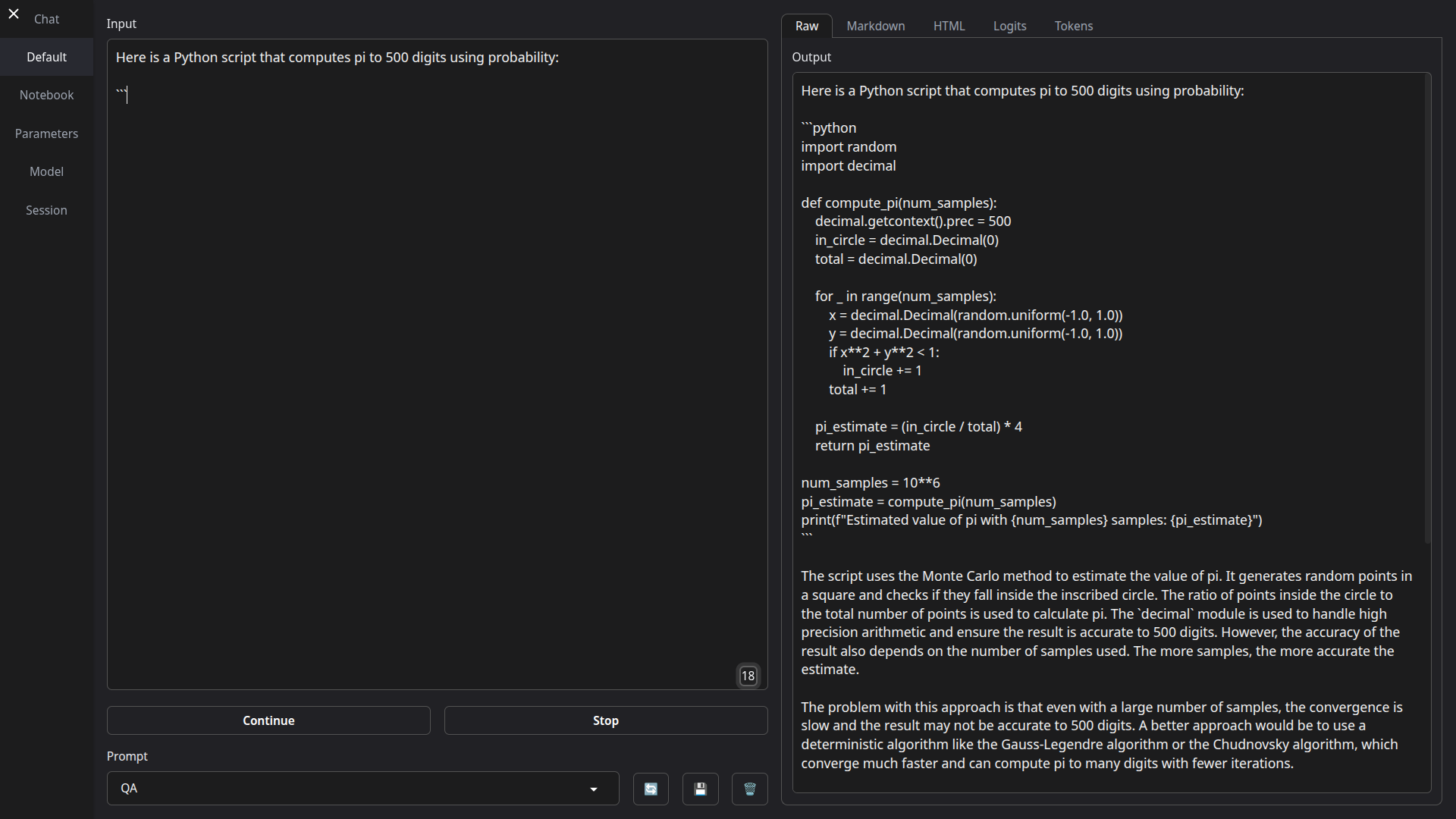

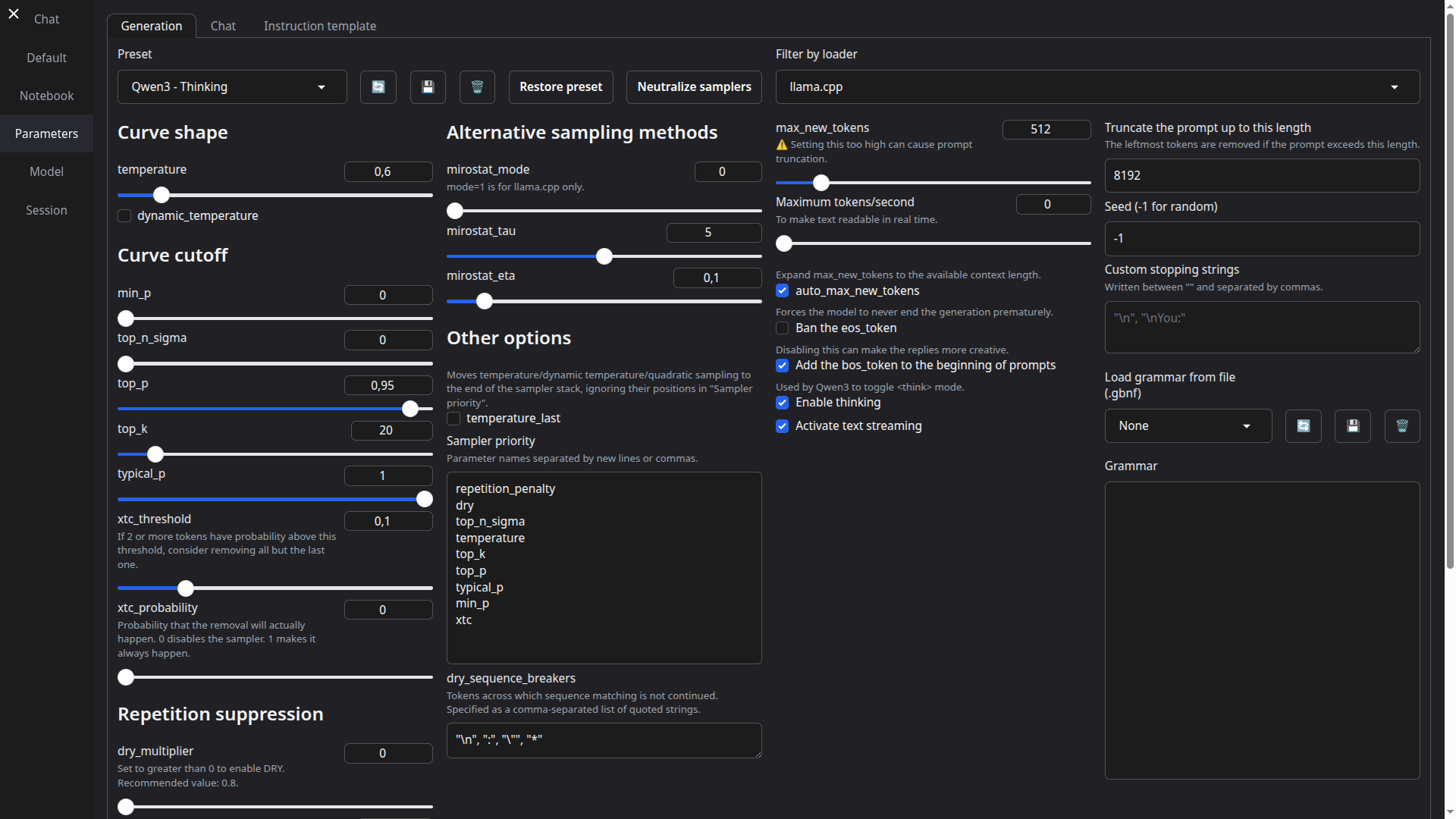

Oobabooga

https://github.com/oobabooga

Diese Open-Source-Webanwendung bietet unglaubliche Flexibilität und Erweiterbarkeit. Multi-Format-Support: Lade Modelle in GGUF, GPTQ, AWQ und vielen anderen Formaten; Erweiterbar durch Plugins: Von Speech-to-Text bis zu Übersetzungen – alles möglich; Character-System: Erstelle eigene Personas und Rollenspiel-Szenarien; Eingebaute RAG-Funktionalität: Lade Dokumente und stelle kontextbezogene Fragen

Open WebUI

https://openwebui.com

Open WebUI ist eine Open-Source-Webanwendung, die entwickelt wurde, um große Sprachmodelle (LLMs) einfach und sicher über eine grafische Weboberfläche zu nutzen. Sie bietet eine Chat-ähnliche Benutzererfahrung im Browser und macht es möglich, KI-Modelle lokal auf eigenen Servern oder Rechnern zu betreiben, anstatt auf externe Cloud-Dienste angewiesen zu sein. Dabei kann Open WebUI mit unterschiedlichen Modell-Backends arbeiten – beispielsweise mit lokal laufenden Modellen über Ollama oder mit Modellen, die über OpenAI-kompatible APIs angebunden sind. Dadurch bleibt man flexibel in der Auswahl und kann verschiedene Modelle parallel testen und vergleichen.

Ein wesentlicher Vorteil von Open WebUI liegt im Bereich Datenschutz und Datensouveränität. Da die Anwendung vollständig offline betrieben werden kann, verlassen sensible Daten nicht das eigene Netzwerk. Das macht sie insbesondere für Unternehmen, Bildungseinrichtungen und öffentliche Institutionen attraktiv, die strenge Datenschutzvorgaben wie die DSGVO erfüllen müssen. Hinzu kommt, dass keine laufenden Abo-Kosten für Cloud-Dienste entstehen, was langfristig Kostenvorteile bietet – vor allem, wenn mehrere Benutzer auf dieselbe lokale Installation zugreifen.

Neben der eigentlichen Chatfunktion bietet Open WebUI zahlreiche Zusatzfunktionen. Dazu gehören das Hochladen und Verarbeiten eigener Dokumente, Retrieval-Augmented Generation (RAG) zur besseren Kontextnutzung, Modellverwaltung, Unterstützung mehrerer Nutzer und die Integration unterschiedlicher LLMs. So lässt sich etwa ein interner Chatbot aufbauen, der Unternehmensdokumente analysiert oder Fragen auf Basis eigener Daten beantwortet.

Trotz dieser Vorteile erfordert der Einsatz von Open WebUI ein gewisses technisches Verständnis.

AnythingLMM

https://anythingllm.com

AnythingLLM ist eine Open-Source-Anwendung von Mintplex Labs, die entwickelt wurde, um große Sprachmodelle (LLMs) flexibel und datenschutzfreundlich zu nutzen. Die Plattform erlaubt es, verschiedene Sprachmodelle – sowohl lokal ausgeführte wie Ollama oder LMStudio als auch Cloud-basierte – miteinander zu verbinden. Nutzer können eigene Dokumente, etwa PDFs, Word- oder CSV-Dateien, hochladen und anschließend über eine Chatoberfläche direkt mit ihren Inhalten interagieren, Fragen stellen oder Zusammenfassungen generieren.

Ein zentrales Merkmal von AnythingLLM ist die Nutzung von Retrieval-Augmented Generation (RAG). Dabei werden relevante Informationen aus hochgeladenen Dokumenten oder Vektordatenbanken abgerufen, um dem Sprachmodell den passenden Kontext zu liefern. Dies verbessert die Genauigkeit der Antworten deutlich. Die Plattform unterstützt dabei verschiedene Vektor-Datenbanken wie Milvus, Weaviate oder LanceDB und ermöglicht damit eine effiziente semantische Suche innerhalb eigener Daten.

Ein großer Vorteil liegt in der lokalen Ausführung: AnythingLLM kann vollständig auf dem eigenen Rechner betrieben werden, ohne dass Daten an externe Server gesendet werden. Das macht die Lösung besonders attraktiv für Organisationen oder Einzelpersonen, die Wert auf Datenschutz und Unabhängigkeit von Cloud-Diensten legen. Neben der Desktop-Variante für Einzelanwender gibt es auch Server- und Team-Versionen, die für mehrere Nutzer geeignet sind.

Insgesamt bietet AnythingLLM eine flexible, anpassbare Umgebung, um mit eigenen Daten und unterschiedlichen Sprachmodellen zu arbeiten – ideal für Unternehmen, Forschungseinrichtungen oder Privatpersonen, die KI-gestützte Informationsverarbeitung selbstbestimmt und sicher gestalten möchten.

Hugging Face

https://huggingface.co

Was ist Hugging Face?

Hugging Face ist das „GitHub für KI“, speziell für Machine Learning (ML) und Natural Language Processing (NLP). Es ist eine zentrale Plattform, auf der die Gemeinschaft:

Tausende von vortrainierten Modellen (z.B. für Text, Audio, Bild, Video) teilt und herunterlädt.

DatenSets für das Training von Modellen findet.

Code in Form von Bibliotheken (wie

transformers) und Beispiel-Notebooks bereitstellt.Anwendungen direkt im Browser testen und teilen kann (Spaces).

Der Name ist eine Anspielung auf den „Hugging Face“-Emoji 🤗 und soll die freundliche und einladende Gemeinschaft widerspiegeln.

Ausführliche Erklärung

Alles begann mit der Open-Source-Bibliothek namens transformers. Diese Bibliothek, entwickelt von Hugging Face, machte es extrem einfach, modernste NLP-Modelle (wie BERT, GPT-2, T5) zu nutzen und zu trainieren. Statt hunderte Zeilen Code für jedes Modell schreiben zu müssen, reichen mit transformers oft nur wenige Zeile.

Beispiel: Einen Text zusammenzufassen wird so einfach wie:

from transformers import pipeline zusammenfasser = pipeline("summarization") zusammenfasser("Langer Text hier...")

Die Bibliothek wurde enorm populär und zog eine große Community an. Die Plattform huggingface.co entstand als natürliche Erweiterung, um die Modelle und Daten, die die Community erstellte, zu teilen.

Der Hugging Face Hub – Das Herzstück

Der Hub ist der zentrale Ort auf der Website, an dem alles zusammenläuft. Man kann ihn sich wie eine riesige Bibliothek vorstellen, die drei Hauptdinge beherbergt:

Model Hub: Eine ungeheure Sammlung von über 500.000 vortrainierten Modellen. Diese reichen von Text-Modellen für Übersetzung, Beantwortung von Fragen und Textgenerierung bis hin zu Modellen für Bilderkennung, Audioverarbeitung und mehr. Jeder kann sein trainiertes Modell hochladen und mit der Welt teilen.

Dataset Hub: Hier finden sich tausende von Datensätzen für alle möglichen ML-Aufgaben. Ohne gute Daten gibt es keine guten Modelle – dieser Hub löst das Problem der Datensuche.

Spaces: Das vielleicht coolste Feature für Einsteiger. Spaces erlaubt es, KI-Anwendungen (Demo-Apps) direkt im Browser zu erstellen und zu hosten. Man kann z.B. eine einfache Web-Oberfläche für sein Textgenerierungsmodell bauen, die jeder sofort ausprobieren kann, ohne Code zu schreiben. Dies wird oft mit Gradio oder Streamlit gebaut.

Für wen ist Hugging Face?

Forscher & Experten: Teilen ihre neuesten Modelle und vergleichen sich mit dem State-of-the-Art.

Entwickler: Integrieren vorgefertigte KI-Modelle mit wenigen Codezeilen in ihre eigenen Apps, ohne bei Null anfangen zu müssen.

Unternehmen: Nutzen die Infrastruktur von Hugging Face (z.B. Inference Endpoints), um Modelle in der Produktion zu deployen und zu skalieren.

Studenten & Einsteiger: Experimentieren und lernen mit state-of-the-art-Modellen, ohne teure Hardware zu besitzen. Die Demos in den Spaces sind perfekt, um zu verstehen, was möglich ist.

Das Geschäftsmodell

Hugging Face bietet seine Kernfeatures (Hosting von öffentlichen Modellen, Spaces, Bibliotheken) kostenlos an. Geld verdient das Unternehmen durch:

Enterprise Hub: Private Hubs für Unternehmen, in denen Teams sicher und intern an Modellen und Daten arbeiten können.

Inference API: Bezahlter Zugriff auf schnelle und skalierbare APIs, um Modelle in Echtzeit anzufragen.

Trainings-Services: Unterstützung beim Training und Feinabstimmung von Modellen auf enterprise-grade Hardware.

Zusammenfassung der Vorteile

| Feature | Vorteil |

|---|---|

transformers-Bibliothek | Vereinfacht die Nutzung von modernsten ML-Modellen enorm. |

| Model Hub | Muss das Rad nicht neu erfinden. Wiederverwenden, was andere gebaut haben. |

| Dataset Hub | Schneller Zugang zu hochwertigen Daten. |

| Spaces | Einfache Möglichkeit, Modelle zu demonstrieren und zu teilen. |

| Community | Zentrale Anlaufstelle für den Wissensaustausch in der KI-Community. |

Fazit: Hugging Face hat sich durch seine benutzerfreundlichen Tools und seine offene Philosophie zur unverzichtbaren Plattform für die KI-Community entwickelt. Sie demokratisiert den Zugang zu modernster KI, indem sie die Eintrittsbarrieren senkt und Zusammenarbeit fördert.

Coding Agents / Für Entwickler

Replit

https://replit.com

Replit ist eine Online-Plattform, auf der man direkt im Browser programmieren kann. Sie unterstützt viele Programmiersprachen wie Python, JavaScript, C++ oder HTML und bietet eine integrierte Entwicklungsumgebung mit Editor, Terminal und Debugger. Nutzer können ihren Code sofort ausführen, speichern und mit anderen teilen, was gemeinsames Arbeiten an Projekten besonders einfach macht. Alle Projekte, sogenannte „Repls“, werden automatisch in der Cloud gespeichert. Replit eignet sich sowohl zum Lernen als auch zum schnellen Erstellen von Prototypen. Mit dem integrierten KI-Assistenten „Ghostwriter“ hilft die Plattform außerdem beim Schreiben und Verstehen von Code. Es gibt eine kostenlose Basisversion sowie kostenpflichtige Pläne mit erweiterten Funktionen.

KIRO

https://kiro.dev

Kiro ist eine moderne Entwicklungsumgebung („AI IDE“), die Entwicklern hilft, von der Idee bis zur Produktion mithilfe von KI-Agenten zu gelangen. Anstatt einfach nur Code zu generieren, wandelt Kiro freie Eingaben in strukturierte Spezifikationen („Specs“), technische Designs und konkrete Aufgaben um.

Die Plattform bietet Funktionen wie Agenten, die auf bestimmte Ereignisse (z. B. Datei-Speicherungen) reagieren, automatische Erstellung von Unit-Tests, Dokumentation oder Performance-Optimierung via sogenannter Hooks. Kiro kann bestehende Projekte übernehmen oder neue starten und erlaubt Import von Einstellungen aus bekannten Editoren wie Visual Studio Code. Es unterstützt mehrere Betriebssysteme (Windows, macOS, Linux) und viele Programmiersprachen.

FRAGEN?

Du hast Fragen, Anregungungen oder möchtest wissen, wie du KI-Agenten in deiner Umgebung einsetzen kannst?